Un par de resultados recientes hablan de la relación entre el Universo y la computación.

La ciencia ficción ha propuesto reiteradas veces que podría ser

posible que fuéramos una simulación en un ordenador. Esta idea ya se

había propuesto antes de que se estrenara Matrix, que obviamente bebe de

las fuentes de Philip K. Dick.

Según esta idea todo los que nos rodea nos rodea: la Tierra, el Sistema Solar, la Vía Láctea y todo el Universo, no sería más que una simulación en un computador que algo parecido a unos dioses tendrían en algún lado. Toda la historia de la humanidad, sus logros o sus obras serían el subproducto de una gran simulación computacional. Nuestros sentimientos, pasiones, mezquindades, buenas obras y los hallazgos de la ciencia también serían unas cadenas de bits en frenética combinación entre sí. Todo el Universo duraría hasta que alguien al otro lado apretara el botón de reset y entonces toda nuestra existencia caería por completo en el más absoluto olvido.

Pero una cosa es lo que dice la ciencia ficción y otra lo que dice la ciencia. La realidad es que nosotros no podemos simular más que una pequeña parte del Universo en nuestros computadores. Simular todo el Universo se antoja imposible. Quizás podremos algún día simular un universo alternativo menos ambicioso, pero no el nuestro. No tenemos suficientes átomos en el Universo para simular la autoorganización de todos los átomos del propio Universo. Si nos vamos a la escala de lo muy pequeño ni siquiera podemos simular la estructura del propio espacio-tiempo, pues incluso carecemos de una teoría para ello. A lo más podemos hacer algunas simulaciones en el retículo de la Cromodinámica Cuántica, que nos proporciona predicciones de cómo se organizar los quarks entre sí. Y estas simulaciones sólo llegan el femtometro de tamaño.

Hace unas semanas hubo cierto revuelo en la blogosfera sobre un artículo publicado en los ArXiv por parte de Silas Beane, de la Universidad de Bonn (Alemania), y sus colaboradores. Según estos teóricos se podían encontrar pruebas de que el Universo es una simulación, aunque tampoco aseguraban que así fuera.

Un problema que surge con esta idea de la simulación es que las leyes de la Física parecen vivir en un continuo en lugar de en un espacio discreto. Si fuéramos una simulación tendrían que ser lo segundo, tendríamos que ver los “píxeles” o los “bits” que componen la “realidad” a algún nivel.

Beane imaginó que si a cierto nivel hay una discretización entonces debe de tener un efecto en lo que observamos en el Universo, sobre todo en los procesos muy energéticos. Si nos fijamos un poco es similar a la idea, menos esotérica, de ver la estructura del espacio-tiempo a la escala de Planck usando fotones gamma y midiendo diferencias en su tiempo de vuelo a lo largo de grandes distancias. En este caso el efecto se debería a que ninguna partícula o efecto puede ser menor que la celda unidad de la simulación.

Estos investigadores especularon que si el Universo es una simulación entonces debe de haber un corte en el espectro de energía de las partículas de alta energía. Ese límite existe y se llama Greisen–Zatsepin–Kuzmin (GZK), pero es atribuido a la interacción de los rayos cósmicos ultraenergéticos con los fotones del fondo cósmico de microondas, de tal modo que, en su viaje por el Universo, las partículas de rayos cósmicos más energéticas van perdiendo energía y al medir su energía nunca encontramos que superen el límite GZK.

Pero estos investigadores asumieron que si el Universo es una simulación y el retículo de simulación está compuesto por celdas cúbicas entonces habrá una anisotropía en este efecto. No sería lo mismo que una partícula viajase en la simulación en dirección a las caras de cada cubo que en dirección hacia las esquinas. Esto afectaría a los rayos cósmicos que medimos, pues tendrían una dirección de propagación preferente a través de las caras de los cubos. Esto podría ser medido.

Sin embargo, la idea presenta un par de problemas. Uno es que los semidioses que nos simulan pueden haber elegido un retículo distinto al cúbico, quizás hexagonal o triangular. El otro problema es que si la idea es cierta y el límite GZK corresponde a este fenómeno, entonces el tamaño de cada celda del retículo es increíblemente pequeño, en concreto de 10-27 metros.

Obviamente este tipo de cosas no se plantean seriamente (pese a lo que dicen los autores en su artículo) y son más bien un divertimento de físicos teóricos, aunque sirven para pensar sobre problemas fundamentales. Y, como los filósofos ya solucionaron en el pasado, si somos una simulación y ésta es tan buena que es indistinguible de la “realidad” entonces no importa y la simulación es tan “real” como deseemos que sea.

Pero si no somos una simulación quizás podamos creer en algo menos drástico. Quizás el Universo en sí mismo es un gran computador. Según esta visión, dado un estado inicial determinado como input, el Universo genera estados futuros como outputs de una simulación. Esta idea se ha propagado por ciertos ámbitos sin que se haya considerado su validez o se hayan tenido en cuenta otras alternativas. Es meramente una asunción que uno debería cuestionar.

Ahora Ken Wharton, de San Jose State University (California), ha escrito un artículo en el que desafía esta idea. Según él esta hipótesis es muy antropocéntrica y asume que el Universo funciona de la misma manera que los humanos resolvemos problemas en la Física.

Entre los problemas que Wharton ve a esta idea está el que para computar el mundo físico primero hay que hacer una correspondencia entre su estado y un estado matemático que es el que se va a computar. Luego ese estado matemático evoluciona hacia otro estado y este nuevo estado se pone en correspondencia con el mundo físico. Pero esto no está permitido por la Mecánica Cuántica a no ser que asumamos que el estado final es probabilístico. Ni siquiera el Universo conoce que estado particular va a adoptar. Además, cuando el Universo es medido se produce un output específico por el mismo acto de medición y un computador clásico no puede tener en cuenta esto.

Quizás lo más interesante de este pensamiento es que las leyes que gobiernan el Universo no pueden expresarse en términos computacionales.

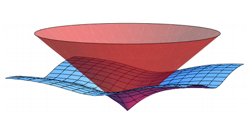

Wharton propone una hipótesis alternativa basada en la idea de Lagrange según la cual las leyes físicas están basadas en el principio de mínima acción.

Así por ejemplo cuando una haz de luz se refracta la pasar del aire al agua, no lo hace por algún tipo de algoritmo, sino porque es el modo más eficiente de propagarse. La trayectoria entre el punto inicial y final unidos por ese haz de luz sería la distancia más corta entre esos dos puntos de entre todas las posibles.

Lo malo es que puede que el Universo tampoco funcione bajo el principio de mínima acción, pues éste no es más que un buen truco que hemos encontrado para resolver ciertos problemas en Física. Además de ser una idea ingenua con la que trabajar.

De todos modos, la idea básica de Wharton de desafiar la hipótesis del Universo como un computador es buena y, sobre todo, esperemos que dé pie a otras alternativas mejores. Al fin y al cabo, es así como funciona la ciencia, sobre todo si esas nuevas ideas se pueden contrastar con la realidad de algún modo.

Yace un problema epistemológico en esa dicotomía entre modelos de realidad y realidad, entre simulaciones de realidad y la realidad, entre lo que sabemos sobre la realidad y la realidad misma, entre una mente perteneciente a la realidad pensando sobre la realidad a la que pertenece o entre un computador físico simulando una parte de la realidad a la que él mismo pertenece. Por no saber no sabemos la relación real entre Matemáticas y realidad, ¿son éstas simplemente una herramienta o tienen alguna correspondencia con la propia realidad? Ya sólo nos quedaría sacar a colación a Gödel y Turing.

Copyleft: atribuir con enlace a http://neofronteras.com/?p=3982

Fuentes y referencias:

Artículo en ArXiv.

Artículo en ArXiv.

|

Según esta idea todo los que nos rodea nos rodea: la Tierra, el Sistema Solar, la Vía Láctea y todo el Universo, no sería más que una simulación en un computador que algo parecido a unos dioses tendrían en algún lado. Toda la historia de la humanidad, sus logros o sus obras serían el subproducto de una gran simulación computacional. Nuestros sentimientos, pasiones, mezquindades, buenas obras y los hallazgos de la ciencia también serían unas cadenas de bits en frenética combinación entre sí. Todo el Universo duraría hasta que alguien al otro lado apretara el botón de reset y entonces toda nuestra existencia caería por completo en el más absoluto olvido.

Pero una cosa es lo que dice la ciencia ficción y otra lo que dice la ciencia. La realidad es que nosotros no podemos simular más que una pequeña parte del Universo en nuestros computadores. Simular todo el Universo se antoja imposible. Quizás podremos algún día simular un universo alternativo menos ambicioso, pero no el nuestro. No tenemos suficientes átomos en el Universo para simular la autoorganización de todos los átomos del propio Universo. Si nos vamos a la escala de lo muy pequeño ni siquiera podemos simular la estructura del propio espacio-tiempo, pues incluso carecemos de una teoría para ello. A lo más podemos hacer algunas simulaciones en el retículo de la Cromodinámica Cuántica, que nos proporciona predicciones de cómo se organizar los quarks entre sí. Y estas simulaciones sólo llegan el femtometro de tamaño.

Hace unas semanas hubo cierto revuelo en la blogosfera sobre un artículo publicado en los ArXiv por parte de Silas Beane, de la Universidad de Bonn (Alemania), y sus colaboradores. Según estos teóricos se podían encontrar pruebas de que el Universo es una simulación, aunque tampoco aseguraban que así fuera.

Un problema que surge con esta idea de la simulación es que las leyes de la Física parecen vivir en un continuo en lugar de en un espacio discreto. Si fuéramos una simulación tendrían que ser lo segundo, tendríamos que ver los “píxeles” o los “bits” que componen la “realidad” a algún nivel.

Beane imaginó que si a cierto nivel hay una discretización entonces debe de tener un efecto en lo que observamos en el Universo, sobre todo en los procesos muy energéticos. Si nos fijamos un poco es similar a la idea, menos esotérica, de ver la estructura del espacio-tiempo a la escala de Planck usando fotones gamma y midiendo diferencias en su tiempo de vuelo a lo largo de grandes distancias. En este caso el efecto se debería a que ninguna partícula o efecto puede ser menor que la celda unidad de la simulación.

Estos investigadores especularon que si el Universo es una simulación entonces debe de haber un corte en el espectro de energía de las partículas de alta energía. Ese límite existe y se llama Greisen–Zatsepin–Kuzmin (GZK), pero es atribuido a la interacción de los rayos cósmicos ultraenergéticos con los fotones del fondo cósmico de microondas, de tal modo que, en su viaje por el Universo, las partículas de rayos cósmicos más energéticas van perdiendo energía y al medir su energía nunca encontramos que superen el límite GZK.

Pero estos investigadores asumieron que si el Universo es una simulación y el retículo de simulación está compuesto por celdas cúbicas entonces habrá una anisotropía en este efecto. No sería lo mismo que una partícula viajase en la simulación en dirección a las caras de cada cubo que en dirección hacia las esquinas. Esto afectaría a los rayos cósmicos que medimos, pues tendrían una dirección de propagación preferente a través de las caras de los cubos. Esto podría ser medido.

Sin embargo, la idea presenta un par de problemas. Uno es que los semidioses que nos simulan pueden haber elegido un retículo distinto al cúbico, quizás hexagonal o triangular. El otro problema es que si la idea es cierta y el límite GZK corresponde a este fenómeno, entonces el tamaño de cada celda del retículo es increíblemente pequeño, en concreto de 10-27 metros.

Obviamente este tipo de cosas no se plantean seriamente (pese a lo que dicen los autores en su artículo) y son más bien un divertimento de físicos teóricos, aunque sirven para pensar sobre problemas fundamentales. Y, como los filósofos ya solucionaron en el pasado, si somos una simulación y ésta es tan buena que es indistinguible de la “realidad” entonces no importa y la simulación es tan “real” como deseemos que sea.

Pero si no somos una simulación quizás podamos creer en algo menos drástico. Quizás el Universo en sí mismo es un gran computador. Según esta visión, dado un estado inicial determinado como input, el Universo genera estados futuros como outputs de una simulación. Esta idea se ha propagado por ciertos ámbitos sin que se haya considerado su validez o se hayan tenido en cuenta otras alternativas. Es meramente una asunción que uno debería cuestionar.

Ahora Ken Wharton, de San Jose State University (California), ha escrito un artículo en el que desafía esta idea. Según él esta hipótesis es muy antropocéntrica y asume que el Universo funciona de la misma manera que los humanos resolvemos problemas en la Física.

Entre los problemas que Wharton ve a esta idea está el que para computar el mundo físico primero hay que hacer una correspondencia entre su estado y un estado matemático que es el que se va a computar. Luego ese estado matemático evoluciona hacia otro estado y este nuevo estado se pone en correspondencia con el mundo físico. Pero esto no está permitido por la Mecánica Cuántica a no ser que asumamos que el estado final es probabilístico. Ni siquiera el Universo conoce que estado particular va a adoptar. Además, cuando el Universo es medido se produce un output específico por el mismo acto de medición y un computador clásico no puede tener en cuenta esto.

Quizás lo más interesante de este pensamiento es que las leyes que gobiernan el Universo no pueden expresarse en términos computacionales.

Wharton propone una hipótesis alternativa basada en la idea de Lagrange según la cual las leyes físicas están basadas en el principio de mínima acción.

Así por ejemplo cuando una haz de luz se refracta la pasar del aire al agua, no lo hace por algún tipo de algoritmo, sino porque es el modo más eficiente de propagarse. La trayectoria entre el punto inicial y final unidos por ese haz de luz sería la distancia más corta entre esos dos puntos de entre todas las posibles.

Lo malo es que puede que el Universo tampoco funcione bajo el principio de mínima acción, pues éste no es más que un buen truco que hemos encontrado para resolver ciertos problemas en Física. Además de ser una idea ingenua con la que trabajar.

De todos modos, la idea básica de Wharton de desafiar la hipótesis del Universo como un computador es buena y, sobre todo, esperemos que dé pie a otras alternativas mejores. Al fin y al cabo, es así como funciona la ciencia, sobre todo si esas nuevas ideas se pueden contrastar con la realidad de algún modo.

Yace un problema epistemológico en esa dicotomía entre modelos de realidad y realidad, entre simulaciones de realidad y la realidad, entre lo que sabemos sobre la realidad y la realidad misma, entre una mente perteneciente a la realidad pensando sobre la realidad a la que pertenece o entre un computador físico simulando una parte de la realidad a la que él mismo pertenece. Por no saber no sabemos la relación real entre Matemáticas y realidad, ¿son éstas simplemente una herramienta o tienen alguna correspondencia con la propia realidad? Ya sólo nos quedaría sacar a colación a Gödel y Turing.

Copyleft: atribuir con enlace a http://neofronteras.com/?p=3982

Fuentes y referencias:

Artículo en ArXiv.

Artículo en ArXiv.

Salvo que se exprese lo contrario esta obra está bajo una licencia Creative Commons.

No hay comentarios:

Publicar un comentario