Fuente: El mono mudo

Diálogos varios

- “Doctor, ¿cuántas autopsias ha realizado usted sobre personas fallecidas?”

- “Todas mis autopsias las realicé sobre personas fallecidas”

- “Cada una de sus respuestas debe ser verbal, ¿de acuerdo?” “¿A qué escuela fue usted?”

- “Verbal” (Risas y comentarios jocosos en la sala)

- “¿Recuerda usted la hora a la que examinó el cadáver?”

- “Sí, la autopsia comenzó alrededor de las 8:30 p.m.”

- “¿Mr. Dennington estaba muerto en ese momento?”

- “No, estaba sentado en la mesa preguntándose por que estaba yo haciéndole una autopsia.” (El Sr. Juez tiene que imponer orden en la sala, el alboroto es tremendo, se escuchan carcajadas por todas partes)

Le dispararon en medio del follón?”

- “No, me dispararon entre el follón y el ombligo.”

- “Doctor, ¿antes de realizar la autopsia, verificó si había pulso?”

- “No”

- “¿Verificó la presión sanguínea?”

- “No”

- “¿Verificó si había respiración?”

- “No”

- “¿Entonces, es posible que el paciente estuviera vivo cuando usted comenzó la autopsia?”

- “No”

- “¿Cómo puede usted estar tan seguro, Doctor?”

- “Porque su cerebro estaba sobre mi mesa, en un tarro”

- “¿Pero podría, no obstante, haber estado aún vivo el paciente?”

- “Es posible que hubiera estado vivo y ejerciendo de abogado en alguna corte.”

- ¿Puede usted describir al individuo?

- Sí, era alto y usaba barba.

- ¿Y era hombre o mujer?

- ¿Como terminó su primer matrimonio?

- Por la muerte.

- ¿Por la muerte de quién?

- ¿Alguna vez durmió con él en Nueva York?

- Me rehuso a contestar esa pregunta.

- ¿Alguna vez durmió con él en Chicago?

- Me rehuso a contestar esa pregunta.

- ¿Alguna vez durmió con él en Miami?

- No.

- Esta “miastenia gravis”, ¿afecta de alguna forma su memoria?

- Sí.

- ¿Y de qué forma la afecta?

- Olvido cosas.

- Olvida cosas. ¿Puede darnos un ejemplo de algo que se haya olvidado?

- Agente, cuando detuvo a la acusada, ¿tenía las luces azules y rojas encendidas?

- Sí.

- ¿Y la acusada dijo algo cuando salió del auto?

- Sí.

- ¿Qué dijo?

- “¿En qué discoteca estoy?”

- Entonces la fecha en que su bebé fue concebido es el 8 de agosto.

- Sí.

- ¿Y qué estaba haciendo usted en ese momento? – Dijo que las escaleras bajaban hacia el sótano, ¿correcto?

- Sí.

- Y esas escaleras, ¿también subían?

Preguntas sagaces

- “¿Estaba usted presente cuando le tomaron la foto?”

- “¿A qué distancia estaban uno del otro los vehículos en el momento de la colisión?”

- “Usted estuvo allí hasta el momento en que salió, ¿es eso cierto?”

- “Entonces, ¿cuántas veces ha cometido usted suicidio?”

- “¿Es cierto, doctor, que cuando una persona muere en el momento del sueño, no llega a saberlo hasta la mañana siguiente?”

- “¿Estaba usted solo, o era el único?”

- “¿Fue usted, o su hermano menor, quien murió en la guerra?”

- “¿El le mató a usted?”

- “Estuvo allí hasta que se fue, ¿no es así?”

| |

|

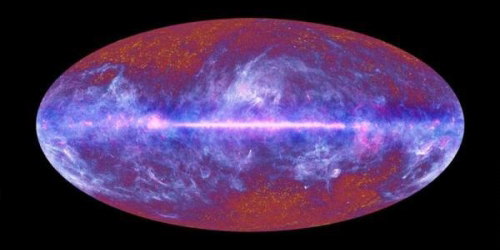

Según el Universo se expandía y enfriaba y la densidad disminuía estas reacciones nucleares dejaron de darse. Cuando se enfrió aún más, los electrones se asociaron a los núcleos que había para formar átomos neutros y el Universo se hizo transparente por primera vez. A esta etapa se la llama recombinación.

La cantidad de hidrógeno, deuterio y helio que hay en el Universo se pueden medir y sus proporciones encajan con las predicciones del modelo de Big Bang. Conforme el Universo envejezca las estrellas habrán destruido casi todo el deuterio y producido suficiente helio como para esta prueba de la existencia del Big Bang desaparezca.

Pero en todo esto hay una pequeña excepción: el problema del litio. Al parecer la cantidad de litio 7 (el isótopo más común de este elemento) que hay en el Universo es menor de la que debería haber. Este problema ha intrigado a los científicos durante más de una década. Ahora parece que algunos han encontrado una nueva explicación: la presencia de axiones en el Universo primitivo habría cambiado la proporción de litio 7. Esta explicación también supone otra solución al problema de la materia oscura, pues ésta estaría constituida por axiones, partículas que, de momento, son sólo hipotéticas.

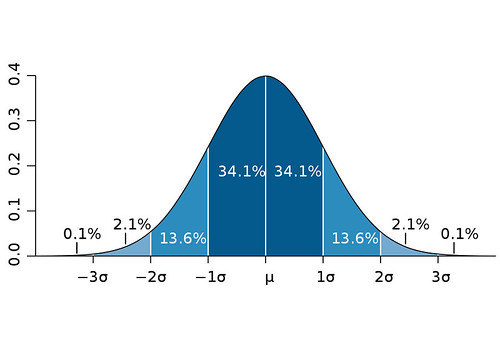

A partir de las fluctuaciones en el fondo cósmico de microondas los cosmólogos pueden inferir la proporción entre bariones (protones, neutrones, etc) y fotones. Es precisamente la razón entre bariones y fotones la que permite predecir la abundancia de elementos ligeros primordiales creados durante el Big Bang. Pero para el litio 7 la predicción arroja una abundancia tres veces superior a la cantidad real observada.

Aunque se han propuesto varias teorías para explicar esta contradicción, ninguna parece ser plenamente satisfactoria. Ahora, Pierre Sikivie, de la Universida de Florida, y sus colaboradores proponen una nueva explicación. Según esta nueva teoría la presencia de axiones habría alterado la producción de litio 7.

Los axiones son unas partículas hipotéticas que fueron propuestas en los setenta para resolver ciertos problemas con la simetría CP. En concreto se propusieron como parte de una teoría que explicase por qué la fuerza nuclear fuerte, a diferencia de otras, no cambia cuando en las reacciones se sustituyen las partículas por sus antipartículas y se observan especularmente.

Todavía los axiones (si es que existen) no han sido detectados porque interaccionarían débilmente con la materia ordinaria. Desde hace un tiempo se les ha propuesto como constituyentes de la famosa materia oscura, pero no son los candidatos favoritos.

Estos investigadores han señalado un punto que hasta ahora se había pasado por alto: los axiones podrían formar condensados de Bose-Einstein. Estos condensados se producen cuando un grupo de partículas de spin entero (bosones) caen en el estado de mínima energía. A diferencia de fermiones (partículas de spin semientero) pueden todas ocupar el mismo estado cuántico, sólo hace falta que la temperatura sea los suficientemente baja.

La temperatura de transición a la que se forma el condensado depende de la densidad, de tal modo que a altas densidades la temperatura puede ser relativamente alta. Según estos investigadores los axiones podrían formar condensados incluso a las altas temperaturas posteriores al Big Bang, cuando se daba la nucleosíntesis primordial.

Los condensados de axiones afectarían las predicciones sobre la nucleosíntesis. Los fotones transferirían calor a los condensados haciendo que disminuyera el número de fotones y, por tanto, cambiaría la razón entre bariones y fotones, dando a los cosmólogos una falsa impresión sobre la cantidad de litio que se debería haber creado.

La teoría no es definitiva y requiere (además de los axiones en sí) solventar problemas relativos a la producción de deuterio y la cantidad de neutrinos efectivos.

Quizás, cuando los del equipo de la misión Planck tengan a bien y liberen los datos que tienen, se pueda medir mejor la cantidad de neutrinos entre otras cosas. Se especula que esto podría suceder en 2013. También podría suceder que, si los axiones existen, el experimento ADMX mejorado los pudiera detectar o incluso puede que se detecten en el LHC.

Copyleft: atribuir con enlace a http://neofronteras.com/?p=3754

Fuentes y referencias:

Noticia en Physics World.

Artículo original.

Artículo en ArXiv.