La química no entiende de ética,

ni de moral; no es buena ni tampoco mala. La química es química. Si se emplea

adecuadamente puede contribuir a mejorar la calidad de las vidas de muchas

personas; en cambio, cuando se hace un mal uso de ella, las consecuencias

pueden ser desastrosas.

Las reacciones químicas gobiernan

y controlan prácticamente la totalidad de los procesos biológicos que

conocemos. Pero, en ocasiones, esas mismas reacciones se pueden tornar mortales

para los seres vivos y terminar con ellos para siempre. Ha ocurrido varias

veces en la historia de la Tierra y podría volver a suceder. La química podría

provocar el fin del mundo.

Vivimos en un mundo poblado por

más de siete mil millones de seres humanos y hay que alimentarlos a todos. La

riqueza está desigualmente repartida y las diferencias llegan a ser sonrojantes

en muchos casos. Las necesidades, cada vez mayores, del mundo "desarrollado",

en cuanto a materia prima, alimentos y tecnología hacen que la sobreexplotación

de los recursos llegue a extremos intolerables y peligrosos. En este sentido,

por citar tan sólo un ejemplo, el empleo de fertilizantes para el crecimiento de

los cultivos. Estos productos contienen cantidades importantes de nitrógeno y fósforo. Si no se tiene el cuidado adecuado, estos elementos pueden

ir a parar al agua de los ríos o mares, provocando efectos indeseables.

Otro caso similar son los

pesticidas empleados en la agricultura o la ganadería para acabar con plagas o

parásitos molestos. Algunos de ellos, como los neonicotinoides, han sido relacionados con las desapariciones

masivas de abejas y abejorros. Productos como el imidacloprid, prohibido en Francia en la década de 1990, o la clotianidina en Alemania en 2008, han

sido relacionados con la muerte de ingentes cantidades de insectos

polinizadores.

Desde la década de los años 50

del siglo pasado, cuando se detectó por vez primera la caída en las poblaciones

de abejas y abejorros en Gran Bretaña, se han producido reducciones de hasta el

96% en algunas especies y otras se han extinguido para siempre. Algunas

sustancias químicas presentes en los pesticidas producen daños irreversibles en

los cerebros de las abejas, bloqueando la transmisión de las señales eléctricas

y químicas entre las neuronas.

La desaparición de los insectos

encargados de la

polinización constituye un problema muy serio, pues de ellos

depende, en gran parte, un porcentaje no pequeño de la economía mundial de las

frutas, verduras, el café, la soja o el algodón, por ejemplo.

Ante una situación tan alarmante,

la solución adoptada por muchos granjeros ha consistido en comenzar a emplear a

las abejas melíferas en la labor de polinización, lo cual ha provocado una

sobreexplotación de estos animales, con la consiguiente aparición de parásitos

y enfermedades. Recientemente, se está experimentando con la abeja azul del

huerto, una especie de abeja que no vive en colmenas y cuyo rendimiento puede

llegar a ser hasta 50 veces superior al de la abeja melífera.

Como os contaba un poco más

arriba, el empleo incontrolado e irresponsable de fertilizantes puede conducir

a la contaminación de las aguas. Se contribuye así a la proliferación de algas

que, al morir, son metabolizadas por microbios que consumen oxígeno en el proceso, obligando a

peces y mamíferos a abandonar las "zonas muertas" que se generan.

Cuando las plantas que viven en estos lugares no son consumidas por los

animales que han huido, mueren y van a parar al fondo, descomponiéndose y

liberando cantidades importantes de sulfuro

de hidrógeno, además de otros gases.

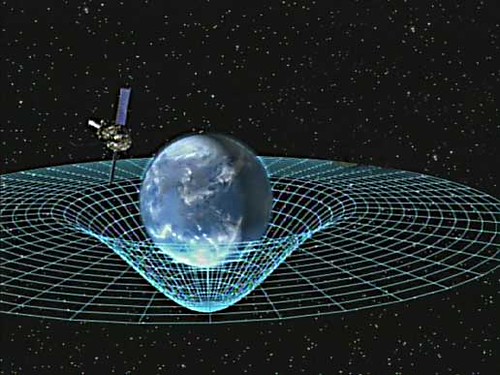

Precisamente, procesos como los

descritos en el párrafo anterior tuvieron lugar, con consecuencias

catastróficas, hace unos 90 millones de años, cuando una inusual actividad

volcánica en nuestro planeta provocó que las temperaturas reinantes fuesen

inusualmente elevadas debido a las ingentes emisiones de

dióxido de carbono, gas que produce un importante

efecto invernadero. Dicho aumento de la temperatura hace que menos

oxígeno se disuelva en el agua del

océano, contribuyendo aún más a la

anoxia

de las aguas.

Los volcanes habían sembrado el

océano superior con grandes cantidades de metales, lo que condujo, a su vez, a

un aumento desmesurado en la producción de

fitoplancton. Al descomponerse la

materia orgánica, el uso de

oxígeno

se elevó en consecuencia.

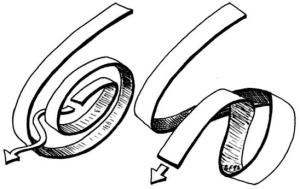

Normalmente, en los océanos el

nivel de oxígeno es similar en las

aguas superficiales y en el fondo, ya que las corrientes lo arrastran hacia abajo.

Los paleogeólogos han averiguado, gracias al registro fósil, que hacia finales

del Pérmico tuvieron lugar extinciones masivas, tanto en el mar como en tierra

firme. Por un lado, en los sedimentos marinos se han hallado evidentes pruebas

de la existencia de bacterias que consumían sulfuro de hidrógeno. Por otro, se sabe que estos organismos

solamente viven y proliferan en ambientes pobres en oxígeno, por lo que seguramente debió de existir una enorme

carestía de este gas en la superficie del océano y la consecuente riqueza en sulfuro de hidrógeno.

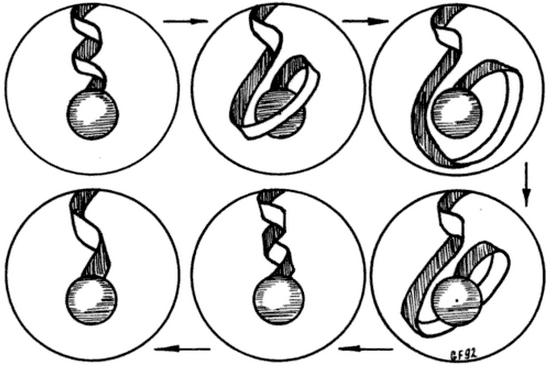

Cuando el

H2S producido en el fondo asciende y se encuentra con el

oxígeno en una zona denominada

quimioclina, se produce una situación

muy favorable para las bacterias verdes y púrpuras del

azufre, las cuales disfrutan, por una parte, del

sulfuro de hidrógeno que llega de abajo

y, por otra, de la luz solar que incide desde arriba. Si por las razones

aducidas antes el

oxígeno comienza a

escasear entonces las bacterias pasan a tomar el control, empiezan a producir

H2S en exceso y la

quimioclina se desplaza cada vez más a

aguas superficiales. El gas, tóxico tanto para las plantas como los animales,

se libera a la atmósfera, envenenándolos a todos ellos y dañando, asimismo, la

capa de

ozono. En la actualidad, se han catalogado más de 400 "zonas

muertas" anóxicas por todo el mundo, la mayor de ellas en el mar Báltico.

Sin embargo, el peligro potencial

provocado por las erupciones volcánicas no termina aquí. En efecto, a lo largo

de la historia de nuestro planeta han tenido lugar eventos de este tipo de una

especial violencia conocidos como

supervolcanes.

Estos fenómenos son capaces de expulsar miles de millones de toneladas de

material rocoso, lava y cenizas. El último tuvo lugar hace unos 75.000 años,

cuando el

lago Toba, en Sumatra, voló prácticamente por los aires. Un evento

así probablemente cubriría extensas zonas continentales con una capa de

escombros de varios centímetros de espesor, arruinando todas las cosechas,

contaminando el agua potable. Los

flujos piroclásticos, a más de 1000 ºC arrasarían cuanto encontrasen a su paso a

casi 700 km/h. Los gases liberados a la atmósfera, principalmente

dióxido de azufre,

dióxido de carbono y

cloro,

bloquearían la luz solar. El primero de ellos, además, reaccionaría con el

vapor de agua, dando lugar a

ácido sulfúrico que permanecería en la

estratosfera en forma de

aerosol

durante años, con el consiguiente descenso drástico de la temperatura global del

planeta, pudiendo desencadenar una nueva glaciación.

A decir verdad, glaciaciones

particularmente extremas, conocidas como

eventos bola de nieve, han acaecido en varias ocasiones. Se cree que la primera

tuvo lugar cuando la Tierra tenía tan sólo la mitad de su edad actual, hace

unos 2.200 millones de años; en cambio, la última sucedió hace 700 millones de

años, cuando nuestro planeta estaba ocupado por el supercontinente

Rodinia y la

luz que recibía del Sol era un 6% menor que ahora.

Rodinia comenzó a fracturarse a

causa del aumento inusual de la actividad volcánica provocada por el movimiento

del magma. Al quedar en contacto con el agua del océano una mayor superficie de

tierra, las regiones húmedas se multiplicaron considerablemente. Las

precipitaciones aumentaron de forma desmesurada, haciendo que la lluvia

absorbiera ingentes cantidades de

CO2

transformándose en

ácido carbónico.

Cuando éste cayó al suelo, provocó reacciones químicas que terminaron con las

rocas, creando suelo nuevo mediante un proceso denominado

meteorización de los silicatos.

El

dióxido de carbono es un gas con un papel esencial en el

efecto invernadero de nuestro planeta. Mientras desaparecía a pasos agigantados

engullido por el agua de las incesantes lluvias que caían sobre la superficie

de la tierra, las temperaturas empezaron a descender de forma alarmante, hasta

alcanzarse varias decenas de grados por debajo de cero, incluso en los

trópicos. Comenzó a proliferar el hielo y la radiación procedente del Sol

escapaba al espacio en un proceso de autoalimentación cada vez más acusado.

Tuvieron que ser, una vez más, los volcanes, los que devolviesen a la Tierra a

un estado más cálido al ir liberando continuamente más y más

dióxido de carbono que ya no era

eliminado por la lluvia, pues el planeta entero se hallaba cubierto de hielo.

Al aumentar de nuevo la temperatura global, el hielo se fundió rápidamente y se

evaporaron inmensas cantidades de agua que contribuyeron, más aún, al efecto

invernadero desbocado. El agua muy caliente de los océanos tuvo que provocar,

necesariamente, huracanes de proporciones épicas.

Normalmente, el aire que se

encuentra sobre el agua del océano no está en equilibrio térmico con ella. De

esta manera, se produce una evaporación que se lleva consigo el calor recibido

del Sol. Es sobre estas aguas que se están formando continuamente tormentas.

Cuando los vientos sobrepasan los 119 km/h reciben el nombre de

huracanes

(también tifones o ciclones, dependiendo de la región del mundo donde se

trate).

El aire cálido y húmedo de la

superficie del mar alimenta al huracán, ascendiendo en su parte central, lo que

contribuye a reforzar el área de bajas presiones y que favorece la entrada de

más cantidad de aire desde las regiones circundantes de altas presiones.

Las simulaciones por ordenador

parecen demostrar que si un área con una extensión no superior a 50 km

2

experimentase un inusual incremento de la temperatura (por ejemplo, después de

un

evento bola de nieve), por encima

de 45-50 ºC, se podría generar una supertormenta, un

hipercán, con vientos superiores a los 1.000 km/h. El ojo de este

monstruo abarcaría cientos de kilómetros de diámetro y la tormenta se

extendería a lo largo de miles, cubriendo incluso la superficie de un

continente. Semejante fenómeno atmosférico, aunque altamente improbable en las

condiciones actuales de nuestro mundo, podría desencadenarse a causa del

impacto de un asteroide en el mar o la erupción de un volcán submarino gigante.

El

hipercán arrastraría hasta la estratosfera varios kilogramos de

agua por segundo. Al cabo de unas pocas semanas, el aire estaría tan saturado

de agua que se formarían nubes extremadamente altas que reducirían

considerablemente la cantidad de radiación solar incidente sobre la superficie

de la Tierra. Las moléculas de

H2O

se descompondrían en enormes cantidades de

radicales

libres altamente reactivos. Las gotas de agua de las nubes harían de

catalizadores en nuevas reacciones químicas que activarían, por ejemplo, el

cloro presente en el agua salada del

mar, y desactivarían los

óxidos de

nitrógeno. Todo ello haría la destrucción del

ozono cada vez más eficaz.

El

ozono es un gas formado por moléculas constituidas por tres átomos

de

oxígeno, en lugar de los dos

habituales, que se encuentra mayormente en la estratosfera, a una altura por

encima de la superficie de la Tierra de entre 10-15 km. Su papel es evitar la

llegada al suelo de los nocivos rayos ultravioletas procedentes del Sol.

La radiación ultravioleta se

suele clasificar en tres categorías: A, B y C, de menos a más nociva para la

vida. La última de ellas es absorbida completamente por las moléculas de ozono; la segunda parcialmente, lo cual

es deseable, ya que a pesar de sus efectos perniciosos, también resulta

esencial para que el cuerpo humano produzca vitamina D, básica en el buen desarrollo y salud de los sistemas

óseo y nervioso. Si la radiación ultravioleta rompe los enlaces que mantienen

unidas las moléculas de ADN pueden llegar

a aparecer errores en la replicación, dando lugar a tumores cancerígenos.

En la década de 1970 se detectó

un agujero en la capa de ozono que

rodea nuestro planeta. Las razones pronto quedaron claras: el empleo continuado

durante años de gases conocidos como CFC (clorofluorocarbonos)

presentes en los extintores, los aparatos frigoríficos o de aire acondicionado,

esprays, etc. Estos compuestos presentan una considerable estabilidad química

que les hace llegar prácticamente inalterados a la estratosfera. Una vez allí,

los fotones ultravioletas del Sol liberan el cloro de las moléculas del CFC, que es el que ataca al ozono, rompiendo los enlaces de sus

moléculas.

Aunque, finalmente, en el año

1987 la firma del

Protocolo de Montreal, suscrito por casi 200 países, acordó

eliminar de forma progresiva el uso de los

clorofluorocarbonos

e ir sustituyéndolos por otros gases menos nocivos como los HCFC (

hidroclorofluorocarbonos) o los HFC (

hidrofluorocarbonos), lo cierto es que

el peligro recae ahora en otros compuestos como pueden ser los

iones hidroxilo y, especialmente, el

óxido nitroso o

N2O, un subproducto de la agricultura y otros procesos

industriales y muy utilizado en odontología (como anestésico, conocido como

"gas de la risa").

Pero los problemas con los

óxidos de nitrógeno no terminan aquí.

Un día cualquiera podríamos levantarnos, asomarnos a la ventana, y observar un

cielo inusualmente oscuro y respirar un aire terriblemente tóxico. En el

improbable caso de que sobreviviésemos quizá nos enterásemos de que una

estrella enormemente masiva y relativamente lejana, no más allá de unos 6.000

años-luz, había sido la responsable.

Cuando una de estas estrellas

termina su vida de consumo de combustible nuclear desbocado, colapsa provocando

una explosión de una violencia inimaginable conocida como

hipernova, probablemente el fenómeno más energético conocido del

universo. Durante el evento, lo que queda de la estrella emite dos gigantescos

destellos de rayos gamma de altísima frecuencia en direcciones opuestas y que

se pueden prolongar durante varios minutos, emitiendo tanta energía como el Sol

a lo largo de toda su existencia.

Si uno de estos haces, conocidos

por los astrofísicos como GRB (gamma ray burst), apuntase de forma casual directamente hacia

nuestro planeta, los fotones arrancarían literalmente los electrones de los átomos

presentes en la atmósfera terrestre, ionizándolos. Las moléculas de oxígeno y nitrógeno se dividirían dando lugar a la formación de NO (óxido nítrico) y del temible dióxido

de nitrógeno, NO2, el

veneno con el que nos despedimos del mundo, tal y como una vez lo conocimos...

Fuente:

50 maneras de destruir el mundo. Alok Jha. Ariel. 2012.

NOTA:

Este post participa en la

XX Edición del Carnaval de Química, cuyo anfitrión, en esta ocasión, es el blog

“La Ciencia de Amara”.