Fuente:

Ciencia Kanija

Científicos de materiales y físicos del Laboratorio Berkeley contribuyen a un notable avance en la RMN.

La resonancia magnética nuclear (RMN), una técnica científica asociada con enormes imanes superconductores a temperatura muy baja, es una de las herramientas principales en el arsenal químico, usado para estudiar todo, desde alcoholes a proteínas pasando las fronteras de la computación cuántica. En los hospitales la máquina prima de la RMN, la imagen por resonancia magnética (IRM), es tan ruidosa como grande, pero no obstante es uno de los pilares de diagnóstico para una gran variedad de condiciones médicas.

Suena a magia, pero ahora, dos grupos de científicos del Laboratorio Berkeley y la UC Berkeley, uno experto en químico y el otro en física atómica, trabajando juntos como un equipo multidisciplinar, han demostrado que los análisis químicos con RMN son prácticos sin usar imanes.

Dmitry Budker de la División de Ciencia Nuclear del Laboratorio Berkeley, profesor de física en la UC Berkeley, es experimentador de proteínas que lidera un grupo con intereses muy dispares que varían desde pruebas sobre teoremas fundamentales de la mecánica cuántica, biomagnetismo en plantas, y violaciones básicas de las relaciones de simetría en los núcleos atómicos. Alex Pines, de la División de Ciencias de los Materiales del Laboratorio y del Departamento de Química de la UCB, es al amo de la RMN y la IRM. Lidera el trabajo de un talentoso y cambiando grupo de postdocs y estudiantes graduados conocidos como los “Pinenuts” – no sólo haciendo investigación básica sobre la RMN sino incrementando sus aplicaciones prácticas. Juntos, los grupos han extendido el alcance de la RMN eliminando el uso de campos magnéticos en distintas etapas de las medidas de RMN, y finalmente han logrado librarse por completo de los campos magnéticos externos.

Girando la información

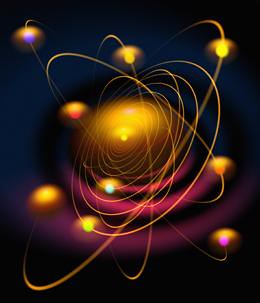

La RMN y la IRM dependen del hecho de que muchos núcleos atómicos poseen espín (no la rotación clásica, sino un número cuántico) y – como Tierras en miniatura con polos magnéticos norte y sur – tienen sus propios campos magnéticos dipolares. En la RMN convencional estos núcleos se alinean gracias a un potente campo magnético externo, y luego se les saca de su eje con un estallido de ondas de radio. La tasa a la que cada tipo de núcleo “bambolea” (precesiona) es único e identifica al elemento; por ejemplo un núcleo de hidrógeno-1, un protón aislado, precesiona cuatro veces más rápido que un núcleo de carbono-13 que tiene seis protones y siete neutrones.

Ser capaz de detectar estas señales depende, antes de nada, de ser capaz de detectar el espín neto; si la muestra tuviese igual número de núcleos con espín “up” que “down”, tendría polarización cero, y las señales se cancelarían. Pero dado que la orientación “up” del espín requiere menos energía, normalmente una población de núcleos atómicos normalmente tiene un ligero exceso de espín “up”, apenas unos pocos entre un millón.

“La creencia convencional mantiene que tratar de hacer una RMN en un campo magnético débil o cero es una mala idea”, dice Budker, “debido a que la polarización es minúscula y la capacidad de detectar señales es proporcional a la fuerza del campo aplicado”.

Las líneas de un espectro típico de RMN revelan más cosas que simplemente elementos distintos. Los electrones cerca del núcleo en precesión alteran sus frecuencias de precesión y provocan un “desplazamiento químico” – moviendo la señal o dividiéndola en líneas distintas en el espectro RMN. Éste es el principal objetivo de la RMN convencional, debido a que los desplazamientos químicos apuntan a especies químicas particulares; por ejemplo, incluso cuando dos hidrocarburos contienen el mismo número de átomos de hidrógeno, carbono y otros átomos, sus señales difieren notablemente de acuerdo a cómo se ordenan los átomos. Pero sin un potente campo magnético, los desplazamientos químicos son insignificantes.

“El campo bajo o cero en RMN empieza con tres golpes en contra: pequeña polarización, baja eficiencia en la detección, y ninguna señal de desplazamiento químico”, dice Budker.

“Entonces, ¿por qué hacerla?”, se pregunta Micah Ledbetter del grupo de Budker. En una pregunta retórica. “Lo principal es librarse de los grandes y caros imanes necesarios para la RMN convencional. Si puedes lograrlo, puedes hacer una RMN portátil y reducir los costes, incluyendo los costes de operación. La esperanza es ser capaces de hacer análisis químicos en el campo – bajo el agua, agujeros excavados, en globos – y tal vez incluso diagnósticos médicos, lejos de los centros médicos bien equipados.

“Cuando esto suceda”, dice Budker, “ya hay métodos para superar la baja polarización y eficiencia en la detección, las primeras dos objeciones a la RMN de campo bajo o cero. Uniendo estos dos métodos, podemos abordar la tercera objeción – no desplazamiento químico – también. La RMN de campo cero puede que no sea una idea tan mala después de todo”.

La orientación neta del espín puede incrementarse de varias formas, conocidas colectivamente como hiperpolarización. Una forma de hiperpolarizar una muestra de gas de hidrógeno es cambiar las proporciones de parahidrógeno y ortohidrógeno dentro del mismo. Como en la mayoría de gases, a temperatura y presión normales, cada molécula de hidrógeno consiste en dos átomos unidos entre sí. Si el espín de los núcleos de protones apunta en el mismo sentido, es ortohidrógeno. Si el espín apunta en sentidos contrarios, es parahidrógeno.

Usando las matemáticas de la mecánica cuántica, sumando los estados de espín de los dos protones y dos electrones en una molécula de hidrógeno se iguala las tres formas que tiene el ortohidrógeno de alcanzar el espín uno; sin embargo, el parahidrógeno sólo puede tener espín cero. Por tanto, las moléculas de ortohidrógeno normalmente cuentan con tres cuartas partes del gas de hidrógeno y el parahidrógeno sólo un cuarto.

El parahidrógeno puede aumentarse a un 50 por ciento o incluso al 100 por ciento usando temperaturas muy bajas, aunque debe añadirse el catalizador adecuado o la conversión podría necesitar días o semanas. Entonces, la reacción química de las moléculas de parahidrógeno con espín cero con un compuesto químico inicial, la polarización neta del producto de la hidrogenación puede terminar altamente polarizado. Esta hiperpolarización puede extenderse no sólo a partes de la molécula que reaccionan directamente con el hidrógeno, sino incluso a los lugares más recónditos de las grandes moléculas. Los Pinenuts, que idearon muchas de las técnicas, son los maestros de la producción de parahidrógeno y su química de hiperpolarización.

“Con una alta proporción de parahidrógeno, logras un enorme grado de polarización”, dice Ledbetter. “El problema está en que es espín cero. No tiene un momento magnético, ¡por lo que no te da una señal! Pero no está todo perdido…”

Y ahora, algo de magia

En campos magnéticos pequeños, el incremento de la eficiencia en la detección requiere una aproximación muy distinta, usando detectores llamadas magnetómetros. En los primeros experimentos de campo pequeño, se usaron magnetómetros conocidos como SQUID (dispositivos superconductores de interferencia cuántica). Aunque exquisitamente sensibles, los SQUID, como los grandes imanes usados en la RMN de campos grandes, deben enfriarse criogénicamente a temperaturas muy bajas.

Los magnetómetros óptico-atómicos están basados en un principio distinto – uno que, curiosamente, es similar a una RMN invertida, excepto que los magnetómetros óptico-atómicos miden todo el átomo no sólo el núcleo. Aquí, se mide un campo magnético externo midiendo el espín de los átomos dentro de la propia célula de vapor del magnetómetro, normalmente un tenue gas de un metal alcalino como el potasio o rubidio. Su espín se ve influido por la polarización de los átomos con luz láser; si hubiese incluso un débil campo externo, empezarían a precesionar. Un segundo haz láser estudia cuánto precesionan y de esta forma calcula cómo de potente es el campo externo.

El grupo de Budker ha llevado a la magnetometría óptico-atómica a un nuevo nivel mediante técnicas como extender el “tiempo de relajación”, el tiempo antes del que el vapor polarizado pierda su polarización. En colaboraciones anteriores, los grupos de Pines y Budker han usado magnetómetros con RMN e IMR para fotografiar el flujo de agua usando sólo el campo magnético de la Tierra, o ningún campo en absoluto, para detectar gas xenón hiperpolarizado (pero sin analizar estados químicos), y otras aplicaciones. La siguiente frontera es el análisis químico.

“No importa cómo de sensible sea tu detector o cómo de polarizadas estén tus muestras, no puedes detectar desplazamiento químicos en un campo cero”, dice Budker. “Pero siempre hay otra señal en una RMN que puede usarse para los análisis químicos – sólo que normalmente es demasiado débil en comparación con los desplazamientos químicos, y por esto ha sido el hermano pobre en la familia de la RMN. Es el conocido como acoplamiento-J”.

Descubierto en 1950 por el pionero en la RMN Erwin Hahn y su estudiante graduado, Donald Maxwell, el acoplamiento J proporciona una ruta de interacción entre dos protones (u otros núcleos con espín), el cual está mediado por sus electrones asociados. Las frecuencias que son firma de estas interacciones, que aparecen en el espectro RMN, pueden usarse para determinar el ángulo de los enlaces químicos y las distancias entre los núcleos.

“Incluso puedes decir cuántos enlaces separan los dos espines”, dice Ledbetter. “El acoplamiento-J revela toda esa información”.

La señal resultante es altamente específica e indica qué especies químicas se están observando. Además, como Hahn observó inmediatamente, aunque la señal puede modificarse mediante campos magnéticos externos, no se desvanece en su ausencia.

Con Ledbetter a la cabeza, la colaboración Budker/Pines construyó un magnetómetro específicamente diseñado para detectar el acoplamiento-J en un campo magnético cero. Thomas Theis, estudiante graduado del grupo de Pines, suministró el parahidrógeno y la experiencia química para aprovechar la polarización inducida por el parahidrógeno. Empezando con estireno, un hidrocarburo simple, midieron el acoplamiento-J en una serie de derivados de hidrocarburos incluyendo el hexano y hexeno, fenilpropano y dimetil maleato, importantes constituyentes de plásticos, derivados del petróleo e incluso perfumes.

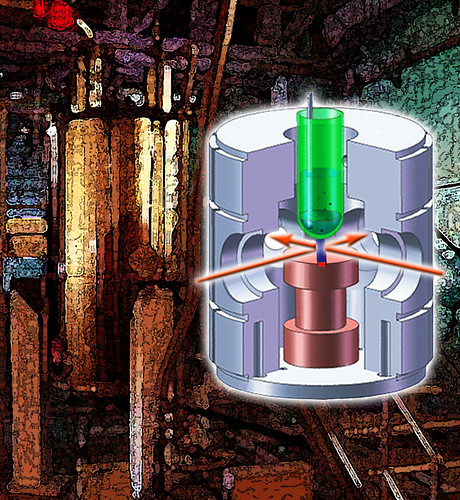

“El primer paso es introducir el parahidrógeno”, dice Budker. “La parte alta de la configuración es un tubo de ensayo que contiene la solución de muestra, con un tubo hasta el fondo a través del cual pasa el parahidrógeno”. En el caso de estireno, el parahidrógeno se usó para producir etilbenceno, una ordenación específica de ocho átomos de carbono y 10 átomos de hidrógeno.

Inmediatamente bajo el tubo de ensayo se sitúa la célula de vapor alcalina del magnetómetro, un dispositivo menor que una uña de la maño, microfabricado por Svenja Knappe y John Kitching del Instituto Nacional de Estándares y Tecnología (NIST). La célula de vapor, que se sitúa en la parte alta del calentador, contiene gas de rubidio y nitrógeno a través del cual lanzan haces láser de sondeo que se cruzan en ángulos rectos. El mecanismo está rodeado por cilindros de “metal mu”, una aleación de níquel-hierro que actúa como escudo contra los campos magnéticos externos, incluyendo el de la Tierra.

Las medidas de Ledbetter produjeron señales en el espectro que identificaron inequívocamente las especies químicas y exactamente dónde habían sido llevados los protones polarizados. Cuando el estireno se hidrogena para formar etilbenceno, por ejemplo, dos átomos de una molécula de parahidrógeno se ligan a distintos átomos de carbono-13 (un isótopo escaso pero natural cuyo núcleo tiene espín, al contrario que el más abundante carbono-12).

Las señales de acoplamiento-J son completamente distintas para moléculas que en otros aspectos sin idénticas en las que los átomos de carbono-13 residen en distintas posiciones. Todo esto se ve directamente en los resultados. “Cuando Micah entra en el laboratorio, el acoplamiento-J es el rey”, dice Budker.

De los actuales magnetómetros del tamaño de una pelota de fútbol, Ledbetter comenta que, “Estamos trabajando en una versión mucho menor del magnetómetro que será más fácil de transportar al campo”.

Aunque los experimentos hasta la fecha se han realizado sobre moléculas que son fácilmente hidrogenadas, las hiperpolarización con parahidrógeno puede también extenderse a otros tipos de moléculas. Budker comenta que: “Apenas estamos al inicio del desarrollo de una RMN de campo cero, y aún es demasiado pronto para decir lo bien que podrá competir con las RMN de campo grande. Pero ya hemos demostrado que podemos lograr espectros claros y muy específicos, con un dispositivo que tiene el potencial de realizar análisis químicos portátiles a bajo coste”.

Autor: Paul Preuss

Fecha Original: 17 de mayo de 2011

Enlace Original

Una de las típicas representaciones de los procesos evolutivos son los cladogramas. Si vemos la la imagen superior, es posible pensar que los organismos van evolucionando con un sentido. Vemos que partimos de un ancestro común y van derivando. Esta, en realidad, es una representación simplificada que nos ayuda a los biólogos a entender las relaciones evolutivas entre diferentes especies. Nótese que he dicho representación simplificada. ¿Cómo sería entonces el árbol completo? Pues bien, más o menos así:

Una de las típicas representaciones de los procesos evolutivos son los cladogramas. Si vemos la la imagen superior, es posible pensar que los organismos van evolucionando con un sentido. Vemos que partimos de un ancestro común y van derivando. Esta, en realidad, es una representación simplificada que nos ayuda a los biólogos a entender las relaciones evolutivas entre diferentes especies. Nótese que he dicho representación simplificada. ¿Cómo sería entonces el árbol completo? Pues bien, más o menos así: El razonamiento que sigue mucha gente para decir que la evolución es dirigida es que obvia todos los organismos que no sobreviven o no tienen descendencia.

El razonamiento que sigue mucha gente para decir que la evolución es dirigida es que obvia todos los organismos que no sobreviven o no tienen descendencia.  Otros argumentaran que somos más evolucionados porque somos más inteligentes. Porque nuestro sistema nervioso “X” porque la autoconciencia “Y”… Esto vuelve a ser una interpretación errónea de la teoría de la evolución. El hecho de que tengamos la inteligencia que tenemos es una estrategia que nos permite sobrevivir y continuarnos como especie, otros organismos utilizan por ejemplo una vida media corta y una altísima tasa de división y logran lo mismo: continuarse en el tiempo.

Otros argumentaran que somos más evolucionados porque somos más inteligentes. Porque nuestro sistema nervioso “X” porque la autoconciencia “Y”… Esto vuelve a ser una interpretación errónea de la teoría de la evolución. El hecho de que tengamos la inteligencia que tenemos es una estrategia que nos permite sobrevivir y continuarnos como especie, otros organismos utilizan por ejemplo una vida media corta y una altísima tasa de división y logran lo mismo: continuarse en el tiempo.