—¿Una lente gravitacional? ¿En casa? ¿Te has vuelto majara?Sí, sí y no. Si seguís conmigo unos minutos, veréis cómo con un objeto que todos tenemos en casa podréis emular un efecto cosmológico que predijo Einstein a partir de su Relatividad General. Puede que las lentes gravitacionales sean fenómenos muy alejados de la experiencia de todos los días, pero no por ello son muy difíciles de entender…

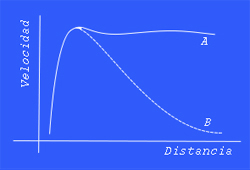

La luz viaja a través del espaciotiempo siguiendo la trayectoria más corta posible. En regiones planas —visualizadlo como si fuera un folio sobre una mesa— los rayos de luz se propagan en línea recta. Dibujad una recta en el folio con lápiz y regla. Si curvamos el espaciotiempo de algún modo, la luz se dobla. Tomad el folio por dos extremos opuestos y empujad un poco: la recta ya no es “recta”.

La clave de la Relatividad General está en el hecho de que una masa muy grande (una estrella por lo menos, para que se note bien el efecto) deforma el espaciotiempo a su alrededor. La trayectoria natural de un rayo de luz que pase cerca no es ya la línea recta común que vemos cuando encendemos una linterna o un puntero láser: se dobla hacia el objeto masivo un poco. Si pensáis en algo con una fuerza gravitatoria más poderosa, el rayo de luz se irá doblando más y más. Un agujero negro es el caso extremo: un objeto con una fuerza de gravedad tan acusada que toda la luz que pasa más cerca de una distancia determinada (marcada por el llamado horizonte de sucesos) cae hacia él. Un agujero negro es “negro” precisamente porque no podemos verlo, ya que no puede reflejar nada.

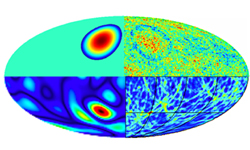

Sin embargo, todos los rayos de luz que pasen cerca del horizonte de sucesos se doblarán más o menos, pero continuarán su camino. Esto ofrece una posibilidad de detectar agujeros negros sin tener que verlos directamente. Supongamos que hay un agujero negro en el camino entre la Tierra y alguna galaxia lejana. La luz de la galaxia que queda ocluida por el horizonte de sucesos del agujero no podrá verse. La que pase un poco más lejos se doblará, y parte llegará hasta nosotros como si viniera de un punto distinto en el cielo. Para una alineación perfecta y suponiendo todo simétrico, percibiremos desde nuestro telescopio en la Tierra un anillo: el anillo de Einstein.

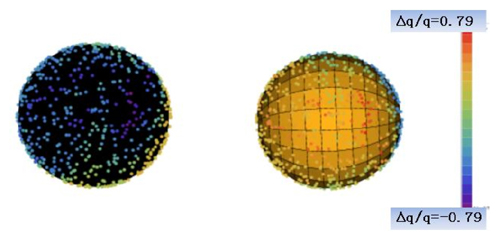

De acuerdo, ya tenemos una idea algo más clara —espero— de lo que es una lente gravitacional. Nos hemos centrado en el tipo “fuerte”, pero hay otros. Ni siquiera es necesario usar algo tan drástico como un agujero negro para ilustrarlas (los de la foto del ejemplo están creados por galaxias elípticas muy densas). ¿Todo bien, hasta aquí? Es el momento de emular una lente gravitacional en casa. Con agujero negro incluido.

—Majara perdido, lo que yo decía.Tranquilos: no hace falta que vuestro primo físico os traiga ningún trozo de materia exótica del CERN, ni que os infléis a margarina hasta que vayáis doblando las baldosas a vuestro paso. Sólo necesitáis algunas decenas de litros de agua, un recipiente grande con desagüe (una bañera sirve) y algún modo de dejar caer en él pequeñas gotas de agua de forma continua. El grifo de la bañera tiene que quedar un poco más cerca de la pared de la bañera que el desagüe. Si está justo encima no os valdrá —en ese caso, necesitaréis crear las gotas de agua de algún otro modo que dejo a vuestra imaginación. Es mejor usar el recipiente más grande posible porque necesitamos que sus paredes estén relativamente lejos. A fin de cuentas, vamos a hacer que la superficie del agua de la bañera simule el espacio interestelar: ahí es nada. Esta será nuestra receta:

- Llenad la bañera hasta la mitad con agua. Bañad a los niños, al perro o a vosotros mismos si notáis olorcillo a humanidad. Así no os sentiréis culpables de tirar tanta agua luego.

- Una vez hayáis usado el agua dejadla reposar hasta que su superficie quede perfectamente plana y libre de impurezas macroscópicas (sacad el patito). Ya tenéis vuestro espacio interestelar: es como el folio del ejemplo del principio, pero más flexible.

- Con cuidado, abrid el grifo lo justo para que caigan al agua gotas lo más pequeñas posible, de forma regular. Dejad el grifo así un minuto y contemplad vuestra obra: habéis creado una estrella. El punto en el que caen las gotas emite ondas que recuerdan a cómo se suelen dibujar las antenas en funcionamiento: recordando que un rayo de luz puede verse como un fotón o como una onda no será difícil imaginar que en ese lugar hay una estrella “emitiendo”.

- Con más cuidado, quitad el tapón del desagüe y esperad a que se estabilice el sistema. Con un poco de suerte se formará un remolino en la superficie del agua. Aquí está vuestro agujero negro.

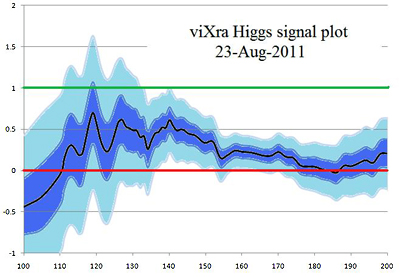

Podemos combinar este sencillo experimento con otro que nos dará una impresión tridimensional de la trayectoria de la luz que da lugar a un anillo de Einstein. Preparad una copa de vino limpia, algo que emita un poco de luz (una linterna, una vela) y haced lo que nos muestra Phil Marshall, del SLAC National Accelerator Laboratory, en este vídeo —cortesía de @Elzo_, del blog Meridianos:

Hemos visto que con un poco de ingenuidad e imaginación podemos recrear el universo en una bañera. Hay personas, más cerca de lo que imaginamos, que hacen este ejercicio en sus cerebros y ordenadores como modo de vida, como @Darksapiens, a quien tuve la oportunidad de saludar en el pasado evento Amazings Bilbao 2011. Si queréis profundizar más en el apasionante mundo de las lentes gravitacionales no dejéis de leer su artículo El efecto de lente gravitacional, una estupenda panorámica para legos con ganas.