Artículo publicado por Philip Ball el 11 de septiembre de 2013 en Nature News

Los físicos han pasado un siglo

desconcertados con las paradojas de la teoría cuántica. Ahora, algunos

están intentando reinventarla.

Si decimos la verdad, pocos físicos han

llegado alguna vez a sentirse cómodos con la teoría cuántica. Tras haber

vivido con ella durante más de un siglo, han logrado forjar una buena

relación laboral; los físicos usan ahora rutinariamente las matemáticas

del comportamiento cuántico para hacer cálculos asombrosamente precisos

sobre la estructura molecular, las colisiones de partículas de alta

energía, comportamiento de semiconductores, emisiones de espectro y

mucho más.

Cuántica

Pero las interacciones tienden a ser estrictamente formales. Tan pronto

como los investigadores intentan ir más allá y preguntarse qué

significan las matemáticas, chocan directamente contra un muro

aparentemente impenetrable de paradojas. ¿Puede algo ser realmente una

onda y una partícula al mismo tiempo? ¿El gato de Schrödinger realmente

está vivo y muerto? ¿Es verdad que incluso la medida más sutil

concebible puede, de algún modo, tener un efecto sobre partículas en el

otro extremo del universo?

Muchos físicos responden a esta rareza

interna refugiándose en la ‘interpretación de Copenhague’, desarrollada

por Niels Bohr, Werner Heisenberg y sus colegas cuando establecían la

forma moderna de la teoría cuántica en la década de 1920. La

interpretación dice que estas rarezas reflejan el límite fundamental de

lo que puede saberse del mundo, y que tienen que aceptarse las cosas tal

como son – o, como dice la famosa frase del físico David Mermin de la

Universidad de Cornell en Ithaca, Nueva York, “¡Cállate y calcula!”1

Pero siempre hay alguien que no se

conforma con callarse – que está determinado a ir más allá y desentrañar

el significado de la teoría cuántica. “¿Qué es lo que hay en este mundo

que nos fuerza a navegar en él con la ayuda de una entidad tan

abstracta?”, se pregunta el físico Maximilian Schlosshauer de la

Universidad de Portland en Oregón, refiriéndose al principio de

incertidumbre; la función de onda que describe la probabilidad de

encontrar un sistema en varios estados; y todo el resto de parafernalia

que se encuentra en los libros de texto sobre teoría cuántica.

A lo largo de la última década,

aproximadamente, una pequeña comunidad de estos respondones han empezado

a defender que la única forma de avanzar es demoler la entidad

abstracta y empezar de nuevo. Son un grupo heterogéneo, cada uno con una

idea distinta de cómo debería abordarse tal ‘reconstrucción cuántica.

Pero comparten la convicción de que los físicos han pasado el último

siglo observando la teoría cuántica desde un ángulo incorrecto, haciendo

que su sombra sea extraña, irritante y difícil de comprender. Si se

observase desde la perspectiva adecuada, piensan, todo quedaría claro, y

los viejos misterios tales como la naturaleza cuántica de la gravedad

podrían resolverse por sí mismos de forma natural y obvia – tal vez como

un aspecto de una teoría de probabilidad generalizada.

“El mejor trabajo sobre las bases

cuánticas”, dice Christopher Fuchs del Instituto Perimeter para Física

Teórica en Waterloo, Canadá, “será aquel que pueda escribir una historia

— literalmente una historia, todo en simples palabras — tan convincente

y magnífica en su visualización, que las matemáticas de la mecánica

cuántica en todos sus detalles técnicos exactos dejen de tener tanta

importante inmediatamente”.

Una propuesta muy razonable

Uno de los primeros intentos de escribir

tal historia llegó en 2001, cuando Lucien Hardy, entonces en la

Universidad de Oxford, Reino Unido, propuso que la teoría cuántica

podría derivarse a partir de un pequeño conjunto de axiomas “muy

razonables”, sobre cómo pueden medirse las probabilidades en cualquier

sistema2, tal como una moneda lanzada al aire.

Hardy empezó haciendo notar que un

sistema clásico puede especificarse completamente midiendo un cierto

número de ‘estados puros’, que denota como N. Para el lanzamiento de una

moneda, en la que el resultado puede ser cara o cruz, N es igual a dos.

Para el lanzamiento de un dado, donde el cubo debe terminar en una de

sus seis caras, N es igual a seis.

La probabilidad, sin embargo, funciona

de manera distinta en el mundo cuántico. Medir el espín de un electrón,

por ejemplo, puede distinguir entre dos estados puros, que puede

describirse de forma grosera como una rotación horaria o antihoraria

alrededor de un eje vertical. Pero, al contrario que en el mundo

clásico, el espín del electrón es una mezcla de dos estados cuánticos

antes de que se realice una medida, y tal mezcla varía a lo largo de un

continuo. Hardy tiene esto en cuenta mediante un ‘axioma de continuidad,

el cual requiere que los estados puros se transformen unos en otros sin

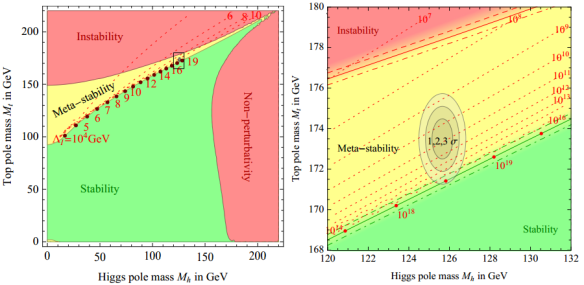

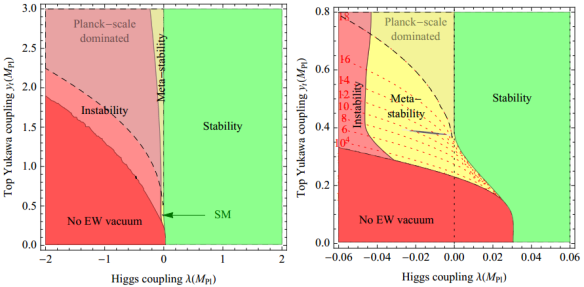

saltos. Este axioma implica que se requieren al N2 medidas para especificar de forma completa un sistema — una relación que corresponden con la descripción cuántica estándar.

Pero, en principio, dice Hardy, el

axioma de continuidad también permite teorías de orden superior en las

que se requiere para la completa definición del sistema N3, N4 o más medidas3,

dando como resultado sutiles desviaciones del comportamiento cuántico

estándar que podría ser observable en el laboratorio. Sin embargo, no

trató de analizar tales posibilidades en detalle, su objetivo, más

ambicioso, era demostrar cómo podría crearse un nuevo marco para la

física cuántica como una teoría general de probabilidad. Posiblemente,

señala, tal teoría podría haberse derivado por los matemáticos del siglo

XIX sin conocimiento de las motivaciones empíricas que llevaron a Max

Planck y Albert Einstein a iniciar la mecánica cuántica a principios del

siglo XX.

Fuchs, por ejemplo, encontró muy

estimulante el artículo de Hardy. “Me golpeó la cabeza como un martillo y

ha cambiado mi forma de pensar desde entonces”, dice, convenciéndolo de

perseguir la aproximación de la probabilidad con todas sus fuerzas.

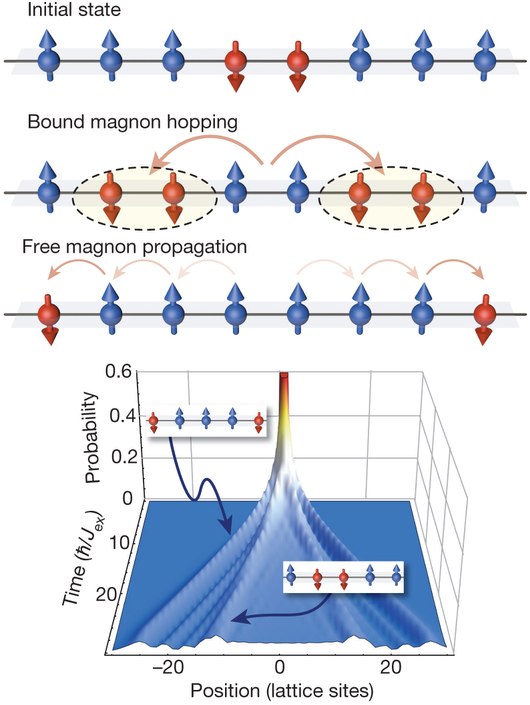

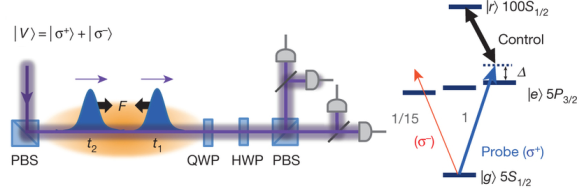

Fuchs estaba especialmente interesado en

reinterpretar el problemático concepto de entrelazamiento: una

situación en la que los estados cuánticos de dos o más partículas son

interdependientes, lo que significa que una medida sobre uno de ellos

permitirá, instantáneamente, determinar el esto de otra. Por ejemplo,

dos fotones emitidos desde un núcleo atómico en sentidos opuestos

podrían entrelazarse, de tal forma que uno se polariza horizontalmente y

el otro verticalmente. Antes de realizar ninguna medida, las

polarizaciones de los fotones está correlacionadas, pero no son fijas.

Una vez que se realiza la medida sobre uno de los fotones, sin embargo,

el otro también queda instantáneamente determinado – incluso si se

encuentra a años luz de distancia.

Tal como Einstein y sus colaboradores

señalaron en 1935, tal acción instantánea sobre distancias

arbitrariamente grandes parece violar la teoría de la relatividad, que

sostiene que nada puede viajar más rápidamente que la luz. Defendían que

esta paradoja era la demostración de que la teoría cuántica era

incompleta.

Pero los otros pioneros salieron al paso

rápidamente. De acuerdo con Erwin Schrödinger, que acuñó el término

‘entrelazamiento’, esta característica es el rasgo esencial de la

mecánica cuántica, “la que fuerza su salida definitiva de las líneas

clásicas de pensamiento”. Posteriores análisis han resuelto la paradoja,

demostrando que las medidas de un sistema entrelazado en realidad no

pueden usarse para transmitir información a mayor velocidad que la luz. Y

los experimentos con fotones de la década de 1980 demostraron que el

entrelazamiento realmente no funciona de esta forma.

Aun así, esta parece ser una extraña

forma de comportamiento para el universo. Y esto es lo que llevó a Fuchs

a requerir un nuevo enfoque a las bases de la cuántica4.

Rechazó la idea, mantenida por mucho en este campo, de que las funciones

de onda, entrelazamiento, y todo lo demás, representan algo real en la

naturaleza (ver Nature 485, 157–158; 2012). En lugar de esto,

ampliando una línea argumental que data de la interpretación de

Conpenhague, insistía en que estas construcciones matemáticas son solo

una forma de cuantificar información personal de los “observadores”,

expectativas, grados de creencia”5.

Se vio animado a seguir con esta visión

por el trabajo de su colega del Instituto Perimeter, Robert Spekkens,

quien llevó a cabo un experimento mental donde se preguntaba qué aspecto

tendría la física si la naturaleza limitase, de algún modo, lo que

cualquier observador podría saber sobre un sistema, imponiendo un

“principio de equilibrio del conocimiento”: ninguna información del

observador sobre el sistema, medida en bits, puede superar la cantidad

de información de la que el observador carece. Los cálculos de Spekkens

demuestran que este principio, aunque parezca arbitrario, es suficiente

para reproducir muchas de las características de la teoría cuántica,

incluyendo el entrelazamiento6. También se ha demostrado que

otros tipos de restricciones sobre lo que puede saberse sobre un

conjunto de estados producen comportamientos similares a los cuánticos7, 8.

Hueco de conocimiento

La lección, dice Fuchs, no es que el

modelo de Spekkens sea realista – nunca intentó serlo – sino que el

entrelazamiento y todo el resto de extraños fenómenos de la teoría

cuántica no son una forma completamente nueva de física. Simplemente

podrían surgir fácilmente de una teoría del conocimiento y sus límites.

Para lograr una mejor idea de cómo

podría suceder esto, Fuchs ha rescrito la teoría cuántica estándar en

una forma que recuerda mucho a una rama de la teoría de probabilidad

clásica conocida como inferencia bayesiana, que tiene sus raíces en el

siglo XVIII. En la visión bayesiana, las probabilidades son con

cantidades intrínsecas ‘ligadas’ a los objetos. En lugar de esto,

cuantifican el grado de creencia personal de un observador de lo que

podría suceder al objeto. La visión bayesiana cuántica de Fuchs, o QBism

(pronunciado ‘cubism’ – cubismo en inglés)9, 10, es un marco

de trabajo que permite recuperar los fenómenos cuánticos conocidos a

partir de unos nuevos axiomas que no requieren de construcciones

matemáticas tales como la función de onda. El QBism ya ha realizado

algunas propuestas experimentales esperanzadoras, señala. Tales

experimentos podría revelar, por ejemplo, nuevas y profundas estructuras

dentro de la mecánica cuántica que permitirían que se re-expresaran las

leyes de probabilidad como variaciones menores de la teoría de

probabilidad estándar11.

“Este nuevo enfoque, de ser válida,

podría cambiar nuestra comprensión de cómo construir computadores

cuánticos y otros dispositivos de información cuántica”, comenta,

señalando que todas esas aplicaciones son muy dependientes del

comportamiento de la probabilidad cuántica.

El conocimiento — que normalmente se

mide en términos de cuántos bits de información tiene un observador

sobre un sistema — es el centro de muchos otros enfoques de

reconstrucción. Tal como expresan los físicos Časlav Brukner y Anton

Zeilinger de la Universidad de Viena, “la física cuántica es una teoría

elemental de la información”12. Mientras tanto, el físico

Marcin Pawłowski de la Universidad de Gdańsk, en Polonia, y sus colegas,

exploran un principio al que llama ‘causalidad de información’13.

Este postulado dice que si un experimentador (llamémoslo Alice) envía m

bits de información sobre sus datos a otro observador (Bob), entonces

Bob no puede lograr más información que m bits clásicos de información

sobre esos datos – sin importar cuánto sepa sobre el experimento de

Alice.

Pawłowski y sus colegas han descubierto

que tanto la física clásica como la mecánica cuántica estándar respetan

este postulado, pero no teorías alternativas que permiten formas más

fuertes de correlaciones similares al entrelazamiento entre partículas

portadoras de información. Por tal razón, el grupo escribe en su

artículo: “la causalidad de la información podría ser una de las

propiedades básicas de la naturaleza” – en otras palabras, un axioma

para alguna futura teoría cuántica reconstruida.

Lo que está complicando algunos de estos

intentos de reconstrucción cuántica es que sugieren que el conjunto de

leyes que gobiernan el universo es sólo una entre muchas posibilidades

matemáticas. “Resulta que muchos principios llevan a toda una clase de

teorías probabilísticas, y no específicamente a la teoría cuántica”,

apunta, “en realidad son genéricas a muchas teorías probabilísticas.

Esto nos permite centrarnos en la cuestión de qué hace única a la teoría

cuántica”.

¿Listo para el éxito?

Hardy dice que el ritmo del trabajo de

reconstrucción cuántica ha tenido un auge durante los últimos años,

cuando los investigadores empezaron a sentir que tenían buenas

herramientas para abordar el problema. “Ahora estamos listos para

algunos avances realmente significativos”, comenta.

Pero, ¿puede alguien juzgar el éxito de

estos esfuerzos? Hardy apunta que algunos investigadores están buscando

señales experimentales de correlaciones cuánticas de nivel superior

permitidas en su teoría. “Sin embargo, yo diría que el criterio real

para el éxito es más teórico”, dice. “¿Tenemos una mejor comprensión de

la teoría cuántica, y los axiomas nos dan nuevas ideas sobre cómo ir más

allá de la física actual?”. Tiene esperanzas de que algunos de estos

principios puedan, finalmente, ayudar en el desarrollo de una teoría de

la gravedad cuántica.

Hay gran espacio para el escepticismo.

“La reconstrucción de la teoría cuántica a partir de un conjunto de

principios básicos parece una idea que tiene todas las apuestas en su

contra”, dice Daniel Greenberger, físico que trabajo en las bases de la

cuántica en el City College de Nueva York5. Aun así,

Schlosshauer defiende que “incluso si ningún programa de reconstrucción

puede finalmente encontrar un conjunto de principios universalmente

aceptados que funcionen, no es trabajo en vano, debido a que habremos

aprendido mucho por el camino”.

Es cautelosamente optimista. “Una vez

que tengamos un conjunto de principios simples y físicamente intuitivos,

la mecánica cuántica será mucho menos misteriosa”, afirma. “Creo que

muchas de las cuestiones abiertas quedarían cerradas. Probablemente no

soy el único que estaría encantado de ser testigo del descubrimiento de

estos principios”.

Nature 501, 154–156 (12 September 2013) doi:10.1038/501154a

Artículos de referencia:

1.- Mermin, N. D. Phys. Today 42, 9 (1989).

2.- Hardy, L. Preprint at http://arxiv.org/abs/quant-ph/0101012 (2001).

3.- Sorkin, R. D. Preprint at http://arxiv.org/abs/gr-qc/9401003 (1994).

4.- Fuchs, C. A. Preprint at http://arxiv.org/abs/quant-ph/0106166 (2001).

5.- Schlosshauer, M. (ed.) Elegance and Enigma: The Quantum Interviews (Springer, 2011).

6.- Spekkens, R. W. Preprint at http://arxiv.org/abs/quant-ph/0401052 (2004).

7.- Kirkpatrick, K. A. Found. Phys. Lett. 16, 199–224 (2003).

8.- Smolin, J. A. Quantum Inform. Comput. 5, 161–169 (2005).

9.- Fuchs, C. A. Preprint at http://arxiv.org/abs/1003.5209 (2010).

10.- Fuchs, C. A. Preprint at http://arxiv.org/abs/1207.2141 (2012).

11.- Renes, J. M., Blume-Kohout, R., Scott, A. J. & Caves, C. M. J. Math. Phys. 45, 2171–2180 (2004).

12.- Brukner, Č. & Zeilinger, A. Preprint at http://arxiv.org/abs/quant-ph/0212084 (2002).

13.- Pawłowski, M. et al. Nature 461, 1101–1104 (2009).

Autor: Philip Ball

Fecha Original: 11 de septiembre de 2013

Enlace Original

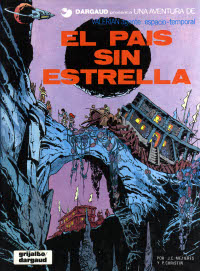

Últimamente estoy releyendo los álbumes de «

Últimamente estoy releyendo los álbumes de « ¿Qué hacemos entonces? Pues dividimos nuestros objetos de estudio en

trozos muy pequeños, de forma que cada uno de esos trozos pueda

considerarse un punto, aplicamos la fórmula para cada punto, y sumamos

todos los pequeños resultados. Llevando este planteamiento a su extremo,

consideraríamos que el objeto está formado por infinitos puntos de

tamaño cero, y calcularíamos la suma de sus infinítamente pequeñas

propiedades. Es decir, realizamos un

¿Qué hacemos entonces? Pues dividimos nuestros objetos de estudio en

trozos muy pequeños, de forma que cada uno de esos trozos pueda

considerarse un punto, aplicamos la fórmula para cada punto, y sumamos

todos los pequeños resultados. Llevando este planteamiento a su extremo,

consideraríamos que el objeto está formado por infinitos puntos de

tamaño cero, y calcularíamos la suma de sus infinítamente pequeñas

propiedades. Es decir, realizamos un  Hemos supuesto que el planeta es más o menos homogéneo. La simetría

esférica de la densidad de la corteza es necesaria para que la gravedad

sea cero en el interior hueco del planeta. Pero sabemos que los planetas

no son tan simétricos. Hay irregularidades, protuberancias, oquedades,

distintos materiales, etc. Así que en un planeta real, es posible que

estas irregularidades rompan el equilibrio de fuerzas, y que en algunos

lugares, la resultante de la fuerza gravitatoria no sea cero. Pero estas

diferencias por lo general serían muy pequeñas. Y fijaos que no sólo

hace falta una pequeña fuerza para no flotar, sino que hay que

contrarrestar la gravedad de la estrella interior.

Hemos supuesto que el planeta es más o menos homogéneo. La simetría

esférica de la densidad de la corteza es necesaria para que la gravedad

sea cero en el interior hueco del planeta. Pero sabemos que los planetas

no son tan simétricos. Hay irregularidades, protuberancias, oquedades,

distintos materiales, etc. Así que en un planeta real, es posible que

estas irregularidades rompan el equilibrio de fuerzas, y que en algunos

lugares, la resultante de la fuerza gravitatoria no sea cero. Pero estas

diferencias por lo general serían muy pequeñas. Y fijaos que no sólo

hace falta una pequeña fuerza para no flotar, sino que hay que

contrarrestar la gravedad de la estrella interior.