Fuente: Naukas

En 1970, una monja radicada en Zambia y llamada Hermana Mary

Jucunda escribió al doctor Ernst Stuhlinger, entonces director asociado

de ciencia en el Centro de Vuelos Espaciales Marshall de la NASA, en

respuesta a sus investigaciones

sobre una misión tripulada a Marte. Concretamente, preguntó cómo podía

sugerir que se gastasen miles de millones de dólares en un proyecto así

en un tiempo en el que tantos niños morían de hambre en la Tierra.

Stuhlinger envió a la Hermana Jucunda la siguiente carta de explicación junto con una copia de Earthrise,

la fotografía-icono de la Tierra tomada en 1968 por el astronauta

William Anders desde la luna (también incluida en esta carta). Su

estudiada respuesta fue más tarde publicada por la NASA bajo el título

de “¿Por qué explorar el Espacio?”

6 de mayo de 1970

Estimada Hermana Mary Jucunda,

Su carta ha sido una de tantas que me llegan cada día, pero me ha

conmovido más profundamente que todas las demás porque viene de una

mente inquieta y un corazón compasivo. Intentaré responder a su pregunta

lo mejor que pueda.

Primero, sin embargo, me gustaría expresarle la gran admiración que

siento por usted y por sus valientes hermanas, porque están ustedes

dedicando sus vidas a la más noble causa del hombre: ayudar a sus

semejantes necesitados.

Pregunta en su carta cómo puedo sugerir que se gasten miles de

millones de dólares en un viaje a Marte, en un momento en el que muchos

niños mueren de hambre en la Tierra.

Sé que no espera usted una respuesta como “¡Oh, no sabía que había

niños muriéndose de hambre, pero desde ahora dejaremos de explorar el

espacio hasta que la humanidad haya resuelto ese problema!” En realidad,

sé de la existencia de niños hambrientos mucho antes de saber que un

viaje al planeta Marte es técnicamente posible. Sin embargo, como muchos

otros, creo que viajar a la Luna, y luego a Marte y otros planetas, es

una aventura que debemos emprender ahora, e incluso creo que ese

proyecto, a la larga, contribuirá más a la solución de esos graves

problemas que tenemos aquí en la Tierra que muchos otros potenciales

proyectos de ayuda que se están debatiendo y discutiendo año tras año, y

que son tan lentos a la hora de proporcionar ayuda tangible.

Antes de intentar describir en más detalle cómo nuestro programa

espacial contribuye a la solución de nuestros problemas en la Tierra, me

gustaría relatarle brevemente una supuesta historia real. Hace 400

años, vivía un conde en una pequeña aldea de Alemania. Era uno de los

condes benignos, y daba gran parte de sus ingresos a los pobres de su

aldea. Eso era muy de agradecer porque la pobreza abundaba en los

tiempos medievales y había epidemias de plaga que asolaban con

frecuencia el campo. Un día, el conde conoció a un extraño hombre. Tenía

una mesa de trabajo y un pequeño laboratorio en su casa, y trabajaba

duro durante el día para poder permitirse algunas horas de trabajo en su

laboratorio por las noches. Tenía lentes pequeñas hechas de trozos de

vidrio; montaba las lentes en tubos y usaba esos aparatos para mirar

objetos muy pequeños. El conde estaba particularmente fascinado por las

minúsculas criaturas que podían observarse con grandes aumentos, y que

nunca antes habían sido vistos. Invitó al hombre a mudar su laboratorio

al castillo, a convertirse en un miembro de su casa y a dedicar desde

entonces todo su tiempo al desarrollo y perfeccionamiento de sus

aparatos ópticos como empleado especial del conde.

Los aldeanos, sin embargo, se enfadaron cuando se dieron cuenta de

que el conde estaba desperdiciando su dinero en lo que ellos

consideraban una payasada sin sentido. “¡Sufrimos por la plaga,” decían,

“mientras le paga a ese hombre por un hobby sin utilidad!” Pero el

conde permaneció firme. “Os doy tanto como puedo,” dijo, “pero también

apoyaré a este hombre y a su trabajo, porque creo que un día algo útil

saldrá de ello.”

Realmente, salieron cosas muy útiles de ese trabajo, y también de

trabajos similares hechos por otros en otros lugares: el microscopio. Es

bien sabido que el microscopio ha contribuido más que cualquier otro

invento al progreso de la medicina, y que la eliminación de la plaga y

de muchas otras enfermedades contagiosas en todo el mundo es en buena

parte el resultado de los estudios que el microscopio hizo posibles.

El conde, al reservar algo de su dinero para investigación y

descubrimiento contribuyó mucho más al alivio del sufrimiento humano que

lo que hubiera conseguido dando a su comunidad asolada por la plaga

todo lo que pudiera ahorrar.

La situación que afrontamos hoy es similar en muchos aspectos. El

Presidente de los Estados Unidos gasta unos 200.000 millones de dólares

en su presupuesto anual. Ese dinero va a sanidad, educación, servicios

sociales, renovación urbana, autopistas, transportes, ayuda al exterior,

defensa, conservación, ciencia, agricultura y muchas instalaciones

dentro y fuera del país. Aproximadamente el 1,6% de este presupuesto

nacional se destina este año a la exploración espacial. El programa

espacial incluye el Proyecto Apolo y muchos otros proyectos más pequeños

en física espacial, astronomía espacial, biología espacial, proyectos

planetarios, proyectos de recursos de la Tierra e ingeniería espacial.

Para hacer posible este gasto en el programa espacial, el contribuyente

norteamericano medio con ingresos de 10.000 dólares paga unos 30 dólares

de sus impuestos para el espacio. El resto de sus ingresos, 9.970

dólares, queda para su subsistencia, recreo, ahorros, otros impuestos, y

todos sus demás gastos.

Probablemente usted se preguntará: “¿por qué no coge 5, o 3, o 1

dólar de esos 30 dólares para el espacio que el contribuyente

norteamericano medio está pagando, y envía esos dólares a los niños

hambrientos?” Para responder a esa cuestión, tengo que explicarle

brevemente cómo funciona la economía de este país. La situación es muy

similar en otros países. El gobierno consiste en un número de

departamentos [ministerios] (Interior, Justicia, Sanidad, Educación y

Servicios Sociales, Transporte, Defensa y otros), y las oficinas

[bureaus] (Fundación Nacional para la Ciencia, Administración Nacional

de Aeronáutica y del Espacio, y otras). Todos ellas preparan sus

presupuestos anuales según sus misiones asignadas, y cada una de ellos

defiende su presupuesto frente a una supervisión extremadamente severa

por parte de las comisiones del Congreso, y frente a una fuerte presión

de ahorro por parte de la Oficina Presupuestaria y del Presidente.

Cuando los fondos son finalmente asignados por el Congreso, solamente

pueden gastarse en las partidas presupuestarias especificadas y

aprobadas en su presupuesto.

El presupuesto de la Administración Nacional de Aeronáutica y del

Espacio, por supuesto, solamente puede contener partidas directamente

relacionada a la aeronáutica y al espacio. Si ese presupuesto no fuese

aprobado por el Congreso, los fondos propuestos no estarían disponibles

para nadie más; sencillamente no serían gravados al contribuyente, a

menos que alguno de los otros presupuesto hubiese obtenido la aprobación

para un aumento específico, que entonces absorberían los fondos no

gastados en el espacio. Se dará usted cuenta, a partir de este breve

discurso, que el apoyo a los niños hambrientos, o más bien un apoyo

adicional a lo que los Estados Unidos ya está contribuyendo para esa

misma noble causa en la forma de ayuda al exterior, solamente puede

obtenerse si el departamento apropiado solicita una asignación para este

fin, y si esa asignación es aprobada por el Congreso.

Puede usted preguntarse si yo, personalmente, estaría a favor de una

acción así por parte de nuestro gobierno. Mi respuesta es un rotundo sí.

De hecho, no me importaría en absoluto si mis impuestos anuales fuesen

aumentados un cierto número de dólares con el fin de alimentar niños

hambrientos dondequiera que vivan.

Sé que todos mis amigos sienten lo mismo. No obstante, no podemos

llevar a cabo un programa así simplemente desistiendo de nuestros planes

de viajar a Marte. Al contrario, creo incluso que al trabajar para el

programa espacial puedo hacer alguna contribución al alivio y eventual

solución de problemas tan graves como la pobreza y el hambre en la

Tierra. En el problema del hambre hay dos funciones básicas: la

producción de comida y su distribución. La producción de alimentos por

medio de agricultura, ganadería, pesca y otras operaciones a gran escala

es eficiente en algunas partes del mundo, pero drásticamente deficiente

en muchas otras partes. Por ejemplo, podrían utilizarse mucho mejor

grandes extensiones de terreno si se aplicasen métodos eficientes de

control de cuencas fluviales, uso de fertilizantes, pronósticos

meteorológicos, evaluación de fertilidad, programación de plantaciones,

selección de campo, hábitos de plantación, cadencia de cultivos,

inspección de cosecha y planificación de recolecciones.

La mejor herramienta para mejorar todas esas funciones, sin duda, es

el satélite artificial en órbita terrestre. Dando vueltas al mundo a

gran altitud, puede explorar grandes zonas de terreno en poco tiempo;

puede observar y medir una gran variedad de factores que indican el

estado y las condición de cosechas, suelo, sequías, precipitaciones,

nieve, etc, y puede enviar esta información por radio a las estaciones

de tierra para su buen uso. Se ha estimado que incluso un sistema

modesto de satélites terrestres equipados con sensores, trabajando en un

programa de mejora agrícola a escala mundial, aumentaría el tamaño de

las cosechas en el equivalente de muchos miles de millones de dólares.

La distribución de alimentos a los necesitados es un problema

completamente diferente. La cuestión no es tanto de volumen de

transporte como de cooperación internacional. El gobernante de un país

pequeño puede sentirse incómodo ante la perspectiva de recibir grandes

envíos de alimentos provenientes de un país grande, sencillamente porque

tema que junto con los alimentos esté importando influencia y poder

extranjeros. Me temo que un alivio eficiente del hambre no llegará a

menos que las fronteras nacionales sean menos divisorias de lo que son

hoy. No creo que el vuelo espacial consiga el milagro de la noche a la

mañana. Sin embargo, el programa espacial se encuentra entre los agentes

más poderosos y prometedores que trabajan en esa dirección.

Permítame tan sólo recordarle la reciente casi tragedia del Apolo 13.

Cuando llegó el crucial momento de la reentrada de los astronautas, la

Unión Soviética cortó todas las transmisiones rusas en las bandas de

frecuencia usadas por el Proyecto Apolo para evitar cualquier

interferencia, y los buques rusos se desplegaron en los Océanos

Atlántico y Pacífico en caso de que se hiciese necesario un resca te de

emergencia. Si la cápsula hubiera caído cerca de un buque ruso, los

rusos sin duran habrían dedicado todos los esfuerzos necesarios para su

rescate, como si fuesen cosmonautas rusos los que hubieran regresado del

espacio. Si los viajeros rusos se encuentran alguna vez en una

situación de emergencia similar, los norteamericanos harán lo mismo sin

dudarlo.

Más alimentos gracias a estudios y valoraciones desde la órbita, y

mejor distribución de alimentos gracias a la mejora en las relaciones

internacionales, son tan sólo dos ejemplos de la profundidad con que el

programa espacial hace mella en la vida sobre la Tierra. Me gustaría

citar otros dos ejemplos: la estimulación del desarrollo tecnológico y

la generación de conocimiento científico.

Los requisitos que deben imponerse a los componentes de una nave

espacial que viaja a la Luna, en cuanto a alta precisión y fiabilidad

extrema, no tienen precedentes en la historia de la ingeniería. El

desarrollo de sistemas que cumplan esos severos requisitos nos ha

proporcionado una oportunidad única para encontrar nuevos materiales y

procesos, para inventar mejores sistemas técnicos, para procesos de

fabricación, para alargar la vida de los instrumentos e incluso para

descubrir nuevas leyes de la naturaleza.

Todo este conocimiento técnico recién adquirido también está

disponible para su aplicación a tecnologías terrestres. Cada año,

alrededor de mil innovaciones técnicas generadas en el programa espacial

se abren camino a las tecnología terrestres, donde producen mejores

electrodomésticos y equipos agrícolas, mejores máquinas de coser y

radios, mejores barcos y aviones, mejores pronósticos del tiempo y

avisos de tormentas, mejores comunicaciones, mejores instrumentos,

mejores utensilios y herramientas para la vida diaria. Supuestamente,

usted preguntará ahora por qué debemos desarrollar un sistema de soporte

vital para nuestros viajeros lunares antes de que podamos construir un

sistema sensor remoto para los pacientes del corazón. La respuesta es

sencilla: los progresos significativos para la solución de los problemas

técnicos se hacen con frecuencia no mediante una aproximación directa,

sino estableciendo primero un objetivo desafiante que nos ofrece una

fuerte motivación para el trabajo innovador, lo que dispara la

imaginación y espolea a los hombres para que se esfuercen al máximo, y

actúa como catalizador al inducir cadenas de otras reacciones.

El vuelo espacial cumple exactamente este papel. El viaje a Marte no

será, ciertamente, una fuente directa de alimentos para los hambrientos.

No obstante, conducirá a tantos nuevos procesos tecnológicos que los

subproductos de este proyecto, por sí solos, valdrán muchas veces más

que el coste de su implementación.

En adición a la necesidad de nuevos procesos tecnológicos, hay una

necesidad creciente de conocimientos básicos de ciencias si queremos

mejorar las condiciones de la vida humana sobre la Tierra. Necesitamos

más conocimientos en física y química, en biología y fisiología, y muy

particularmente en medicina para hacer frente a los problemas que

amenazan la vida del hombre: hambre, enfermedades, contaminación de la

comida y del agua, polución del medio ambiente.

Necesitamos que más jóvenes, hombres y mujeres, escojan ciencia como

su profesión, y necesitamos más apoyo para esos científicos que tienen

el talento y la determinación para enzarzarse en un trabajo científico

fructífero. Deben tener a mano objetivos de investigación que supongan

un desafío, y hay que proporcionarles suficiente apoyo para proyectos de

investigación. De nuevo, el programa espacial, con sus maravillosas

oportunidades para llevar a cabo estudios de investigación realmente

magníficos en lunas y planetas, en física y astronomía, en biología y

medicina, constituye un catalizador casi ideal que induce la reacción

entre la motivación del trabajo científico, las oportunidades para

observar fenómenos naturales excitantes y el apoyo material necesario

para llevar a cabo el esfuerzo de investigación.

Entre todas las actividades dirigidas, controladas y financiadas por

el gobierno norteamericano, el programa espacial es ciertamente la

actividad más visible y probablemente la más debatida, aunque solamente

consume el 1,6% del presupuesto, y es el 3 por mil (menos de un tercio

de un uno por ciento) del producto interior bruto. No hay ninguna otra

actividad equivalente en términos de estimulador y catalizador para el

desarrollo de nuevas tecnologías e investigación en ciencias básicas.

Podemos incluso decir al respecto que el programa espacial está

asumiendo una función que, durante tres o cuatro mil años, ha sido la

triste prerrogativa de la guerra.

¡Cuánto sufrimiento humano puede evitarse si las naciones, en lugar

de competir con sus flotas de bombarderos y cohetes, compitiesen con sus

naves espaciales para viajar a la Luna! Esta competición está llena de

promesas de victorias brillantes, pero no deja espacio para la amargura

de los vencidos que no conduce más que a la venganza y a nuevas guerras.

Aunque nuestro programa especial parece llevarnos lejos de la Tierra

hacia la Luna, el Sol, los planetas y las estrellas, creo que ninguno de

esos objetos celestes recibirá tanta atención y estudio por parte de

los científicos espaciales como nuestra Tierra. Se convertirá en una

Tierra mejor, no sólo por todo el nuevo conocimiento técnico y

científico que usaremos para la mejora de la vida, sino también porque

estamos desarrollando un aprecio más profundo hacia nuestra Tierra,

hacia la vida y hacia el hombre.

La fotografía que le incluyo con esta carta muestra una vista de

nuestra Tierra desde el Apolo 8 cuando estaba en órbita lunar en las

navidades de 1968. De los muchos y maravillosos resultados del programa

espacial hasta la fecha, esta imagen puede que sea la más importante.

Abrió nuestros ojos al hecho de que nuestra Tierra es una hermosa y

preciada isla en un vacío sin límites, y que no hay otro lugar en el que

podemos vivir que la delgada capa superficial de nuestro planeta,

bordeada por la desolada nada del espacio. Nunca antes reconoció tanta

gente lo limitada que nuestra Tierra es en realidad, y lo peligroso que

sería entrometerse en su balance ecológico. Desde que esta fotografía

fue publicada, aumentan más y más las voces que avisan de los graves

problemas con que se enfrente el hombre en nuestros tiempos:

contaminación, hambre, pobreza, vida urbana, producción de alimentos,

control de agua, superpoblación. No es casualidad que comencemos a ver

la tremenda tarea que nos espera justo en el momento en que el joven

programa espacial nos proporciona la primera buena mirada a nuestro

propio planeta.

Por fortuna, la era espacial no sólo sujeta un espejo en el que

podemos vernos a nosotros mismos, sino que también nos proporciona la

tecnología, el desafío, la motivación e incluso el optimismo para atacar

estas tareas con confianza. Lo que aprendemos en el programa espacial,

creo, apoya del todo lo que Albert Schweitzer tenía en mente cuando

dijo: “Miro al futuro no con preocupación sino con esperanza.”

Mis mejores deseos estarán siempre con usted y con sus niños.

Muy sinceramente suyo,

Ernst Stuhlinger

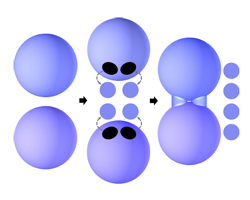

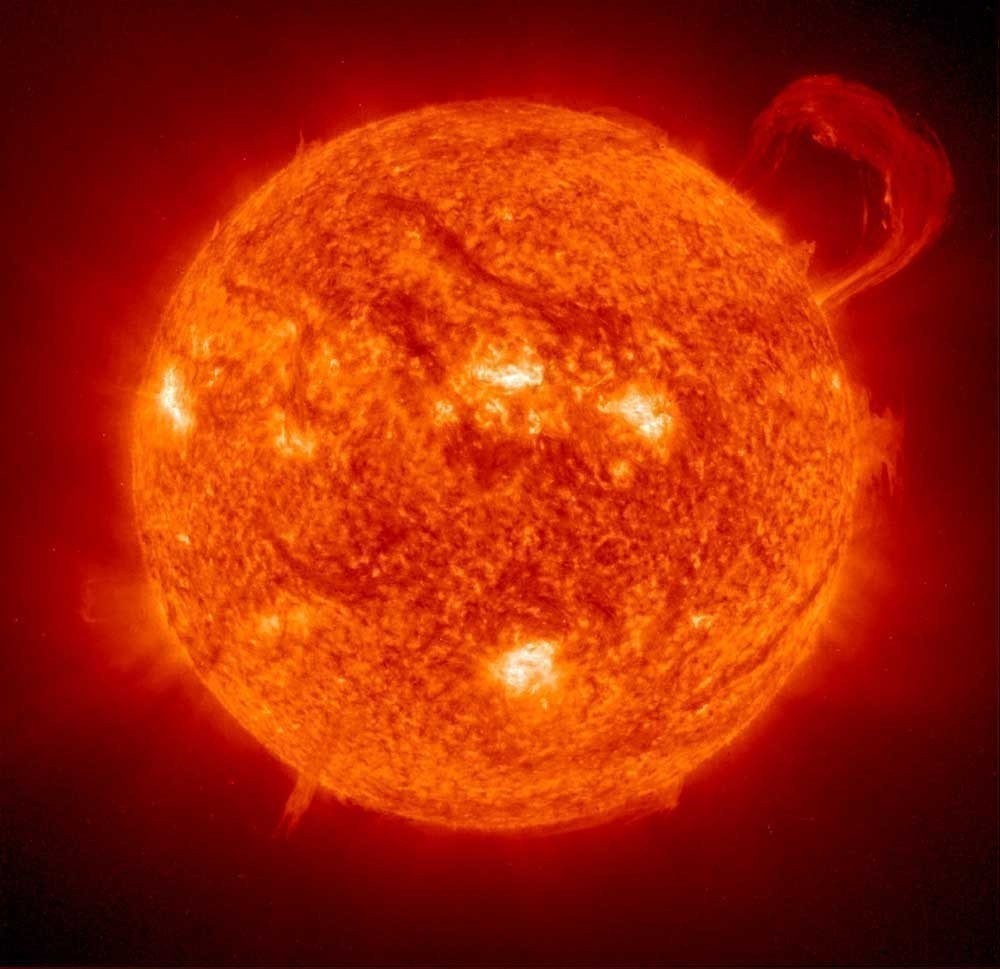

La catástrofe se avecina y no hay

escapatoria posible. Nuestro Sol se está consumiendo poco a poco, día a día,

hora tras hora, minuto a minuto. En su centro tienen lugar procesos violentos

de fusión nuclear y los dicharacheros y revoltosos núcleos de hidrógeno se dan

de tortas calientes unos contra otros, quedándose embarazados durante un

suspiro, y pariendo velozmente núcleos de helio, mientras lanzan gritos de

energía luminosa y calorífica en forma de brillantes fotones que viajan

lentamente hasta la lejana fotosfera. Una vez allí, acompañados por chorros de

otras partículas menos deslumbrantes pero más pesadas como electrones y

protones las cuales, a su vez, constituyen el viento solar, disponen de algo

más de ocho minutos para alcanzar nuestro planeta azul. De vez en cuando,

nuestra estrella, quizá afectada de indigestión, se deshace de materia molesta

en forma de eructos violentos llamados eyecciones de masa coronal. Y la

respuesta de la Tierra consiste en alejarse paulatinamente, cada vez un poquito

más de semejantes actos groseros y maleducados.

La catástrofe se avecina y no hay

escapatoria posible. Nuestro Sol se está consumiendo poco a poco, día a día,

hora tras hora, minuto a minuto. En su centro tienen lugar procesos violentos

de fusión nuclear y los dicharacheros y revoltosos núcleos de hidrógeno se dan

de tortas calientes unos contra otros, quedándose embarazados durante un

suspiro, y pariendo velozmente núcleos de helio, mientras lanzan gritos de

energía luminosa y calorífica en forma de brillantes fotones que viajan

lentamente hasta la lejana fotosfera. Una vez allí, acompañados por chorros de

otras partículas menos deslumbrantes pero más pesadas como electrones y

protones las cuales, a su vez, constituyen el viento solar, disponen de algo

más de ocho minutos para alcanzar nuestro planeta azul. De vez en cuando,

nuestra estrella, quizá afectada de indigestión, se deshace de materia molesta

en forma de eructos violentos llamados eyecciones de masa coronal. Y la

respuesta de la Tierra consiste en alejarse paulatinamente, cada vez un poquito

más de semejantes actos groseros y maleducados.