|

Mientras que esperamos esa confirmación podemos especular con las implicaciones de esa posible existencia. ¿Cómo afectaría esto la Supersimetría?

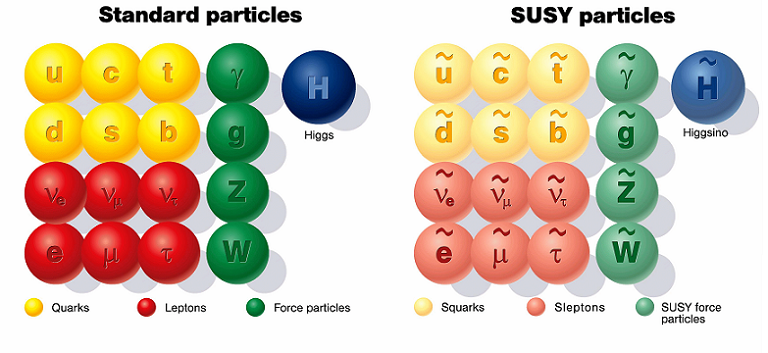

La Supersimetría es una teoría que propone que cada partícula conocida ahora tiene una partícula supersimétrica con el spin cambiado. Si una partícula tiene spin entero su correspondiente partícula supersimétrica tiene spin semientero y viceversa. Es decir, los bosones conocidos tendrían “parejas” fermiónicas y los fermiones conocidos tendrían “parejas” bosónicas. Esto proporcionaría una nueva y bella simetría en la Naturaleza.

Conviene resaltara que esta teoría es independiente de las cuerdas y que las ideas que emplean cuerdas usan Supersimetría como una premisa. La Supersimetría no es una predicción de las cuerdas, sino una condición.

Así por ejemplo, cada quark tendría un squark y cada leptón un sleptón. Normalmente se añade una “s” delante del nombre de la partícula para designar su supersimétrica, sobre todo en inglés.

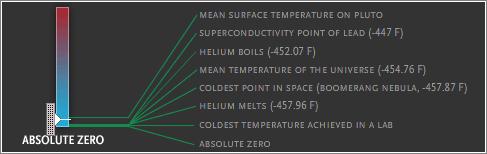

Si alguna vez hubo partículas supersimétricas en el Universo se tuvieron generar durante el Big Bang, pero se desintegraron al cabo de una fracción de segundo después. Ya no quedan squarks ni sleptones.

Si queremos demostrar la existencia de la Supersimetría (SUSY) tendremos que encontrar esas partículas supersimétricas entre los subproductos generados en los choques de los colisionadores de partículas, si es que somos capaces de producirlas. El problema es que no se pueden crear partículas con una masa superior al equivalente en energía máxima que se puede obtener en esos choques y esto depende de la potencia del acelerador. Por encima de cierta masa no somos ni seremos capaces de crear esas partículas, pues no hay tecnología barata conocida que permita alcanzar esas energías.

Desde que LHC empezó a funcionar se ha esperado encontrar alguna de estas partículas supersimétricas sin resultado alguno. SUSY podría ser una teoría equivocada o bien las partículas que predice están más allá de lo que hasta ahora hemos explorado. Un Higgs de 125 GeV/c2 explicaría la segunda posibilidad. Aunque, de momento, SUSY es sólo una creencia, algo que enamora a ciertos teóricos por la belleza que proporciona.

Hay físicos como Howard Baer que trabajan sobre las consecuencias de un Higgs de ese tipo sobre las características de las partículas supersimétricas.

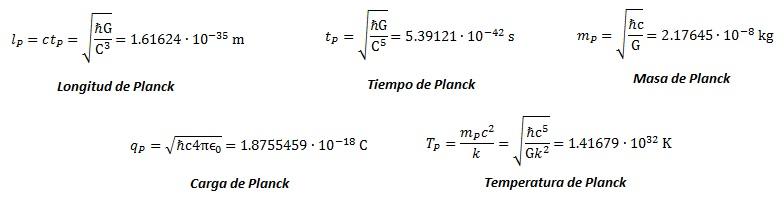

Según la hipótesis en la que se basa la teoría que explica la masa de las partículas, el Higgs sería el bosón de un campo escalar (en contraposición a vectorial). Según sea la intensidad de interacción de una partícula con ese campo adquiere más o menos masa.

Según Baer y sus colaboradores, un Higgs de 125 GeV/c2 implica en varias versiones de la teoría de Supersimetría que los squarks y sleptones tendrían masas superiores a los 10.000 GeV/c2, algo inalcanzable por el LHC y que levanta dudas sobre la falsabilidad de la teoría. Esta sería la razón por la cual no se habrían detectado dichas partículas supersimétricas. Sin embargo, también propone que, en ese caso, el LHC sí podría detectar gluinos, pues éstos tendrían una masa de entre 500 y 1000 GeV/c2. El gluino sería la pareja supersimétrica del gluón*.

Otra posible partícula supersimétrica que podría detectarse sería el squark stop, pareja supersimétrica del quark top. Algunos modelos predicen un stop muy masivo, pero otras predicen un stop con una masa entre 100 y 130 GeV/c2. Si esta última posibilidad se corresponde con lo elegido por la Naturaleza entonces estaría al alcance del LHC.

El problema es que además hay varias versiones de SUSY, hay demasiadas incertidumbres teóricas que las ligan al Higgs y todavía no hemos ni confirmado el Higgs. Incluso éste podría no existir al final y el LHC no detectar absolutamente ninguna nueva partícula elemental.

El problema de la Física es que no son Matemáticas. Al final sólo podemos saber si una teoría física es correcta (o incorrecta) a través de experimentos u observaciones. Una de estas teorías puede ser finalmente falsa aunque sea muy bonita y matemáticamente autoconsistente. Puede que estas dos condiciones sean necesarias para una teoría física correcta, pero nunca son suficientes.

Copyleft: atribuir con enlace a http://neofronteras.com/?p=3718

Fuentes y referencias:

Artículo en ArXiv I

Artículo en ArXiv II

NewScientist.

* Las denominaciones de las partículas perdió un poco de racionalidad cuando se abandonó el uso del latín y griego y se usó inglés corriente, algo que coincidió con la entrada de los norteamericanos en el juego.