En las últimas semanas se han sucedido multitud de explicaciones sobre los supuestos neutrinos superlumínicos de OPERA.

|

| Gran Sasso, en los Apeninos italianos. Fuente: Wikimedia Commons. |

|

Desde que hace unas pocas semanas anunciara

el problema de los neutrinos de OPERA , que parecen ir más deprisa que la luz, no han dejado de sucederse las supuestas explicaciones.

Es impresionante la cantidad de artículos que han aparecido a raíz de este resultado tan excitante (decenas), parece que todo el mundo quiere ser el primero en explicarlo. También hay que decir que el que este tipo de noticias salgan en los medios habituales es bueno para la ciencia y la cultura en general, pese al toque de amarillismo con que se hacía en un principio.

Sobre las explicaciones, casi todas publicadas a través del sistema ArXiv, y aún no en publicaciones científicas habituales, las hay de dos tipos. Las hay que admiten que el resultado es real y que no hay fuentes de errores y se lanzan a emitir todo tipo de hipótesis más o menos valientes (o descabelladas). Otras tratan precisamente de explicar el resultado a la luz de la Física conocida. Aquí vamos a tratar a continuación éstas últimas.

Recordemos brevemente en qué consiste el resultado. Básicamente se usa un acelerador de partículas (cerca de Ginebra) para producir neutrinos. Éstos viajan a través de la corteza terrestre hasta llegar al detector OPERA en Gran Sasso (Italia) situado a 730 km distancia. Según las medidas, parece que estos neutrinos se adelantan en 60 nanosegundos respecto a un haz de luz que cubriera esa misma distancia.

El resultado entra en clara contradicción con los resultados de la supernova 1987A de la que se recibieron neutrinos casi simultáneamente. Un adelanto proporcional a esos 60 nanosegundos hubiera supuesto un adelanto de años en ese caso, cosa que no se produjo. Argüir que ahora los neutrinos son más energéticos o de otro sabor no es una buena excusa

[1],

[2].

Los científicos implicados en OPERA todavía no han publicado un artículo en un journal con referees y simplemente han expuesto sus resultados a la comunidad internacional para ver si encuentran una explicación, ya que ellos, en varios meses de estudio, ha eliminado las posibles fuentes de error que se les han ocurrido. Pues bien, las explicaciones han ido llegando.

Una de estas explicaciones ha sido dada por Andrew Cohen y Sheldon Glashow

[3],

[4]. Aunque no determinan las causas exactas del error apuntan que los neutrinos no pueden ser superlumínicos. Según ellos si así fuera los neutrinos radiarían energía de manera similar al efecto Cherenkov y las medidas tomadas en OPERA contradicen este efecto.

El resultado contradice las apetencias del propio Cohen al que le hubiera gustado que el resultado fuera real. Según él a muchos físicos les hubiera gustado que las medidas fueran correctas, tanto para experimentalistas como para teóricos.

El argumento de que ahora estos neutrinos son más energéticos que los de la supernova juega en contra de su supuesta supervelocidad. Cohen y Glashow se han basado en argumentos básicos como la conservación de la energía y el momento y deducido que si estos neutrinos fueran superlumínicos decaerían en otras partículas rápidamente, precisamente por su elevada energía. Esto haría que fueran perdiendo energía, al decaer en otras partículas, según una típica distribución estadística. Es decir, la gama de energías de los neutrinos se iría ampliando en su viaje hasta OPERA en lugar de estar concentrada en la energía con la que son producidos. Pero se observa la llegada de neutrinos con la misma energía y distribución de energía que con la que salen del CERN, es decir, todos casi iguales.

El efecto es similar a lo que le ocurre a los electrones y otras partículas cuando se mueven en un medio en el que tienen mayor velocidad que la de la luz en ese medio (efecto Cherenkov), como en la cuba de un reactor nuclear.

En el artículo estos dos físicos discuten el mecanismo exacto por el que se da esta transferencia de energía entre partículas y calculan la frecuencia con la que los neutrinos decaerían en otras partículas si fueran superlumínicos. Llegan a la conclusión de que si desde el CERN se emitieran este tipo de neutrinos perderían gran parte de su energía antes de llegar a Italia y esa pérdida de energía no se observa. La explicación más sencilla es que desde un principio no son superlumínicos.

Según Lawrence Krauss, de Arizona State University, este trabajo cierra el caso de los neutrinos superlumínicos y que el equipo de OPERA se precipitó en hacer públicos sus resultados.

Carlo Rovelli, de la Universidad del Mediterráneo, no ve premisas en el artículo de Cohen y Glashow que lo invalide y cree que el resultado es plausible, pero no se muestra sorprendido porque él, como la mayoría de los físicos, sospecha que debe haber algún error en los resultados de OPERA. Respecto a las explicaciones de los atajos a través de las dimensiones ocultas que han propuestos algunos cuerditas dice lo siguiente: “Digámoslo así: los físicos que han trabajado en teoría de cuerdas por más de 20 años han asumido que hay dimensiones extras y ninguno de ellos había considerado la posibilidad de que las partículas pudieran encontrar atajos a través de otras dimensiones e ir más rápidas que la luz.”

Cohen y Glashow no aventuran qué puede haber ido mal en las medidas de OPERA ni la fuente del error.

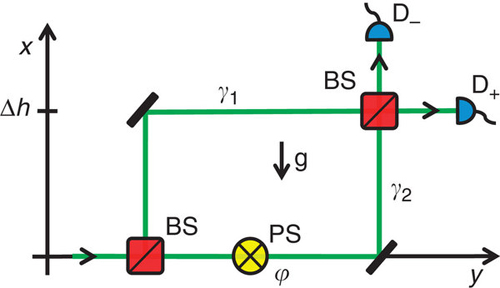

En cuanto a la fuente de ese error, otros investigadores ya han propuesto soluciones. Según Carlo Contaldi, del Imperial College London, el origen del error podría deberse a la mala sincronización del sistema GPS

[5]. Según este investigador no se habrían tenido en cuenta los efectos de la Relatividad General (RG), según la cual el tiempo pasa a distinto ritmo a distintas altura de un campo gravitatorio. La altura a la que está el CERN es diferente a la altura a la que está Gran Sasso y esto introduciría el error suficiente en las medidas. Si este punto se confirma los físicos de OPERA se sentirán probablemente avergonzados y aquellos que decían lo de “Einstein estaba equivocado” tendrán que reconocer que en este punto al final gana él otra vez (pese a estar equivocado en muchas otras cosas).

El CERN está más cerca del centro de la Tierra que Gran Sasso y siente un mayor tirón gravitatorio que, según la RG, haría que el tiempo pasara más despacio que en Gran Sasso.

Dario Autiero, del equipo de OPERA, dice que Contaldi no ha entendido cómo los relojes son sincronizados. Contaldi admite que en su artículo publicado en ARXiv asumió algunas incorrecciones, pero que la sincronización de los relojes usando GPS no elimina los efectos de dilatación del tiempo de la RG que darían cuenta de decenas de nanosegundos, lo que reduciria las seis sigmas de significación del ya famoso resultado de los 60 nanosegundos .

Gilles Henri, del Instituto de Ciencias Planetarias y Astrofísica en Grenoble, propone una explicación áun más sencilla

[6]. Según él las fluctuaciones en el haz de neutrinos podría cambiar la probabilidad de que en Gran Sasso los detecten y esto aumentaría la incertidumbre en la medida del tiempo de vuelo

Según John Ellis, del CERN, los artículos exóticos que asumen la existencia de los neutrinos superlumínicos (

[],

[7],

[8],

[9]) posiblemente estén todos mal, porque probablemente el resultado de OPERA se evaporará.

|

| El experimento OPERA está situado debajo de Gran Sasso para así evitar interferencias de los rayos cósmicos. Fuente: LNGS. |

|

Mientras tanto, según se ha filtrado

[10], la tensión entre los miembros de OPERA ha aumentado y la mitad de ellos no quiere enviar aún el artículo al journal correspondiente. Han estudiado las posibles fuentes de error y no han encontrado ninguna que destruya sus resultados de 6σ de significación estadística, según los cuales la probabilidad de que las medidas se deban a una fluctuación estadística es de una en mil millones, pero algunos miembros del equipo están preocupados de que haya alguna fuente de error sistemático desconocida. El proceso de búsqueda de esa fuente de error podría llevar meses, que podría estar en la electrónica o en el sistema de medida de tiempos.

Es especialmente crítica la primera medida en el CERN. Los investigadores no detectan los neutrinos salientes, sino que miden la distribución temporal de los protones que impactan sobre el blanco que los produce y comparan estos datos con lo detectado en OPERA. Básicamente quizás no se sepa bien cuándo los neutrinos abandonan el CERN para viajar a Gran Sasso. Algunos miembros de OPERA dicen que habría que realizar un estudio independiente sobre este punto y sobre otros antes de proclamar que la Relatividad Especial es errónea.

Los investigadores de MIMOS (un experimentos similar a OPERA), ya trabajan en los datos que tienen para compararlos con los de OPERA. Con un poco de suerte ni siquiera necesitarán recolectar datos nuevos durantes varios meses antes de emitir un informe con los resultados.

Puede que al final los resultados superlumínicos de OPERA queden como el fantasma de OPERA.

Copyleft: atribuir con enlace a

http://neofronteras.com/?p=3626