El tema de hoy me lo ha proporcionado un tuitero que me ha incluido un enlace con el desafiante título de

¿Qué demonios es la ciencia?

Aunque proviene de un blog muy fuera de mi estilo (se llama “La

revolución naturalista”), el provocador título del artículo no pudo

menos que llamar mi atención. En él se menciona a Karl Popper y el

llamado “

problema de la demarcación” referente a la dificultad de definir los límites de eso que denominamos

ciencia.

Para mí, que llevo bajo la sombra de la ciencia toda la vida (y no es

exageración, mi padre era geólogo del CSIC), la ciencia es algo muy

cercano. Tanto, que nunca he tenido problemas en saber qué es. Sin

embargo, la ciencia goza de tan buena fama que muchos otros polizones

intentan subirse a su tren, a menudo sin pagar billete. Y no me refiero

tan sólo a las pseudociencias, que pululan por ahí en busca de

reconocimiento y de las que hay mucho que hablar, sino a las “ciencias”

de todo tipo que proliferan como setas últimamente. En mi propia

Universidad, hay varias licenciaturas (bueno, pronto serán grados) que

se denominan ciencias pero que no tienen nada que ver con la Facultad de

Ciencias. Tenemos Ciencias de la Salud (Enfermería), Ciencias

Económicas, Ciencias Políticas, Ciencias del Trabajo, Ciencias de la

Educación, e incluso Ciencias de la Actividad Física y el Deporte.

Y la duda se extiende a otros estudios más o menos científicos. ¿Es

la psicología una ciencia? ¿La frenología? ¿La homeopatía? ¿La

parapsicología y el ocultismo? ¿Es algo científico lo que intenta hacer

Iker Jiménez en sus programas? Constantemente nos habla de

mediciones, psicofonías, grabaciones y todo tipo de parloteo tipo Cazafantasmas. Incluso

intenta imitar en ocasiones a Carl Sagan ¿o por qué creen que llama a

su plató de televisión “la nave del misterio”?). Puede que sí que nos

haga falta una demarcación, siquiera somera, de

qué entendemos por ciencia.

Cuando comienzo el curso, yo describo la Ciencia como “una rama del

saber.” Supongo que, a estas alturas, incluso mis alumnos menos

brillantes tendrán una idea de lo diferencia la Ciencia de, digamos, el

arte o la religión. Pero como acto seguido les hablo de la Física, les

describo el elemento que, en mi opinión,

diferencia la Ciencia de lo que no es Ciencia. Hablo del

método científico.

En mi opinión, la Ciencia es una rama del saber caracterizada por el

uso de un método de búsqueda de la verdad muy concreto y definido.

Es ese método lo que marca toda la diferencia. El método científico puede expresarse de varias formas. Yo voy a sintetizarlo así:

observación, experimentación, formulación, comunicación, verificación.

Estos pasos no siempre son secuenciales, sino que a menudo se solapan.

1) OBSERVACIÓN. Consiste en un examen crítico y

atento de un fenómeno, tal cual se aparece ante nosotros. Una

observación puede ser cualitativa (solamente fijarse en qué tenemos) o

cuantitativa (es decir, midiendo cantidades). Podemos observar con los

sentidos, o bien usar cualquier instrumento de análisis para abarcar lo

que el ojo no ve (infrarrojos, ultravioleta, rayos X, ondas sísmicas,

etc.). Ese es el primer paso, y si todo va bien, no será el último.

2) EXPERIMENTACIÓN. Este paso es una extensión del

anterior. Un experimento es una observación, o serie de observaciones

realizadas bajo condiciones controladas por el experimentador. No se

trata de una observación pasiva, sino que en este caso el científico es

el que pone las reglas. La experimentación nos permite inferir qué

variables son relevantes en el experimento, y qué variables no lo son.

Por ejemplo, ¿de qué depende el período de un péndulo? Si usamos muchas

cuerdas y muchos objetos atados, comprobaremos que depende de la

longitud de la cuerda, pero no de la masa del objeto que cuelga. Así,

poco a poco, vamos estableciendo relaciones entre variables, lo que nos

permitirá efectuar hipótesis (paso 3).

3) FORMULACIÓN. En este punto, la cosa se anima.

Armados con los datos proporcionados por la observación y la

experimentación, podemos pasar ahora a la fase de formulación, en la que

creamos hipótesis y teorías para explicar los fenómenos observados, así

como para poder efectuar predicciones. Una hipótesis es un primer

intento, una especie de “presunta ley científica” Si posteriores

experimentos la confirman, va afianzándose, denominándose entonces

teoría. Con el tiempo, si validez se ve confirmada y apoyada por nuevas

predicciones, pasa a llamarse ley.

Al menos en teoría. El problema es que los científicos, como

personas que son, tienden a ser algo caóticos. No es como en Derecho,

donde un texto legal pasa de borrador a anteproyecto, luego a proyecto y

después a ley. En ocasiones, la Ciencia llama teoría a algo que es una

ley, o viceversa. La evolución de Darwin es un hecho científico bien

establecido, pero nadie habla de la Ley de la Evolución. ¿Por qué?

Pues porque siempre se la ha llamado teoría, y no nos vamos a poner a

hacer cambios a estas alturas. Es este un detalle que en ocasiones es

mal entendido por la comunidad no científica, que confunde una teoría

con una hipótesis. Ha sido aprovechado con éxito por los grupos

creacionistas que niegan la evolución. Si la evolución es una “teoría,”

dicen, en las escuelas deberían también enseñarse las creencias

creacionistas, que también son una teoría. Lo mismo dicen sobre la

teoría del cambio climático. Una teoría es algo sólido, quizá no tanto

como una ley, pero ciertamente más que una endeble hipótesis.

Pero nuestra taxonomía es un tanto caótica. La “Teoría” de la

Relatividad, comprobada hasta la saciedad, sustituyó hace tiempo la

“Ley” de gravitación de Newton. Hablamos genéricamente de Teoría

Cuántica (que más bien debería ser una ley) y de Teoría de Cuerdas (que

es más bien una hipótesis, o eso dice

el zombi Feynman).

A la teoría más extendida sobre partículas elementales se le llama

Modelo Estándar. Personalmente, creo que la tendencia es a llamar Ley a

una hipótesis concreta, contrastada y confirmada, y a denominar Teoría a

un conjunto de leyes e hipótesis más o menos numerosas.

Un ejemplo divertido es el de la Óptica. Podemos explicar fenómenos

ópticos usando Teoría Corpuscular, o bien Teoría Ondulatoria. Resulta

que ninguna de ellas puede explicar todos los fenómenos ópticos, pero lo

que explican, lo explican perfectamente bien. Lo que sucede es que,

según la (ejem) Teoría Cuántica, un fotón puede actuar como onda o como

partícula, según sea el experimento que diseñemos. Así que la Teoría

Ondulatoria nos explica la Ley de Malus, y la Teoría Corpuscular nos da

la Ley de Snell. ¿Que por qué no hablamos de Ley Corpuscular y Ley

Ondulatoria? Pues por lo mismo que les dije antes: inercia cansina.

(Por cierto, a la teoría óptica ondulatoria es costumbre llamarla

Óptica Física, nombre que yo aborrezco. Para mí, tan física es la

Óptica Ondulatoria como la Corpuscular).

4) COMUNICACIÓN. La Ciencia viene a ser como el

viejo chiste: ¿de qué sirve acostarse con Elsa Pataki si no lo puedes

contar? Una vez has comprobado la validez de tu teoría, llega el

momento de contárselo al mundo. No se trata solamente de egolatría,

aunque a todos nos gusta que se nos atribuya el mérito por nuestro

trabajo. No, es algo mucho más profundo. En Ciencia, todo es válido

mientras no se demuestre lo contrario. Y la mejor manera de demostrarlo

es en el laboratorio, con luz y taquígrafos en todos los rincones.

Cualquier teoría debe ser reproducible, de forma que un científico en el

otro extremo del planeta, con los mismos instrumentos y las mismas

instrucciones, pueda obtener los mismos resultados. Y para eso hay que

comunicar lo que uno obtiene, sea en forma de artículo científico,

contribución a congreso o de otra forma. Se pone todo encima de la

mesa, se da un paso atrás y a esperar el veredicto de tus pares.

Eso es lo que da a la Ciencia una buena parte de su solidez. Nada se

cree porque sí, nada se impone por decreto. Sí, seguro que usted podrá

encontrar contraejemplos de lo que le digo. Newton, como persona,

parece que era un auténtico cabrón, y se pasó años combatiendo a quienes

osaban cuestionar su Teoría Corpuscular de la luz. Era una autoridad

científica, y se salió con la suya durante un tiempo. Pero, a la larga,

el peso de la evidencia experimental hace imperativo descartar la

teoría incorrecta y sustituirla por una mejor. Los argumentos de

autoridad valen lo que valen, y no más.

Incluso científicos honrados y con buenas intenciones pueden cometer

errores, así que la comunidad científica en su conjunto es la encargada

de validar, o refutar, sus resultados, en un proceso de autocorrección

que nunca acaba. ¿Creéis que la forma de trabajar en la Wikipedia, o en

el mundo Linux, es novedosa? ¡Ja! La ciencia descubrió el truco hace

siglos. No solamente eso, sino que comunicar las investigaciones

propias permite a otros científicos avanzar en sus propias

investigaciones. En clase suelo poner el ejemplo de Henry Cavendish.

Este científico británico del siglo XVIII hubiera podido ser un

precursor del electromagnetismo y la teoría de gases, adelantándose en

décadas a hombres como Mawxell, Faraday o Dalton. Pero era de

personalidad retraída y asocial, y muchos de sus descubrimientos no

fueron nunca publicados. Sólo después de su muerte, cuando se

encontraron sus cuadernos de notas, pudo el mundo conocer el total de su

grandeza científica. Una lástima para el mundo, que pudo haberse

aprovechado bien de su mente y sus descubrimientos. Aunque tranquilos,

que al menos Cavendish no murió triste y pobre: cuando fue enterrado en

la catedral de Derby, Inglaterra despedía a uno de sus más acaudalados

súbditos.

5) VERIFICACIÓN. Una vez establecida una teoría,

hay que verificarla. No se trata tan sólo de asegurarse que los

experimentos ya realizados queden bien explicados, sino que también ha

de poder explicar otros fenómenos. Es decir, que nos permita hacer

predicciones. Estas comprobaciones pueden ser hechas tanto por el

científico creador de la teoría como por otros científicos. De hecho,

lo mejor es que lo confirmen grupos de investigadores de otros

laboratorios.

Un ejemplo interesante es el de las ondas gravitacionales. Predichas

por la teoría de la relatividad de Einstein, fueron aparentemente

detectadas por vez primera en los años 60, de la mano de James Weber.

El problema es que, desde entonces, nadie ha podido volver a

detectarlas, a pesar de que los instrumentos recientes son mucho más

sensibles. ¿Mintió Weber y falsificó resultados? No parece el caso.

¿Se equivocó y realizó un experimento fallido? Es posible. Pero,

puesto que tenemos una teoría capaz de explicar las ondas

gravitacionales, se están preparando nuevos y muy costosos experimentos

para verificarla o refutarla (pueden leer más detalles en

este artículo).

Sólo así sabremos si Weber fue un precursor que tuvo la suerte de

detectar una onda gravitacional inusitadamente grande, o si

sencillamente se equivocó.

Otro ejemplo: la fusión fría. En la década de los 80, los

investigadores Stanley Pons y Martin Fleischmann afirmaron haber

obtenido fusión nuclear a temperatura ambiente, mediante una celda

electrolítica. Su descubrimiento fue revolucionario, y ya pueden

imaginarse por qué: ¡nada menos que un bote con agua, deuterio y un

catalizador, y ya tenemos energía barata e inagotable! Este cliché llegó

hasta el cine, con la película

El Santo (1997), donde una

científica rusa y un pícaro ladrón logran salvar a Rusia del abismo

gracias a la fusión fría. Por desgracia, la verificación experimental

de otros equipos fue negativa, nadie fue capaz de reproducir esos

resultados. ¿Fraude? Había miles de millones en juego, y los

investigadores parecían más interesados en obtener patentes que en hacer

trabajo científico serie. Sin embargo, no serían tan tontos como para

creer que nadie verificaría sus resultados. En la actualidad, se cree

que Pons y Fleischmann pudieron haberse equivocado en sus mediciones, lo

que les hizo creer erróneamente que había un exceso de energía de

origen nuclear.

Así que ya saben, amigos. Si tienen alguna duda sobre la validez

científica de cualquier área del saber, rama o pseudociencia que

pretenda acceder al manto de respetabilidad que otorga la ciencia,

hágase las preguntas del método científico:

- ¿Hay observaciones fiables?

- ¿Se realizan experimentos en condiciones controladas y reproducibles?

- ¿Hay alguna teoría, hipótesis o conjetura que permita explicar los fenómenos observados y experimentados?

- ¿Se comunican dichas teorías y experimentos de forma abierta y fiable?

- ¿Se ha verificado de forma rigurosa e independiente?

Si no es así, no compre la moto. Seguro que tiene truco.

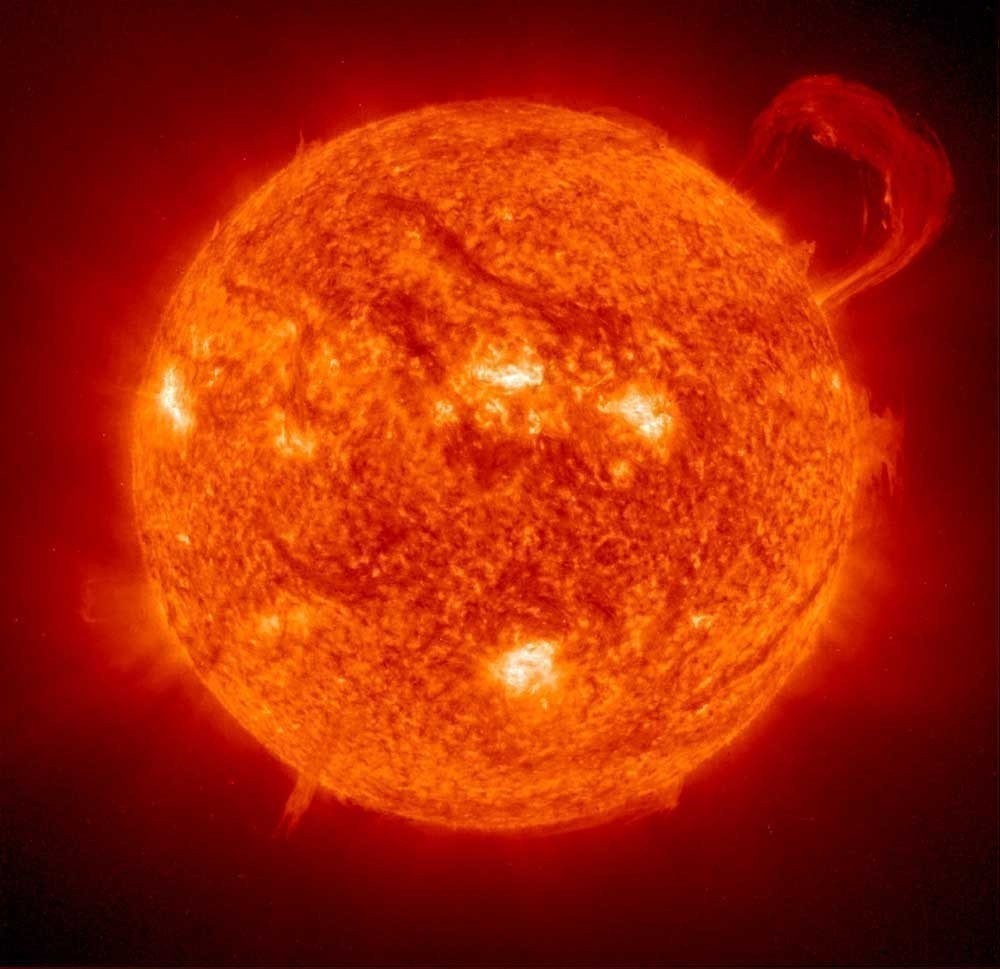

La catástrofe se avecina y no hay

escapatoria posible. Nuestro Sol se está consumiendo poco a poco, día a día,

hora tras hora, minuto a minuto. En su centro tienen lugar procesos violentos

de fusión nuclear y los dicharacheros y revoltosos núcleos de hidrógeno se dan

de tortas calientes unos contra otros, quedándose embarazados durante un

suspiro, y pariendo velozmente núcleos de helio, mientras lanzan gritos de

energía luminosa y calorífica en forma de brillantes fotones que viajan

lentamente hasta la lejana fotosfera. Una vez allí, acompañados por chorros de

otras partículas menos deslumbrantes pero más pesadas como electrones y

protones las cuales, a su vez, constituyen el viento solar, disponen de algo

más de ocho minutos para alcanzar nuestro planeta azul. De vez en cuando,

nuestra estrella, quizá afectada de indigestión, se deshace de materia molesta

en forma de eructos violentos llamados eyecciones de masa coronal. Y la

respuesta de la Tierra consiste en alejarse paulatinamente, cada vez un poquito

más de semejantes actos groseros y maleducados.

La catástrofe se avecina y no hay

escapatoria posible. Nuestro Sol se está consumiendo poco a poco, día a día,

hora tras hora, minuto a minuto. En su centro tienen lugar procesos violentos

de fusión nuclear y los dicharacheros y revoltosos núcleos de hidrógeno se dan

de tortas calientes unos contra otros, quedándose embarazados durante un

suspiro, y pariendo velozmente núcleos de helio, mientras lanzan gritos de

energía luminosa y calorífica en forma de brillantes fotones que viajan

lentamente hasta la lejana fotosfera. Una vez allí, acompañados por chorros de

otras partículas menos deslumbrantes pero más pesadas como electrones y

protones las cuales, a su vez, constituyen el viento solar, disponen de algo

más de ocho minutos para alcanzar nuestro planeta azul. De vez en cuando,

nuestra estrella, quizá afectada de indigestión, se deshace de materia molesta

en forma de eructos violentos llamados eyecciones de masa coronal. Y la

respuesta de la Tierra consiste en alejarse paulatinamente, cada vez un poquito

más de semejantes actos groseros y maleducados.