Fuente: Neofronteras

Un experimento elimina, al parecer, el realismo sólo para una clase grande de teorías no locales.

Desde que la Mecánica Cuántica (MC) fue formulada, algunos físicos de renombre como el propio Albert Einstein se sintieron incómodos con algunos de sus detalles. Uno de esos aspectos era la posibilidad de que dos partículas estuvieran entrelazadas de tal modo que una medida sobre una de ellas parecía influir en la otra en experimentos de tipo EPR (ver referencias al final).

La MC es contraria a la intuición que hemos adquirido en el mundo macroscópico por dos particularidades principalmente. Uno esperaría que toda teoría clásica fuera “local”, es decir, que un objeto puede ser influido solamente por su inmediata vecindad. La segunda es que debe ser “realista”, lo que significa que los objetos tienen unas propiedades definidas que son independientes de si lo estamos midiendo o no. La MC parece violar esas condiciones. Así por ejemplo, si dos fotones correlacionados se separan una distancia suficiente, basta hacer una medición sobre uno de ellos, entonces queden fijadas las propiedades del otro en un proceso que parece darse a mayor velocidad que la luz.

En el pasado se propuso que la MC no era una teoría completa y que debía de haber una teoría clásica de variables ocultas, aún por formular, que explicara lo observado, teoría que además sería local y realista. Aunque nadie ha llegado a expresar tal teoría se han diseñado experimentos y desarrollado una base teórica que permite pensar sobre el problema.

Las rarezas de la MC fueron expresadas matemáticamente por John Bell en sus famosas desigualdades. Bell mostró que una particular combinación de medidas realizadas sobre un par de partículas preparadas del mismo modo producirían unos resultados que cumplirán unas desigualdades siempre y cuando la teoría fuese realista y local.

De este modo se pueden diseñar experimentos que traten de medir esas desigualdades para poner a prueba la MC. En este tipo de experimentos se suele medir la polarización de pares de fotones cuidadosamente preparados a lo largo de diferentes direcciones y calcular las correlaciones entre ellos. Esto ya fue realizado por Stuart Freedman y John Clauser en los setenta, y por Alain Aspect en los ochenta, comprobándose la violación de las desigualdades de Bell. Los resultados, por tanto, confirmaron la MC y su sacrificio del realismo local.

Pero las hipotéticas teorías de variables ocultas se resisten a desaparecer debido a que hay tres lagunas que permiten explicar las violaciones de realismo local observadas con hipotéticas teorías realistas locales. Estas lagunas tienen que ver con la localidad, si no hay suficiente distancia que separe las partículas; la libertad a la hora de elegir un conjunto de medidas, de tal modo que esta elección pudiera estar influida por variables ocultas; y el muestreo, ya que una fracción pequeña de los objetos observados puede que no estén adecuadamente representando a todos los demás debido a problemas de detección.

La primera laguna ya fue eliminada en el pasado aumentando la distancia, indicándose una violación del realismo local. Mientras que la tercera fue superada en un experimento con iones para los que hay buena eficiencia a la hora de su detección.

Recientemente se realizó un experimento de Bell para fotones correlacionados separados 144 km entre sí generados por un diodo láser. Esa distancia es la que media entre la isla de la Palma y Tenerife, que fue recorrida libremente por los fotones a través de la atmósfera. En este experimento se midió que la Naturaleza viola el realismo local con una estadística muy buena de 16 desviaciones estándar. Se trataba de evitar la primera laguna con esos 144 km y un retardo realizado con una fibra óptica de 6 km y la segunda usando estados elegidos aleatoriamente. Descubrieron que, pese a todo, las medidas eran explicadas por la MC violándose en realismo local. Con esto se reduce el número de posibles teorías de variables ocultas realistas y locales que pudieran explicar las correlaciones observadas. Estos investigadores esperan que en unos cinco años se pueda eliminar en un experimento esas tres lagunas simultáneamente.

Aunque hay otras soluciones. En 2003 Anthony Leggett de la Universidad de Illinois trató de restaurar el realismo a costa del sacrificio de la localidad. Si dos entidades cuánticas pueden comunicarse a través de una señal instantánea (no localismo) entonces quizás sea posible que cada una de ellas tenga unas propiedades definidas (realismo). Este escenario superaría el test de Bell, pero, ¿describe el mundo cuántico?

Durante años, físicos de Austria, Suiza y Singapur han tratado de responder a esa la pregunta. En lugar de medir estados de polarización lineal para hacer el test de Bell se usan polarizaciones elípticas que son combinaciones de estados de polarización lineal y circular. Incluso asumiendo que los fotones entrelazados pudieran responder instantáneamente a la situación del otro, las correlaciones entre estados de polarización violaban las desigualdades de Leggett. La conclusión era que incluso admitiendo una comunicación instantánea no era posible explicar el entrelazamiento y por tanto no era posible mantener el realismo.

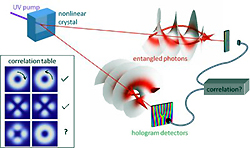

Ahora, otro experimento realizado por Sonja Franke-Arnold y sus colaboradores de las universidades de Glasgow y Strathclyde muestra que los fotones entrelazados muestran correlaciones más fuertes que las permitidas a partículas con propiedades individuales bien definidas, incluso si se les permite comunicarse instantáneamente. Pero en lugar de usar la polarización, midieron las propiedades del momento orbital angular del fotón.

Este momento orbital angular puede ser comprendido imaginando las ondas como si estuvieran retorcidas alrededor del eje del haz. Puede ser representado como una hélice simple (un sacacorchos), una doble hélice o hélices más complejas según se aumenta el momento angular. Estos investigadores se centraron en la hélice doble.

En concreto, usaron un láser ultravioleta que disparaban contra un cristal óptico diseñado para dividir los fotones en pares entrelazados de fotones infrarrojos. Estos iban hacia hologramas controlados computacionalmente que filtraban estados de momento angular orbital complementario. Los fotones que finalmente se obtenían eran contados uno a uno por detectores especiales.

La MC así como las proposiciones de Bell y Leggett dicen cómo deben ser las correlaciones entre dos fotones entrelazados, uno con momento orbital angular a favor de las agujas del reloj y otro en contra. Cuando estos físicos desalinearon deliberadamente los hologramas, las medidas decían que las coincidencias estaban estadísticamente de acuerdo con la propuesta de Leggett, pero no con las predicciones de la MC.

Según estos investigadores se trata de un resultado filosófico. Las partículas entrelazadas no pueden describirse como entidades individuales incluso si se tiene en cuenta una conexión “telepática” entre cada miembro del par.

Simon Gröblacher, de la Universidad de Viena y un experto en el campo, dice que este experimento elimina el realismo sólo para una clase grande de teorías no locales, mientras que otras no son descritas por las desigualdades de Leggett.

Copyleft: atribuir con enlace a http://neofronteras.com/?p=3344

Fuentes y referencias:

Artículo original.

Noticia en Physics world

Artículo original.

Consiguen estados cuánticos entrelazados en un chip.

Realizada la teleclonación cuántica.

La mecánica cuántica pasa otra prueba.

Entrelazamiento cuántico y libre albedrío.

Localidad e incertidumbre.

Un experimento elimina, al parecer, el realismo sólo para una clase grande de teorías no locales.

| |

|

La MC es contraria a la intuición que hemos adquirido en el mundo macroscópico por dos particularidades principalmente. Uno esperaría que toda teoría clásica fuera “local”, es decir, que un objeto puede ser influido solamente por su inmediata vecindad. La segunda es que debe ser “realista”, lo que significa que los objetos tienen unas propiedades definidas que son independientes de si lo estamos midiendo o no. La MC parece violar esas condiciones. Así por ejemplo, si dos fotones correlacionados se separan una distancia suficiente, basta hacer una medición sobre uno de ellos, entonces queden fijadas las propiedades del otro en un proceso que parece darse a mayor velocidad que la luz.

En el pasado se propuso que la MC no era una teoría completa y que debía de haber una teoría clásica de variables ocultas, aún por formular, que explicara lo observado, teoría que además sería local y realista. Aunque nadie ha llegado a expresar tal teoría se han diseñado experimentos y desarrollado una base teórica que permite pensar sobre el problema.

Las rarezas de la MC fueron expresadas matemáticamente por John Bell en sus famosas desigualdades. Bell mostró que una particular combinación de medidas realizadas sobre un par de partículas preparadas del mismo modo producirían unos resultados que cumplirán unas desigualdades siempre y cuando la teoría fuese realista y local.

De este modo se pueden diseñar experimentos que traten de medir esas desigualdades para poner a prueba la MC. En este tipo de experimentos se suele medir la polarización de pares de fotones cuidadosamente preparados a lo largo de diferentes direcciones y calcular las correlaciones entre ellos. Esto ya fue realizado por Stuart Freedman y John Clauser en los setenta, y por Alain Aspect en los ochenta, comprobándose la violación de las desigualdades de Bell. Los resultados, por tanto, confirmaron la MC y su sacrificio del realismo local.

Pero las hipotéticas teorías de variables ocultas se resisten a desaparecer debido a que hay tres lagunas que permiten explicar las violaciones de realismo local observadas con hipotéticas teorías realistas locales. Estas lagunas tienen que ver con la localidad, si no hay suficiente distancia que separe las partículas; la libertad a la hora de elegir un conjunto de medidas, de tal modo que esta elección pudiera estar influida por variables ocultas; y el muestreo, ya que una fracción pequeña de los objetos observados puede que no estén adecuadamente representando a todos los demás debido a problemas de detección.

La primera laguna ya fue eliminada en el pasado aumentando la distancia, indicándose una violación del realismo local. Mientras que la tercera fue superada en un experimento con iones para los que hay buena eficiencia a la hora de su detección.

Recientemente se realizó un experimento de Bell para fotones correlacionados separados 144 km entre sí generados por un diodo láser. Esa distancia es la que media entre la isla de la Palma y Tenerife, que fue recorrida libremente por los fotones a través de la atmósfera. En este experimento se midió que la Naturaleza viola el realismo local con una estadística muy buena de 16 desviaciones estándar. Se trataba de evitar la primera laguna con esos 144 km y un retardo realizado con una fibra óptica de 6 km y la segunda usando estados elegidos aleatoriamente. Descubrieron que, pese a todo, las medidas eran explicadas por la MC violándose en realismo local. Con esto se reduce el número de posibles teorías de variables ocultas realistas y locales que pudieran explicar las correlaciones observadas. Estos investigadores esperan que en unos cinco años se pueda eliminar en un experimento esas tres lagunas simultáneamente.

Aunque hay otras soluciones. En 2003 Anthony Leggett de la Universidad de Illinois trató de restaurar el realismo a costa del sacrificio de la localidad. Si dos entidades cuánticas pueden comunicarse a través de una señal instantánea (no localismo) entonces quizás sea posible que cada una de ellas tenga unas propiedades definidas (realismo). Este escenario superaría el test de Bell, pero, ¿describe el mundo cuántico?

Durante años, físicos de Austria, Suiza y Singapur han tratado de responder a esa la pregunta. En lugar de medir estados de polarización lineal para hacer el test de Bell se usan polarizaciones elípticas que son combinaciones de estados de polarización lineal y circular. Incluso asumiendo que los fotones entrelazados pudieran responder instantáneamente a la situación del otro, las correlaciones entre estados de polarización violaban las desigualdades de Leggett. La conclusión era que incluso admitiendo una comunicación instantánea no era posible explicar el entrelazamiento y por tanto no era posible mantener el realismo.

Ahora, otro experimento realizado por Sonja Franke-Arnold y sus colaboradores de las universidades de Glasgow y Strathclyde muestra que los fotones entrelazados muestran correlaciones más fuertes que las permitidas a partículas con propiedades individuales bien definidas, incluso si se les permite comunicarse instantáneamente. Pero en lugar de usar la polarización, midieron las propiedades del momento orbital angular del fotón.

Este momento orbital angular puede ser comprendido imaginando las ondas como si estuvieran retorcidas alrededor del eje del haz. Puede ser representado como una hélice simple (un sacacorchos), una doble hélice o hélices más complejas según se aumenta el momento angular. Estos investigadores se centraron en la hélice doble.

En concreto, usaron un láser ultravioleta que disparaban contra un cristal óptico diseñado para dividir los fotones en pares entrelazados de fotones infrarrojos. Estos iban hacia hologramas controlados computacionalmente que filtraban estados de momento angular orbital complementario. Los fotones que finalmente se obtenían eran contados uno a uno por detectores especiales.

La MC así como las proposiciones de Bell y Leggett dicen cómo deben ser las correlaciones entre dos fotones entrelazados, uno con momento orbital angular a favor de las agujas del reloj y otro en contra. Cuando estos físicos desalinearon deliberadamente los hologramas, las medidas decían que las coincidencias estaban estadísticamente de acuerdo con la propuesta de Leggett, pero no con las predicciones de la MC.

Según estos investigadores se trata de un resultado filosófico. Las partículas entrelazadas no pueden describirse como entidades individuales incluso si se tiene en cuenta una conexión “telepática” entre cada miembro del par.

Simon Gröblacher, de la Universidad de Viena y un experto en el campo, dice que este experimento elimina el realismo sólo para una clase grande de teorías no locales, mientras que otras no son descritas por las desigualdades de Leggett.

Copyleft: atribuir con enlace a http://neofronteras.com/?p=3344

Fuentes y referencias:

Artículo original.

Noticia en Physics world

Artículo original.

Consiguen estados cuánticos entrelazados en un chip.

Realizada la teleclonación cuántica.

La mecánica cuántica pasa otra prueba.

Entrelazamiento cuántico y libre albedrío.

Localidad e incertidumbre.

Salvo que se exprese lo contrario esta obra está bajo una licencia Creative Commons.