Fuente:

Ciencia Kanija

Estoy escribiendo este texto (12 de marzo) para calmarte respecto a algunas ideas sobre los problemas de Japón, es decir, la seguridad de los reactores nucleares de Japón. Primero que todo, la situación es seria, pero está bajo control. ¡Y este texto es largo! Pero sabrás más sobre plantas de energía nuclear tras leerlo que todos los periodistas del planeta juntos.

No habrá ni hubo ninguna liberación significativa de radiactividad.

Por “significativa” quiero decir un nivel de radiación mayor de lo que recibirías en – digamos – un vuelo de larga distancia, o al beber un vaso de cerveza que procede de ciertas áreas con altos niveles de radiación natural de fondo.

He estado leyendo cada publicación de noticias sobre el incidente desde el terremoto. No ha habido ni un solo informe (¡!) que fuese preciso y estuviese libre de errores (y parte del problema es también una debilidad en la crisis japonesa de comunicación). Por “no libres de errores” no me refiero al periodismo tendencioso antinuclear – que es algo bastante normal en estos días. Por “no libre de errores” me refiero a graves errores respecto a la física y las leyes naturales, así como a una amplia malinterpretación de los hechos, debido a una obvia carencia de comprensión básica y fundamental de cómo se construyen y manejan los reactores nucleares. He leído un informe de tres páginas de la CNN en la que cada párrafo contenía un error.

Vamos a cubrir algunos fundamentos, antes de entrar en qué está pasando.

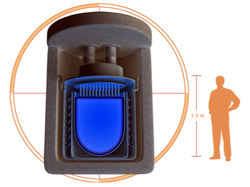

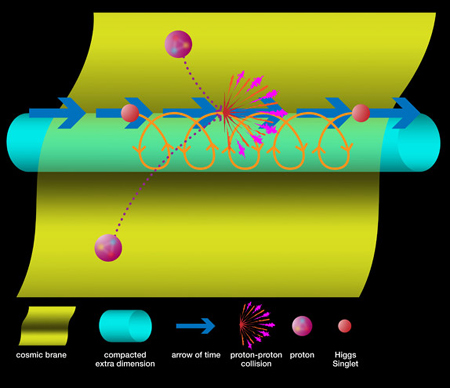

Construcción de las plantas de energía nuclear de Fukushima

Las plantas de Fukushima son conocidas como Reactores de Agua en Ebullición (Boiling Water Reactors), o BWR para abreviar. Los Reactores de Agua en Ebullición son similares a una olla a presión. El combustible nuclear calienta el agua, el agua hierve y crea vapor, el vapor entonces mueve las turbinas que crean la electricidad, y el vapor se enfría y se condensa para volver a ser agua, y se envía el agua a que se caliente de nuevo por parte del combustible nuclear. La olla a presión funciona aproximadamente a 250º C.

El combustible nuclear es óxido de uranio. El óxido de uranio es una cerámica con un punto de fusión muy alto, de aproximadamente 3000º C. El combustible se fabrica en pequeñas bolas (piensa en pequeños cilindros del tamaño de piezas de Lego). Esas piezas se colocan en un largo tubo hecho de Zircaloy con un punto de fusión de 2200º C, y selladas a conciencia. Este ensamblaje se conoce como barra de combustible. Estas barras de combustible se unen para formar grandes paquetes, y un número de estos paquetes se colocan en el reactor. A todos estos paquetes unidos es a lo que nos referimos como “el núcleo”.

La envoltura de Zircaloy es la primera contención. Separa el combustible radiactivo del resto del mundo.

El núcleo se coloca entonces en las “vasijas de presión”. Ésta es la olla a presión de la que hablábamos antes. Las vasijas de presión son la segunda barrera de contención. Es una sólida pieza de una olla, diseñada para contener con seguridad el núcleo hasta temperaturas de varios cientos de grados C. Esto cubre los escenarios donde puede restablecerse en algún punto el enfriamiento.

Todo el “material” del reactor nuclear – las vasijas de presión y todas las tuberías, bombas, reservas de refrigerante (agua), son encapsuladas en una tercera barrera de contención. El tercer confinamiento es una burbuja sellada herméticamente (al vacío) muy gruesa, del acero y hormigón más fuerte. El tercer confinamiento está diseñado, construido y probado para un único propósito: Contener, indefinidamente, una fusión completa del núcleo. Para tal propósito, se coloca una gran y gruesa cuenca de hormigón bajo las vasijas de presión (el segundo confinamiento), todo dentro del tercer contenedor. Esto es lo que se conoce como “receptor del núcleo”. Si el núcleo se funde y las vasijas de presión estallan (y finalmente se funden), recibirá el combustible fundido y todo lo demás. Normalmente se construye de tal forma que el combustible nuclear se disperse, para que pueda enfriarse.

Este tercer contenedor está rodeador por el edificio del reactor. El edificio del reactor es una cobertura externa pensada para mantener el clima, pero no para invitados. (Ésta es la parte que se dañó en la explosión, pero hablaremos más sobre eso después).

Fundamentos de las reacciones nucleares

El combustible de uranio genera calor por fisión nuclear. Los grandes átomos de uranio se dividen en átomos menores y esto genera calor además de neutrones (una de las partículas que forman un átomo). Cuando el neutrón impacta con otro átomo de uranio, se divide, generando más neutrones y así sucesivamente. Esto es lo que se conoce como reacción nuclear en cadena.

Ahora, simplemente empaquetar una gran cantidad de barras de combustible una junto a otra, llevaría rápidamente a un sobrecalentamiento tras unos 45 minutos, lo que desembocaría en una fusión de las barras de combustible. Merece la pena mencionar en este punto que el combustible nuclear de un reactor nunca puede provocar una explosión nuclear del tipo de una bomba nuclear. Construir una bomba nuclear es, en realidad, bastante difícil (pregúntale a Irán). En Chernóbil, la explosión fue provocada por un exceso de presión acumulada, la explosión del hidrógeno y una fractura en todas las barreras de contención, lanzando material fundido del núcleo al entorno (una “bomba sucia”). Por qué eso no ha sucedido, ni sucederá, en Japón se explica más adelante.

Para controlar la reacción nuclear en cadena, los operadores del reactor usan lo que se conoce como “barras de control”. Las barras de control absorben los neutrones y acaban inmediatamente con la reacción en cadena. Un reactor nuclear se construye de tal forma, que cuando opere normalmente, elimines todas las barras de control. El agua refrigerante se lleva el calor (y lo convierte en vapor y electricidad) al mismo ritmo que el núcleo lo produce. Y tienes una gran libertad de acción alrededor del punto de funcionamiento estándar de 250ºC.

El desafío es que tras insertar las barras y detener la reacción en cadena, el núcleo aún sigue generando calor. El uranio “detuvo” la reacción en cadena. Pero el uranio crea un número de elementos radiactivos intermedios durante el proceso de fisión, más notablemente isótopos de cesio y yodo, es decir, versiones radiactivas de estos elementos que finalmente se dividirán en átomos menores y dejarán de ser radiactivos. Estos elementos siguen decayendo y generando calor. Debido a que no se regeneran más a partir del uranio (el uranio dejó de decaer después de que se colocasen las barras de control), obtienen cada vez menos, y el núcleo se enfría en cuestión de días, hasta que esos elementos radiactivos intermedios se agotan.

Este calor residual es lo que está provocando dolores de cabeza actualmente.

Por lo que el primer “tipo” de material radiactivo es el uranio de las barras de combustible, además de los elementos radiactivos intermedios en los que se divide el uranio, también dentro de la barra de combustible (cesio y yodo).

Hay un segundo tipo de material radiactivo creado, fuera de las barras de combustible. La primera gran diferencia es evidente: Esos materiales radiactivos tienen una vida media muy corta, eso significa que decaen muy rápido y se dividen en materiales no radiactivos. Por rápido quiero decir segundos. Por lo que si esos materiales radiactivos se liberan al entorno, sí, se libera radiactividad, pero no, no es peligrosa, en absoluto. ¿Por qué? En el tiempo que te lleva deletrear “R-A-D-I-O-N-Ú-C-L-I-D-O”, se harán inocuos, debido a que se dividirán en elementos no radiactivos. Estos elementos radiactivos son N-16, el isótopo radiactivo (o versión) del nitrógeno (aire). Los otros son gases nobles tales como el argón. Pero, ¿de dónde proceden? Cuando se divide el uranio, se genera un neutrón (ver arriba). La mayor parte de estos neutrones impactarán con otros átomos de uranio y mantendrán en marcha la reacción nuclear en cadena. Pero algunos abandonarán la barra de combustible e impactarán en las moléculas de agua, o el aire que hay en el agua. Entonces, un elemento no radiactivo puede “capturar” el neutrón y se convierte en radiactivo. Como se describe más arriba, rápidamente (en segundos) se liberará del neutrón para volver a su anterior y hermoso yo.

Este segundo “tipo” de radiación es muy importante cuando hablemos posteriormente sobre la radiactividad liberada al entorno.

Qué sucedió en Fukushima

Intentaré resumir los hechos principales. El terremoto que impactó en Japón fue cinco veces más potente que el peor terremoto para el que fue construida la planta de energía nuclear (la escala Richter funciona de forma logarítmica; la diferencia entre el 8,2 para el que las plantas fueron construidas y el 8,9 que tuvo lugar es de 5 veces, no 0,7). Por lo que el primer “hurra” vaya para los ingenieros japoneses, todo se mantuvo en pie.

Cuando el terremoto impactó con sus 8,9, los reactores nucleares pasaron a un apagado automático. Segundos después de que se iniciara el terremoto, las barras de control se habían insertado en el núcleo y la reacción nuclear en cadena del uranio se detuvo. Ahora, el sistema de refrigeración tiene que eliminar el calor residual. La carga de calor residual es de aproximadamente el 3% de la carga de calor bajo las condiciones de funcionamiento normal.

El terremoto destruyó el suministro externo de energía del reactor nuclear. Éste es uno de los accidentes más serios para una planta de energía nuclear, y por consiguiente, un “apagón en la planta” recibe una gran atención cuando se diseñan los sistemas de respaldo. Se necesita la energía para mantener en funcionamiento las bombas refrigerantes. Dado que la planta de energía había sido desactivada, no puede producir electricidad por sí misma.

Las cosas fueron bien durante una hora. Un conjunto de múltiples equipos de generadores de energía Diesel de emergencia entraron en funcionamiento y proporcionaron la electricidad necesaria. Entonces llegó el tsunami, mucho mayor de lo que se había esperado cuando se construyó la planta de energía. El tsunami desactivó múltiples conjuntos de generadores Diesel de respaldo.

Cuando se diseña una planta de energía nuclear, los ingenieros siguen una filosofía conocida como “Defensa de Profundidad”. Esto significa que primero construyes todo para lidiar con la peor catástrofe que puedas imaginar, y luego diseñas la planta de forma que aún pueda manejar un sistema de fallo (eso que pensabas que nunca podría suceder) tras el otro. Un tsunami acabando con la energía de respaldo en un rápido golpe es tal escenario. La última línea de defensa es colocar todo en el tercer contenedor (ver arriba), que mantendrá todo, sea cual sea el problema, barras de control dentro o fuera, núcleo fundido o no, dentro del reactor.

Cuando los generadores Diesel se apagaron, el reactor cambió a la energía de las baterías de emergencia. Las baterías fueron diseñadas como uno de los respaldos del respaldo, para proporcionar energía para el enfriamiento del núcleo durante 8 horas. Y así lo hicieron.

Durante esas 8 horas, tenía que encontrarse otra fuente de energía y conectarla a la planta. La red de energía estaba caída debido al terremoto. Los generadores Diesel quedaron destruidos por el tsunami. Por tanto, se desplegaron generadores Diesel móviles.

Aquí es donde las cosas empezaron a ponerse realmente feas. Los generadores de energía externos no podían conectarse a la planta (los enchufes no encajaban). Por lo que, cuando se agotaron las baterías, no podía eliminarse el calor residual.

En este punto, los operadores de la planta empezaron a seguir los procedimientos de emergencia establecidos para un “evento de pérdida de refrigeración”. Esto es, de nuevo, un paso a lo largo de las líneas de “Defensa de Profundidad”. La energía para los sistemas de enfriamiento nunca debería haber fallado completamente, pero pasó, por lo que se “retiraron” a la siguiente línea de defensa. Todo esto, a pesar de lo impactante que nos parece a nosotros, es parte del entrenamiento cotidiano que pasas como operador, para gestionar con éxito una fusión del núcleo.

Ésta fue la etapa en la que se empezó a hablar de fusión del núcleo. Debido a que al final del día, si no puede restaurarse el enfriamiento, el núcleo finalmente se fundirá (tras horas o días), y la última línea de defensa, el receptor del núcleo y el tercer contenedor, entrarían en juego.

Pero el objetivo en esta etapa era manejar el núcleo mientras se estaba calentando, y asegurar que la primera barrera de contención (los tubos de Zircaloy que contienen el combustible nuclear), así como la segunda barrera (nuestra olla a presión) siguen intactos y operativos todo el tiempo posible, para dar a los ingenieros tiempo de reparar los sistemas de enfriamiento.

Como el enfriamiento del núcleo es una tarea ardua, el reactor tiene un número de sistemas de enfriamiento, cada uno en versiones múltiples (sistema de limpieza de agua del reactor, eliminación del calor de decaimiento, sistema stand-by de refrigeración líquida y sistema de emergencia de refrigeración del núcleo). Cuál falló, cuándo o si no fallaron es algo que no está claro actualmente.

Así que imagina nuestra olla a presión en el fogón, calentándose a fuego lento, pero constante. Los operadores usaron todo tipo de sistema de enfriamiento para liberar tanto calor como fuese posible, pero la presión empezó a acumularse. La prioridad ahora es mantener la integridad del primer contenedor (mantener la temperatura de las barras de combustible por debajo de los 2200º C), así como de la segunda barrera de contención, la olla a presión. Para mantener la integridad de la olla a presión, la segunda barrera, debe liberarse presión de vez en cuando. Dado que la capacidad de hacerlo en una emergencia es tan importante, el reactor tiene 11 válvulas para liberar la presión. Los operadores han empezado a liberar vapor cada cierto tiempo para controlar la presión. La temperatura en esta etapa era de unos 550ºC.

Aquí es cuando empezaron a llegar los informes sobre “filtrado de radiación”. Creo que expliqué más arriba por qué el vapor expulsado es teóricamente lo mismo que liberar radiación al entorno, pero por qué no era, ni es, peligroso. El nitrógeno radiactivo, así como los gases nobles, no suponen una amenaza para la salud humana.

En algún momento durante esta expulsión, se produjo una explosión. La explosión tuvo lugar fuera del tercer contenedor (nuestra “última línea de defensa”), y el edificio del reactor. Recuerda que el edificio del reactor no tiene la función de mantener contenida la radiactividad. Aún no está totalmente claro qué ha sucedido, pero éste es el escenario más probable: Los operadores decidieron expulsar el vapor de las vasijas de presión no directamente al entorno, sino al espacio entre el tercer contenedor y el edificio del reactor (para dar a la radiactividad del vapor más tiempo para decaer. El problema es que a las altas temperaturas que había alcanzado el núcleo en esta etapa, las molécula de agua puede “disociarse” en oxígeno e hidrógeno – una mezcla explosiva. Y estalló, fuera del tercer confinamiento, dañando el edificio del reactor alrededor. Fue este tipo de explosión, pero dentro de la vasija de presión (debido a que fue mal diseñada y no manejada adecuadamente por los operadores, lo que llevó a la explosión de Chernóbil. Esto nunca fue un riesgo en Fukushima. El problema de la formación de hidrógeno-oxígeno es uno de los grandes problemas cuando diseñas una planta de energía (si no eres soviético, claro), por lo que el reactor se construye y maneja de forma que no pueda tener lugar dentro del contenedor. Sucedió fuera, lo cual no es algo deseado pero es un escenario posible y está bien, debido a que no supone un riesgo para la barrera de contención.

Por tanto, la presión estaba bajo control cuando el vapor fue expulsado. Ahora, si sigues calentando tu olla, el problema es que el nivel del agua seguirá disminuyendo. El núcleo está cubierto por varios metros de agua para permitir que pase algún tiempo (horas, días) antes de que quede expuesto. Una vez que las barras empiezan a quedar expuestas en la parte superior, dichas partes alcanzarán la temperatura crítica de 2200ºC tras apenas 45 minutos. Aquí es donde fallaría el primer sistema de confinamiento, el tubo de Zircaloy.

Y esto empezó a suceder. El enfriamiento no pudo restaurarse antes de que hubiese algo (muy limitado, pero algo), de daño en el encapsulado de parte del combustible. El propio material nuclear aún estaba intacto, pero la capa de Zircaloy de alrededor había empezado a fundirse. Lo que sucedió en ese momento es que parte de los subproductos del decaimiento del uranio – cesio y yodo radiactivos – empezaron a mezclarse con el vapor. El gran problema, el uranio, aún estaba bajo control, debido a que las barras de óxido de uranio se mantienen bien hasta los 3000ºC. Se ha confirmado la medición de una pequeña cantidad de cesio y yodo en el vapor que se liberó a la atmósfera.

Ésta parece que fue la “señal de salida” para un plan B. Las pequeñas cantidades de cesio medidas dijeron a los operadores que el primer contenedor de una de las barras estaba a punto de romperse. El Plan A había sido restaurar uno de los sistemas de refrigeración normales del núcleo. Por qué falló es algo que no está claro. Una explicación plausible es que el tsunami se llevó/contaminó toda el agua limpia necesaria para los sistemas de refrigeración normales.

El agua usada en el sistema de refrigeración es muy pura, agua desmineralizada (como el agua destilada). La razón de usar agua pura en la activación mencionada arriba de los neutrones por parte del uranio: El agua pura no se activa mucho, por lo que permanece prácticamente libre de radiación. La suciedad o la sal del agua absorbería neutrones más rápidamente, haciéndola más radiactiva. Esto no tiene efecto en absoluto sobre el núcleo – no importa con qué lo enfríes. Pero complica la vida a los operadores y mecánicos cuando tienen que tratar con agua activada (es decir, ligeramente radiactiva).

Pero el Plan A había fallado – los sistemas de refrigeración estaban caídos y no había disponible agua limpia adicional – por lo que entró en juego el plan B. Esto es lo que parece que sucedió: Para evitar una fusión del núcleo, los operadores empezaron a usar agua del mar para enfriar el núcleo. No estoy seguro de su inundaron nuestra olla a presión con ella (la segunda barrera de contención), o si inundaron el tercer contenedor, inundando la olla a presión. Pero eso no es relevante para nosotros.

El punto es que el combustible nuclear ahora se ha enfriado. Debido a que la reacción en cadena se detuvo hace tiempo, sólo hay un poco de calor residual que se está generando ahora. La gran cantidad de agua refrigerante que se ha usado es insuficiente para eliminar el calor. Debido a que hay una gran cantidad de agua, el núcleo no genera suficiente calor para producir una presión significativa. Además, se ha añadido ácido bórico al agua del mar. El ácido bórico es “una barra de control líquida”. Aunque el decaimiento continúe, el boro capturará los neutrones y acelerará el enfriamiento del núcleo.

La planta estuvo cerca de una fusión del núcleo. Aquí tenemos el escenario del peor casi que se evitó: Si el agua del mar no pudiera haberse usado para el tratamiento, los operadores habrían continuado expulsando el vapor de agua para evitar la acumulación de presión. El tercer contenedor, entonces, habría sido completamente sellado para permitir que tuviese lugar la fusión del núcleo sin liberar material radiactivo. Tras la fusión, habría un periodo de espera para que los materiales radiactivos intermedios decayeran dentro del reactor, y todas las partículas radiactivas se asentaran en la superficie del interior del contenedor. El sistema de enfriamiento habría sido finalmente restaurado, y el núcleo fundido se habría llevado a una temperatura gestionable. Se habría limpiado el interior del contenedor. El laborioso trabajo de eliminar el núcleo fundido del contenedor habría empezado, empaquetando el combustible (sólido de nuevo) trozo a trozo en contenedores de transporte para ser enviado a plantas de procesamiento. Dependiendo del daño, el edificio de la planta tendría que ser reparado o desmantelado.

Ahora, ¿dónde nos deja esto? Mi evaluación:

- La planta ahora es segura, y lo seguirá siendo.

- Japón se enfrenta a un Accidente de Nivel 4 del INES: Accidente nuclear con consecuencias locales. Esto es algo malo para la compañía propietaria de la planta, pero para nadie más.

- Se liberó algo de radiación cuando se ventilaron las vasijas de presión. Todos los isótopos radiactivos del vapor activado han desaparecido (decaído). Se liberó una pequeña cantidad de cesio, así como de yodo. Si estuvieses sentado sobre la chimenea de la planta cuando estaban ventilando, probablemente te habrían ahumado para volver a tu antigua esperanza de vida. Los isótopos de cesio y yodo fueron eliminados por el mar y nunca los volveremos a ver.

- Hubo algunos daños limitados en la primera barrera de contención. Esto significa que parte del cesio y yodo radiactivo también se liberará en el agua refrigerante, pero no uranio ni otros materiales sucios (el óxido de uranio no se “disuelve” en el agua). Hay instalaciones para tratar el agua refrigerante dentro del tercer contenedor. El cesio y el yodo radiactivo se sacarán de allí y finalmente se almacenarán como residuos radiactivos en un almacenamiento terminal.

- El agua del mar usada como agua refrigerante se activará en cierto grado. Debido a que las barras de control se insertaron por completo, la reacción en cadena del uranio no está teniendo lugar. Esto significa que la reacción nuclear “principal” no está teniendo lugar, ni está contribuyendo a la activación. Los materiales radiactivos intermedios (cesio y yodo) también han desaparecido casi por completo en esta etapa, debido a que el decaimiento del uranio se detuvo hace mucho. Esto reduce aún más la activación. La idea básica es que habrá algún bajo nivel de activación en el agua del mar, la cual se eliminará también por las instalaciones de tratamiento.

- El agua del mar se reemplazará con el tiempo por agua refrigerante “normal”.

- El núcleo del reactor será desmantelado y transportado a una instalación de procesamiento, al igual que durante un cambio de combustible habitual.

- Las barras de combustible y toda la planta se comprobarán buscando daños potenciales. Esto puede llevar unos 4-5 años.

- La seguridad de los sistemas de todas las plantas japonesas se actualizarán para lidiar con un terremoto de 9,0 y un tsunami (o algo peor).

- (Actualización) Creo que el problema más significativo será un corte prologando del suministro eléctrico. 11 de los 55 reactores nucleares de Japón en distintas plantas fueron apagados y tendrán que ser inspeccionados, reduciendo directamente la capacidad de producción energética del país en un 20%, siendo la energía nuclear un 30% de la capacidad de generación de energía total del país. No he entrado en posibles consecuencias para otras plantas nucleares no afectadas directamente. Esto probablemente se cubrirá poniendo en marcha las plantas de gas natural que normalmente sólo se usan para picos de carga y para cubrir parte de la carga base. No estoy familiarizado con la cadena de suministro de energía en Japón para el petróleo, gas y carbón, y qué daños han sufrido puertos, refinerías, almacenamientos y transportes, así como daños en la red de distribución nacional- Todo esto llevará a un incremento en tu factura de la electricidad, así como a cortes de energía durante los picos de demanda y esfuerzos de reconstrucción en Japón.

- Todo esto es sólo parte de un cuadro mucho mayor. La respuesta de emergencia tiene que tratar con refugios, agua potable, alimentación y cuidados sanitarios, infraestructuras de comunicación y transporte, así como suministro eléctrico. En un mundo de débiles cadenas de suministros, estamos observando algunos grandes desafíos en todas estas áreas.

Si quieres seguir informado, por favor, olvídate de los medios habituales y consulta las siguientes páginas web:

Autor: Josef Oehmen

Fecha Original: 12 de marzo de 2011

Enlace Original

*** ACTUALIZACIÓN 14-3-2011 08:15 CET horas ***

Las unidades 1 y 3 se encuentran actualmente en una condición estable de acuerdo a los comunicados de prensa TEPCO , pero la magnitud de los daños del combustible es desconocida. Las noticias son que los niveles de radiación en la planta de Fukushima han caído a 231 microsieverts (23,1 milirem) el 14 de marzo 14:30 (hora local).

*** ACTUALIZACIÓN 14-3-2011 10:55 CET horas ***

Los detalles sobre lo que pasó en la Unidad 2 del reactor están aún por determinar. Los mensajes oficiales de lo que está sucediendo en la Unidad 2 del reactor contiene información más actualizada. Los niveles de radiación han aumentado, pero se ignora a qué nivel se encuentran.

***Actualización 15 de marzo de 2011 (08:50 hora de España):***

Información obtenida de World Nuclear News

Se escuchó un fuerte ruido a las 6:10 am en Fukushima Daiichi 2. Se confirman daños en un componente principal bajo el reactor. Se ha completado la evacuación a 20 kilómetros mientras que se ha sofocado el fuego en el lugar.

La confirmación de un fuerte ruido esta mañana en la unidad 2 procede de la Agencia de Seguridad Nuclear e Industrial (NISA). Señaló que “la cámara de supresión puede estar dañada”. No está claro que el sonido fuesen explosiones en el sentido habitual.

También conocido como toro, esta gran estructura en forma de rosquilla se sitúa en el centro del edificio del reactor a un nivel más bajo que el propio reactor. Contiene un gran cuerpo de agua en cuyo vapor puede sumergirse directamente en situaciones de emergencia. El vapor se condensa y reduce la presión en sistema del reactor.

La presión en la piscina se vio que bajó de tres atmósferas a una después del ruido, lo que sugiere un posible daño. Los niveles de radiación en el límite de la planta tuvieron un breve pico a 8217 microsieverts por hora pero después cayeron a una tercera parte de esa cantidad.

Se está echando un vistazo más cercano a los niveles de radiación para evaluar el estado del confinamiento. Como medida de precaución la Compañía de Energía Eléctrica de Tokio ha evacuado a todo el personal no esencial de la unidad. Los ingenieros de la compañía continúan bombeando agua de mar en la vasija de presión del reactor en un esfuerzo por enfriarla.

Fuego en la unidad 4

El Primer Ministro Naoto Kan confirmó un fuego en la unidad 4, la cual, de acuerdo con las fuentes oficiales, nunca ha sido un problema de seguridad desde el terremoto. Este reactor estaba cerrado para una inspección periódica cuando impactaron el terremoto y el tsunami, por tanto no sufrió una rápida y súbita parada. Por supuesto, fue sacudido violentamente y fue objeto del tsunami.

Kan’s spokesman Noriyuki Shikata said that there had been “a sign of leakage” while firefighters were at work, “but we have found out the fuel is not causing the fire.” The fire is now reported extinguished.

Se ordena la evacuación

La solicitud de Kan de evacuación en un radio de 20 kilómetros ha sido completada y dentro de esos 20-30 kilómetros deberían permanecer a cubierto. Dice que este aviso se relaciona con el marco global del desarrollo de las medidas de seguridad en Fukushima Daiichi, más que con alguna de las unidades del reactor concretas.

Shikata añade que los niveles de radiación cerca del reactor han alcanzado niveles que afectarían a la salud humana. Se piensa que el fuego habría sido la fuente principal de radiación.

***Actualización 15 de marzo de 2011 (16:10 hora de España):***

Información obtenida de World Nuclear News 1 y 2

Todas las unidades de Fukushima Daini en apagado automático

Las cuatro unidades de la planta de energía nuclear Fukushima Daini han logrado su apagado automático – donde el agua refrigerante está a menos de 100ºC – con una operación completa de los sistemas de refrigeración, según informa Tepco. Todos los reactores se apagaron automáticamente durante el terremoto de la semana pasada y han permanecido a salvo. Aunque el apagado de la unidad 3 fue como se esperaba, los daños en los sistemas de emergencia de refrigeración del núcleo en las unidades 1, 2 y 4 llevaron al anuncio del estado de emergencia. Los tres reactores se rpepararon para potenciales liberaciones de presión, pero no se requirió. La unidad 1 anunció su apagado automático a las 1.24 am del 14 de marzo y la unidad 2 la siguió a las 3.52 am. Tepco ha anunciado que la unidad 4 logró un apagado automático a las 7.15 pm del 15 de marzo. Los niveles de agua son estables en los cuatro reactores y hay disponible energía externa, según indica la compañía.

Radiación

Las autoridades japonesas dijeron a la Agencia Internacional de Energía Atómica (IAEA) que los niveles de radiación en la planta entre las unidades 3 y 4 alcanzaron un pico de unos 400 milisieverts por hora. “Esto es un valor de dosis alta”, dijo el organismo, “pero es un valor local en una única localización en un punto concreto del tiempo”.

Posteriores lecturas fueron de 11,9 milisieverts por hora, y de 0,6 milisieverts seis horas más tarde, por lo que la IAEA comentó que “indica que el nivel de radiactividad ha estado decreciendo”.

Casi toda la gente que vive en un radio de 20 kilómetros de la planta ya ha sido evacuada y se les ha suministrado píldoras de potasio-yodo que los protegerán de forma efectiva contra los efectos del yodo-131 que podría, posiblemente, emitirse en un futuro. Las píldoras saturan la glándula tiroides y evitan que el yodo-131 radiactivo sea absorbido, reduciendo drásticamente el riesgo de cáncer de tiroides, que son el principal efecto potencial en la salud en un posible avance del accidente.

La IAEA dijo que 150 personas de los alrededores del lugar han sido monitorizados. Se ha informado de los resultados de algunas personas y 23 de las mismas han pasado por el proceso de descontamización.

LA IAEA confirmó que el fuego en la unidad 4 tuvo lugar en la piscina de almacenamiento de combustible usado. El informe de estado de JAIF dice que se está suministrando agua para compensar los bajos niveles.

Similar a la necesidad de enfriar el núcleo del reactor, el grupo de combustible usado en los estanques de refrigeración requiere de una cobertura de agua para eliminar el calor de decaimiento. Las principales diferencias es que la cantidad de calor que tiene que eliminarse se reduce exponencialmente con el tiempo, y los estanques de combustible están en un espacio mucho menos cerrado que la vasija del reactor. A la vez, los estanques podrían contener combustible de hace varios años.

JAIF informó que las temperaturas en los estanques de enfriamiento de las unidades 5 y 6 están aumentando, pero no hay una razón actualmente disponible para esto.