Peter Rowlett nos presenta en

Nature siete ejemplos que demuestran que el trabajo teórico de los matemáticos puede conducir a aplicaciones prácticas inesperadas. Muchos científicos e ingenieros descubren que las herramientas matemáticas que necesitan fueron desarrolladas hace muchos años, incluso hace siglos, por matemáticos que no tenían en mente ninguna aplicación práctica concreta. La vida de las herramientas matemáticas, si no tienen errores, es eterna; una vez que la comunidad de matemáticos está satisfecha con una solución a cierto problema matemático, por dicha solución no pasan los años. Sin embargo, con la crisis económica ha crecido el interés en buscar aplicaciones a los desarrollos matemáticos en su etapa germinal, cuando aún son meras ideas abstractas. El problema es que para un matemático predecir para qué pueden servir sus ideas raya lo imposible. No se pueden forzar las cosas y algunas aplicaciones de las matemáticas actuales aparecerán dentro de décadas o incluso siglos. Para ilustrarlo, Peter Rowlett nos presenta los siguiente siete ejemplos en ”

The unplanned impact of mathematics,” Nature 475: 166–169, 14 July 2011. La

Sociedad Británica para la Historia de las Matemáticas tiene abierta una convocatoria con objeto de recopilar más ejemplos, si conoces alguno puedes enviarlo siguiendo este enlace “

The British Society for the History of Mathematics.”

Mark McCartney & Tony Mann: “De los cuaterniones a Lara Croft”

La

historia de cómo descubrió los cuaterniones el matemático irlandés William Rowan Hamilton (1805–1865) el 16 de octubre 1843 mientras estaba caminando sobre el Puente de “Broome” en Dublín es muy conocida. Hamilton había estado buscando una manera de extender el sistema de números complejos a tres dimensiones de tal forma que permitiera describir las rotaciones tridimensionales respecto a un eje arbitrario como los números complejos describen las rotaciones bidimensionales. Su idea feliz ahora nos resulta casi obvia, no era posible hacerlo con ternas de números, las rotaciones tridimensionales requieren un sistema de números con cuatro componentes imaginarias. Si los números complejos son de la forma

a +

i b, donde

a y

b son números reales, e

i es la raíz cuadrada de –1, entonces los cuaterniones deben tener la forma

a +

b i +

c j +

d k , donde las unidades imaginarias cumplen

i 2 =

j 2 =

k 2 =

ijk= –1.

Hamilton pasó el resto de su vida tratando de convencer a toda la comunidad de matemáticos de que los cuaterniones eran una solución elegante a múltiples problemas en geometría, mecánica y óptica. Tras su muerte, pasó el testigo a Peter Guthrie Tait (1831–1901), profesor de la Universidad de Edimburgo. William Thomson (Lord Kelvin) pasó más de 38 años discutiendo con Tait sobre la utilidad real de los cuaterniones. Kelvin prefería el cálculo vectorial, que a finales del siglo XIX eclipsó a los cuaterniones y los matemáticos del siglo XX, en general, consideran los cuaterniones como una hermosa construcción matemática sin ninguna utilidad práctica. Así fue hasta que por sorpresa, en 1985, el informático Ken Shoemake presentó la idea de interpolar rotaciones usando cuaterniones en el congreso de gráficos por computador más importante del mundo (el ACM SIGGRAPH). Interpolar matrices preservando la ortogonalidad de las matrices de rotación es muy engorroso y utilizar los ángulos de Euler ayuda poco. Las técnicas convencionales de interpolación para númeos reales se extienden de forma natural a los números complejos y a los cuaterniones. Interpolaciones suaves y rápidas de calcular que desde entonces se utilizan en todos los juegos por ordenador que presentan gráficos tridimensionales. En la actualidad, los cuaterniones son imprescindibles en robótica y en visión por ordenador, además de en gráficos por ordenador. Al final del s. XX, la guerra entre Kelvin y Tait fue ganada por este último. Hamilton vio cumplido su sueño en la industria de los videojuegos, 150 después de su descubrimiento, una industria que mueve más dinero en el mundo que la industria del cine (más de 100 mil millones de dólares en 2010).

Graham Hoare: “De la geometría a la gran explosión”

En 1907, Albert Einstein formuló el principio de equivalencia, un paso clave para el desarrollo de la teoría general de la relatividad. Su idea es simple en extremo, que los efectos de una aceleración son indistinguibles de los efectos de un campo gravitatorio uniforme, o dicho de otro modo, que la masa como “carga” gravitatoria y la masa inercial son equivalentes. Esta idea llevó a Einstein a concebir la gravedad como una curvatura del espaciotiempo. En 1915 publicó las ecuaciones de su teoría general que indican cómo la materia curva el espaciotiempo circundante. Las matemáticas que utilizó tienen su origen a mediados del siglo anterior. Bernhard Riemann introdujo los fundamentos de la geometría diferencial en 1854, en la defensa de su tesis de habilitación (una especie de tesis doctoral que era requisito para impartir clases en la universidad). Introdujo la geometría diferencial de espacios (hipersuperficies) de n dimensiones, llamadas variedades, y las nociones de métrica y curvatura. En los 1870, Bruno Christoffel extendió las ideas de Riemann e introdujo las conexiones afines y el concepto de transporte paralelo. El cálculo diferencial en variedades (o cálculo tensorial) alcanzó altas cotas de abstracción con los trabajos de Gregorio Ricci-Curbastro y su estudiante Tullio Levi-Civita (entre 1880 y los inicios del s. XX). Pero estas ideas tan abstractas no tenían ninguna aplicación práctica hasta que Albert Einstein en 1912, con la ayuda de su amigo matemático Marcel Grossman decidió utilizar este cálculo tensorial para articular su profunda visión física sobre el espaciotiempo. Gracias a las variedades de Riemann en cuatro dimensiones (tres para el espacio y una para el tiempo), Einstein revolucionó nuestras ideas sobre la gravedad y sobre la evolución del universo. Las ecuaciones de Einstein no tenían ninguna solución estática, por lo que Einstein introdujo en 1917 una término adicional, la constante cosmológica con objeto de compensar la expansión natural del universo. Tras los trabajos teóricos de otros físicos, como Alexander Friedmann en 1922, y los resultados experimentales de Edwin Hubble, Einstein decidió en 1931 eliminar la constante cosmológica y calificar su inclusión como “el mayor error de su vida.” Hoy en día, tras la gran sorpresa de 1998, el concepto de energía oscura ha reintroducido la constante cosmológica.

Edmund Harris: “De las naranjas a los módems”

En 1998, de repente, las matemáticas fueron noticia en todos los medios. Thomas Hales (Universidad de Pittsburgh, Pennsylvania) había demostrado la conjetura de Kepler, que afirma que la mejor forma de apilar naranjas en una caja es la utilizada en todas las fruterías (el empaquetamiento de esferas más eficiente posible). Un problema que había estado abierto desde 1611, cuando lo propuso Johannes Kepler. En algunos medios de prensa y TV se llegó a decir “creo que es una pérdida de tiempo y dinero de los contribuyentes.” Hoy en día, las matemáticas del empaquetamiento de esferas se utilizan en ingeniería de comunicaciones y teoría de la información y de la codificación para planificar canales de comunicación y para desarrollar códigos correctores de errores. El problema de Kepler fue mucho más difícil de demostrar de lo que Kepler nunca pudo imaginar. De hecho, el problema más sencillo sobre la mejor forma de empaquetar círculos planos fue demostrado en 1940 por László Fejes Tóth.

Otro problema sencillo cuya solución costó muchos años fue el

problema de las esferas que se besan, planteado en el siglo XVII por Isaac Newton y David Gregory: Dada una esfera, ¿cuántas esferas iguales que ésta pueden colocarse con la condición de que toquen a la inicial? En dos dimensiones es fácil demostrar que la respuesta es 6. Newton pensaba que 12 era el número máximo en 3 dimensiones. Lo es, pero la demostración tuvo que esperar al trabajo de Kurt Schütte y Bartel van der Waerden en 1953. Oleg Musin demostró en 2003 que el número de besos en 4 dimensiones es 24. En cinco dimensiones sólo se sabe que se encuentra entre 40 y 44. Sabemos la respuesta en ocho dimensiones, que es 240, como demostró Andrew Odlyzko en 1979. Más aún, en 24 dimensiones la respuesta es 196.560. Estas demostraciones son más sencillas que la del resultado en tres dimensiones y utilizan empaquetamiento de esferas mucho más complicados e increíblemente densos, la red E8 en 8 dimensiones y la red de Leech en 24 dimensiones.

Todo esto es muy bonito, pero ¿sirve para algo? En la década de 1960, un ingeniero llamado Gordon Lang diseñó los sistemas de comunicación por módem utilizando estos empaquetamientos de esferas multidimensionales. El problema de la comunicación analógica en una línea telefónica es el ruido. En una conversación entre dos personas el lenguaje natural es tan redundante que el ruido importa poco, pero para enviar datos es necesario introducir ciertas redundancias y utilizar técnicas correctoras de error, lo que reduce el ancho de banda del canal (la cantidad de información que se puede transmitir por segundo). Lang utilizó los empaquetamientos de esferas para lidiar con el ruido y aumentar al máximo el ancho de banda. Para ello utilizó una codificación basada en el empaquetamiento E8 (más tarde también se utilizó el de Leech). En la década de los 1970, el trabajo de Lang fue clave para el desarrollo temprano de la internet. Donald Coxeter, matemático que ayudó a Lang en su trabajo, dijo que estaba “horrorizado de que sus bellas teorías hubieran sido manchadas de esta manera por las aplicaciones.”

Juan Parrondo y Noel-Ann Bradshaw: “De una paradoja a las pandemias”

En 1992, dos físicos propusieron un dispositivo simple para convertir las fluctuaciones térmicas a nivel molecular en un movimiento dirigido: un motor browniano (

Brownian ratchet) basado en alternar el encendido y el apagado de cierto campo. En 1996, la esencia matemática de este fenómeno fue capturada en el lenguaje de la teoría de juegos por la paradoja de Parrondo. Un jugador alterna dos juegos, en ambos juegos por separado la esperanza a largo plazo implica perder, sin embargo, alternar ambos juegos permite lograr a largo plazo una victoria. En general, se utiliza el término “efecto de Parrondo” para describir el resultado dos pruebas que combinadas logran un resultado diferente al de dichas pruebas individuales. El “efecto Parrondo” tiene muchas aplicaciones, como en el control de sistemas caóticos ya que permite que la combinación de dos sistemas caóticos conduzca a un comportamiento no caótico. También puede ser utilizado para modelar en dinámica de poblaciones la aparición de brotes de enfermedades víricas o en economía para predecir los riesgos de ciertas inversiones en bolsa.

Peter Rowlett: “De los jugadores a las aseguradoras”

En el siglo XVI, Girolamo Cardano fue un matemático y un jugador compulsivo. Por desgracia para él, perdió en el juego la mayor parte del dinero que había heredado. Por fortuna para la ciencia escribió lo que se considera el primer trabajo en teoría de la probabilidad moderna, “

Liber de ludo aleae,” que acabó publicado en 1663. Un siglo después, otro jugador, Chevalier de Méré, tenía un truco que parecía muy razonable para ganar a los dados a largo plazo, pero perdió todo su dinero. Consultó a su amigo Blaise Pascal buscando una explicación. Pascal escribió a Pierre de Fermat en 1654. La correspondencia entre ellos sentó las bases de la teoría de la probabilidad. Christiaan Huygens estudió estos resultados y escribió la primera obra publicada sobre probabilidad,

“Ratiociniis De Ludo Aleae” (publicada en 1657).

En el siglo XVII, Jakob Bernoulli reconoció que la teoría de la probabilidad podría aplicarse mucho más allá de los juegos de azar. Escribió “

Ars Conjectandi” (publicado después de su muerte en 1713), que consolidó y amplió el trabajo en probabilidad de Cardano, Fermat, Huygens y Pascal. Bernoulli probó la ley de grandes números, que dice que cuanto mayor sea la muestra, más se parecerá el resultado muestral al de la población original. Las compañías de seguros deben limitar el número de pólizas que venden. Cada póliza vendida implica un riesgo adicional y el efecto acumulado podría arruinar la empresa. A partir del siglo XVIII, las empresas de seguros comenzaron a utilizar la teoría de probabilidades para sus políticas de ventas y para decidir los precios de los seguros con objeto de garantizar beneficios a largo plazo. La ley de Bernoulli de los grandes números es clave para seleccionar el tamaño de las muestras que permiten realizar predicciones fiables.

Julia Collins: “Desde un puente hasta el ADN”

Leonhard Euler inventó una nueva rama de las matemáticas cuando demostró en 1735 que no se podían atravesar los siete puentes de Königsberg en un solo viaje sin repetir ningún puente. En 1847, Johann Benedict Listing acuñó el término ”topología” para describir este nuevo campo. Durante los siguientes 150 años los matemáticos trabajaron en topología porque suponía un gran desafío intelectual, sin ninguna expectativa de que fuera a ser útil. Después de todo, en la vida real, la forma es muy importante (nadie confunde una taza de café con un dónut). ¿A quién le preocupan los agujeros de 5 dimensiones en un espacio de 11 dimensiones? Incluso ramas de la topología en apariencia muy prácticas, como la teoría de nudos, que tuvo su origen en los primeros intentos para comprender la estructura de los átomos, se pensó que eran inútiles durante la mayor parte de los XIX y XX.

Pero en la década de 1990, las aplicaciones prácticas de la topología comenzaron a aparecer. Lentamente al principio, pero ganando impulso hasta que ahora parece que hay pocas áreas de la ciencia en las que la topología no se utilice. Los biólogos utilizan la teoría de nudos para comprender la estructura del ADN. Los ingenieros en robótica utilizan la teoría para planificar las trayectores de los robots móviles. Las bandas de Möbius se utilizan para obtener cintas transportadoras más eficientes. Los médicos utilizan la teoría de la homología para hacer escaneos cerebrales y los cosmólogos las usan para comprender cómo se forman las galaxias. Las empresas de telefonía móvil utilizan la topología para identificar los lugares donde no hay cobertura de la red. E incluso en computación cuántica se están utilizando hilos trenzados para construir ordenadores cuánticos robustos. La topología permite usar los mismos teoremas para resolver problemas muy diversos, desde el ADN a los sistemas de GPS (Sistemas de Posicionamiento Global). ¿Hay alguna aplicación práctica donde no se utilice la topología?

Chris Linton: “Desde las cuerdas a la energía nuclear”

Las series de funciones seno y coseno fueron utilizadas por Leonard Euler y otros en el siglo XVIII para estudiar la dinámica de las vibraciones de cuerdas y para estudiar los movimientos de los cuerpos en mecánica celeste. Joseph Fourier, a principios del siglo XIX, reconoció la gran utilidad práctica de estas series para estudiar la conducción del calor y comenzó a desarrollar una teoría general de las mismas. A partir de entonces, las series de Fourier se utilizan por doquier, desde la acústica o la óptica, hasta los circuitos eléctricos. En la actualidad, los métodos de Fourier están en la base de gran parte de la ciencia y de la ingeniería modernas, en especial de las técnicas computacionales.

Sin embargo, las matemáticas de principios del siglo XIX eran inadecuadas para el desarrollo riguroso de las ideas de Fourier y aparecieron gran número de problemas de carácter técnico que desafiaron a muchas de las grandes mentes de la época. Costó mucho desarrollar nuevas técnicas matemáticas para poder resolver estas dificultades. En la década de 1830, Gustav Lejeune Dirichlet obtuvo la primera definición clara y útil del concepto de función. Bernhard Riemann en la década de 1850 y Henri Lebesgue en la década de 1900 obtuvieron nociones rigurosas de la integración de funciones. La convergencia de series infinitas resultó muy resbaladiza al principio, pero se logró dominar gracias a Augustin-Louis Cauchy y a Karl Weierstrass, que trabajaron en la décadas de 1820 y 1850, respectivamente. En la década de 1870, los primeros pasos de Georg Cantor hacia una teoría abstracta de los conjuntos se iniciaron con el análisis de las diferencias entre funciones que no son iguales pero cuyas series de Fourier son idénticas.

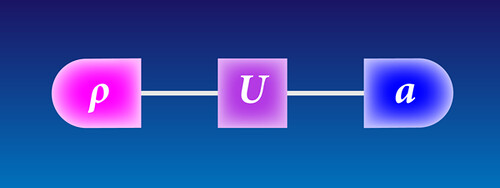

En la primera década del siglo XX, el concepto de espacio de Hilbert fue clave para entender las propiedades de las series de Fourier. El matemático alemán David Hilbert y sus colegas definieron estos espacios de forma axiomática, algo que parecía muy alejado de las aplicaciones prácticas. Sin embargo, en la década de 1920, Hermann Weyl, Paul Dirac y John von Neumann reconocieron que este concepto era la piedra angular de la mecánica cuántica, ya que los estados posibles de un sistema cuántico son elementos de cierta clase de espacios de Hilbert. La mecánica cuántica es la teoría científica más exitosa de todos los tiempos. Sin ella, gran parte de nuestra tecnología moderna (el láser, los ordenadores, los televisores de pantalla plana, la energía nuclear, etc.) no existiría. Quien podía imaginar que problemas matemáticos abstractos relacionados con las propiedades matemáticas de las series de Fourier acabarían revolucionando la ciencia y la ingeniería del siglo XX, y acabarían conduciendo a la energía nuclear.

La

La  En 1998, de repente, las matemáticas fueron noticia en todos los medios. Thomas Hales (Universidad de Pittsburgh, Pennsylvania) había demostrado la conjetura de Kepler, que afirma que la mejor forma de apilar naranjas en una caja es la utilizada en todas las fruterías (el empaquetamiento de esferas más eficiente posible). Un problema que había estado abierto desde 1611, cuando lo propuso Johannes Kepler. En algunos medios de prensa y TV se llegó a decir “creo que es una pérdida de tiempo y dinero de los contribuyentes.” Hoy en día, las matemáticas del empaquetamiento de esferas se utilizan en ingeniería de comunicaciones y teoría de la información y de la codificación para planificar canales de comunicación y para desarrollar códigos correctores de errores. El problema de Kepler fue mucho más difícil de demostrar de lo que Kepler nunca pudo imaginar. De hecho, el problema más sencillo sobre la mejor forma de empaquetar círculos planos fue demostrado en 1940 por László Fejes Tóth.

En 1998, de repente, las matemáticas fueron noticia en todos los medios. Thomas Hales (Universidad de Pittsburgh, Pennsylvania) había demostrado la conjetura de Kepler, que afirma que la mejor forma de apilar naranjas en una caja es la utilizada en todas las fruterías (el empaquetamiento de esferas más eficiente posible). Un problema que había estado abierto desde 1611, cuando lo propuso Johannes Kepler. En algunos medios de prensa y TV se llegó a decir “creo que es una pérdida de tiempo y dinero de los contribuyentes.” Hoy en día, las matemáticas del empaquetamiento de esferas se utilizan en ingeniería de comunicaciones y teoría de la información y de la codificación para planificar canales de comunicación y para desarrollar códigos correctores de errores. El problema de Kepler fue mucho más difícil de demostrar de lo que Kepler nunca pudo imaginar. De hecho, el problema más sencillo sobre la mejor forma de empaquetar círculos planos fue demostrado en 1940 por László Fejes Tóth. Leonhard Euler inventó una nueva rama de las matemáticas cuando demostró en 1735 que no se podían atravesar los siete puentes de Königsberg en un solo viaje sin repetir ningún puente. En 1847, Johann Benedict Listing acuñó el término ”topología” para describir este nuevo campo. Durante los siguientes 150 años los matemáticos trabajaron en topología porque suponía un gran desafío intelectual, sin ninguna expectativa de que fuera a ser útil. Después de todo, en la vida real, la forma es muy importante (nadie confunde una taza de café con un dónut). ¿A quién le preocupan los agujeros de 5 dimensiones en un espacio de 11 dimensiones? Incluso ramas de la topología en apariencia muy prácticas, como la teoría de nudos, que tuvo su origen en los primeros intentos para comprender la estructura de los átomos, se pensó que eran inútiles durante la mayor parte de los XIX y XX.

Leonhard Euler inventó una nueva rama de las matemáticas cuando demostró en 1735 que no se podían atravesar los siete puentes de Königsberg en un solo viaje sin repetir ningún puente. En 1847, Johann Benedict Listing acuñó el término ”topología” para describir este nuevo campo. Durante los siguientes 150 años los matemáticos trabajaron en topología porque suponía un gran desafío intelectual, sin ninguna expectativa de que fuera a ser útil. Después de todo, en la vida real, la forma es muy importante (nadie confunde una taza de café con un dónut). ¿A quién le preocupan los agujeros de 5 dimensiones en un espacio de 11 dimensiones? Incluso ramas de la topología en apariencia muy prácticas, como la teoría de nudos, que tuvo su origen en los primeros intentos para comprender la estructura de los átomos, se pensó que eran inútiles durante la mayor parte de los XIX y XX.