| Owncloud es una aplicación de software libre que te permitirá crear un servidor de archivos en la nube, en el cuál podrás tener un almacén de imágenes, documentos o incluso tu música, datos a los que tendrás acceso desde cualquier lugar con internet. |

Muchos de los lectores seguramente ya conocerán y algunos tal vez usarán soluciones de almacenamiento de archivos en la nube, servicios como UbuntuOne, Dropbox o SpiderOak, en los cuales puedes almacenar tus fotos, documentos e incluso tu música para poder acceder a tus ellos desde cualquier computadora con internet.

Bueno, pero ahora el problema, resulta que la principal limitación de estos servicios es el espacio, pues en algunos casos estas empresas ofrecen cuentas gratuitas pero con espacio de almacenamiento de entre 2 a 5 GB, eso si, si quieres más espacio tendrás que pagar. Otro aspecto importante, tal vez el más importante desde mi punto de vista, es la privacidad. Desafortunadamente las empresas son creadas para producir dinero y esto es lo que las mueve, así que tus datos podrían ser incluso vendidos al mejor postor, eso sin contar que las aplicaciones que desarrollan estas compañías para sincronizar los datos por lo general no son Software Libre.

Por suerte, existe una aplicación que es Software Libre y que cubre perfectamente la función de almacenamiento de datos en la nube, hablo de OwnCloud. Entre sus principales características se encuentran:

- Una agradable y fácil interfaz web

- Compartición de archivo a usuarios y no usuarios de OwnCloud

- Visor de archivos PDF

- Calendario/Agenda

- Gestión de contactos

- Acceso a tus archivos mediante WebDAV

- Reproductor de música integrado

- Una galería donde podrás visualizar tus imágenes

- Un sencillo editor de textos

- La seguridad de que tus datos están en tu servidor y no en manos de desconocidos.

¿Te gustaría tener un servidor de datos en la nube en el que tu tengas total control?

Instalación

Esta guía ha sido probada en Debian Squezee y varias versiones de Ubuntu, como prerrequisitos deberemos tener instalado y funcionando el servidor web Apache y el gestor de bases de datos MySQL.1.- Instalar dependencias

apt-get install php-pear php-xml-parser php5-sqlite php5-json sqlite mp3info curl libcurl3-dev zip

2.- Crear la base de datos con MySQL

En terminal usamos el siguiente comando:

mysql -u root -p

pedirá contraseña

entonces aparecerá la línea de comandos de mysql, donde añadiremos las siguientes instrucciones:

mysql> create database nombre_de_nuestra_base_de_datos;

Reponderá: Query OK, 1 row affected (0.00 sec)

cerramos mysql con:

mysql> quit

3.- Descargar y descomprimir Owncloud

Descargamos el paquete owncloud-x.tar.bz2 y posteriormente lo descomprimimos.

tar -xvf owncloud-x.tar.bz2

4.- Copiar el directorio owncloud a nuestro servidor Apache como root

mv owncloud /var/www

5.- Le damos permisos del servidor web al directorio owncloud:

chown -R www-data:www-data owncloud

6.- Reiniciamos nuestro servidor apache:

/etc/init.d/apache2 restart

7.- Terminar la instalación

Desde la barra de direcciones de un navegador web tecleamos:

ip.de.tu.server/owncloud (si accedes desde otra computadora de la red)

localhost/owncloud (si accedes desde la computadora donde está instalado owncloud)

Entonces se nos mostrará la interfaz web para terminar con la instalación.

Creamos una cuenta de administrador y seleccionamos la opción “Avanzado”. Luego, ingresamos nombre de usuario, nombre de base de datos y contraseña de la base de datos y pulsamos el botón “Completar la instalación”.

Una vez dentro de nuestra cuenta de administrador podremos configurar el servicio y crear usuarios. Para asegurar el acceso desde internet deberemos contar con el servicio de DNS dinámico, como No-IP. Una vez que tenemos nuestra cuenta en este servicio podremos ingresar desde cualquier lugar con internet a nuestro servidor OwnCloud usando un navegador con la dirección:

http://nombre_elegido_en_No-IP.no-ip.org/owncloud

8.- Aumentar el limite de peso de archivos a subir.

Por defecto, el peso de los archivos a subir es muy pequeño. Podemos corregir esto editando el archivo /etc/php5/apache2/php.ini donde buscaremos las líneas:

“upload_max_filesize” “post_max_size”

y cambiamos al tamaño que consideremos adecuado.

¡Listo! Ingresamos desde un navegador a la dirección http://ip.del.servidor.owncloud/owncloud y podremos acceder a la interfaz web para comenzar a subir nuestros archivos con la seguridad que conlleva tenerlos en nuestro servidor propio.

Capturas

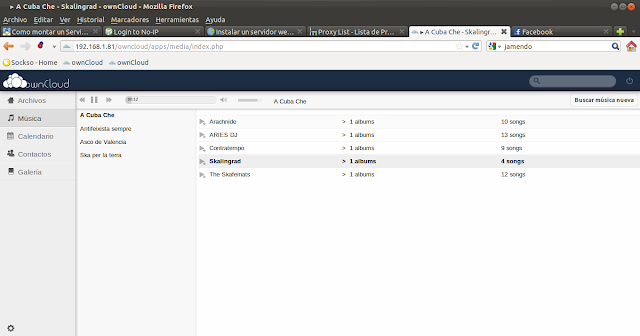

Dejo algunas capturas del servidor OwnCloud funcionando.

Pantalla de login de OwnCloud

Interfaz de administración del almacenamiento de datos

Lector de PDF's integrado en la interfaz web de OwnCloud

Galería de imágenes

Reproductor de Música también integrado en la interfaz web

Compartición de archivos

Calendario/Agenda

Conclusión

OwnCloud es una excelente alternativa a UbuntuOne, SpiderOak, Dropbox o incluso el ya finado Megaupload, es relativamente fácil de instalar y proporciona todas las prestaciones de cualquier servicio de paga.Esten atentos que en una entrega próxima mostrare cómo instalar y hacer andar el servicio de DNS dinámico con No-IP.