Fuente: Ciencia Kanija

Artículo publicado el 29 de agosto de 2012 en ESO

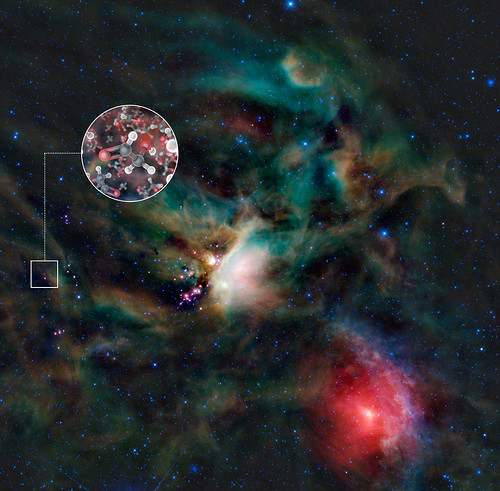

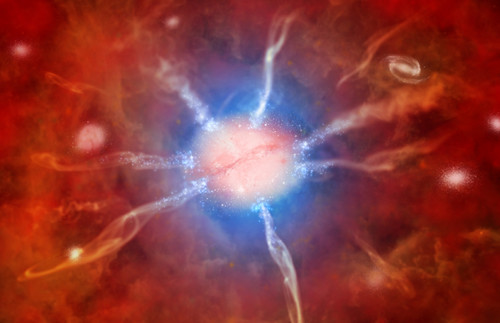

Se encuentran elementos esenciales para la vida alrededor de una estrella joven.

Usando el radiotelescopio ALMA (Atacama Large Millimeter/submillimeter Array),

un grupo de astrónomos detectó moléculas de azúcar presentes en el gas

que rodea a una estrella joven, similar al sol. Esta es la primera vez

que se ha descubierto azúcar en el espacio alrededor de una estrella de

estas características.

Tal hallazgo demuestra que los elementos

esenciales para la vida se encuentran en el momento y lugar adecuados

para poder existir en los planetas que se forman alrededor de la

estrella.

Los astrónomos encontraron moléculas de glicolaldehído (un azúcar simple) en el gas que rodea a una joven estrella binaria joven llamada IRAS 16293-2422, que posee una masa similar a la del Sol. El glicolaldehído ya se había divisado en el espacio interestelar anteriormente, sin embargo, esta es la primera vez que se localiza tan cerca de una estrella de este tipo, a distancias equivalentes a las que separan Urano del Sol en nuestro propio Sistema Solar. El descubrimiento prueba que algunos de los compuestos químicos necesarios para la vida, ya existían en este sistema al momento de la formación de los planetas.

“En el disco de gas y polvo que rodea

esta estrella de formación reciente encontramos glicolaldehído, un

azúcar simple que no es muy distinto al que ponemos en el café”, señala

Jes Jørgensen (Instituto Niels Bohr, Dinamarca), autor principal del

trabajo. “Esta molécula es uno de los ingredientes en la formación del

ácido ribonucleico (ARN), que como el ADN, con el cual está relacionado,

es uno de los ingredientes fundamentales para la vida”.

La gran sensibilidad de ALMA (incluso en

las longitudes de onda más cortas a las que opera — que representan

grandes desafíos técnicos) fue esencial para estas observaciones, las

que se realizaron con un conjunto parcial de antenas durante la llamada

fase de verificación científica del observatorio.

“Lo que es realmente fascinante de

nuestros hallazgos es que las observaciones realizadas con ALMA revelan

que las moléculas de azúcar están cayendo en dirección a una de las

estrellas del sistema”, comenta Cécile Favre, miembro del equipo

(Universidad de Aarhus, Dinamarca). “Las moléculas de azúcar no sólo se

encuentran en el lugar indicado para encontrar su camino hacia un

planeta, sino que además van en la dirección correcta”.

Las nubes de gas y polvo que colapsan

para formar nuevas estrellas son extremadamente frías, por lo que muchos

de estos gases se solidifican formando hielo en las partículas de

polvo, donde luego se combinan y originan moléculas más complejas. Sin

embargo, una vez que una estrella se forma en medio de una nube de gas y

polvo, ésta calienta el interior de la nube giratoria elevándo su

temperatura. Cuando esto ocurre, las moléculas químicamente complejas se

evaporan en forma de gas. Este gas emite radiación en forma de ondas de

radio, las que pueden ser captadas utilizando poderosos

radiotelescopios como ALMA.

La estrella IRAS 16293-2422 se encuentra

ubicada a unos 400 años- luz aproximadamente (relativamente cerca de la

Tierra), lo que la hace un excelente objeto de estudio para los

astrónomos que investigan la química y las moléculas que rodean a las

estrellas jóvenes. Al aprovechar la gran capacidad de una nueva

generación de telescopios como ALMA, hoy en día los astrónomos tienen la

oportunidad de estudiar detalles precisos, dentro de las nubes de gas y

polvo que originan sistemas planetarios.

“Se plantea una gran interrogante: ¿Cuán

complejas pueden llegar a ser estas moléculas antes de que se

incorporen a nuevos planetas? Esto podría darnos una idea con respecto a

la forma en que la vida pudiese originarse en otras partes, y las

observaciones de ALMA serán de vital importancia para develar este

misterio”, indica Jes Jørgensen.

El trabajo será publicado en un artículo de la revista ‘Astrophysical Journal Letters‘.

Fecha Original: 29 de agosto de 2012

Enlace Original