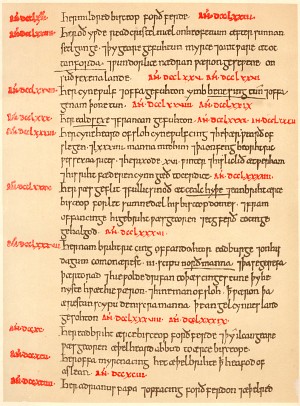

Un pico durante el siglo VIII en los

niveles de carbono-14 encontrados en los árboles podría explicarse

mediante la supernova del “crucifijo rojo”.

Un sobrecogedor “crucifijo rojo” visto

en el cielo nocturno de Gran Bretaña en el año 774 d.C puede ser una

explosión de supernova no conocida anteriormente — y podría explicar un

misterioso pico en los niveles de carbono-14 en los anillos de

crecimiento de esos años en cedros japoneses. El vínculo se sugiere hoy

en una Correspondencia en la revista Nature de un estudiante estadounidense con un amplio trasfondo interdisciplinar y una mente inquisitiva1.

Hace unas semanas, Jonathon Allen, estudiante de bioquímica en la Universidad de California en Santa Cruz, estaba escuchando el podcast de Nature cuando

escuchó que un equipo de investigadores de Japón había encontrado un

pico en los niveles de carbono-14 en anillos de árboles. El pico

probablemente procedía de un estallido de radiación de alta energía que

impactó en la atmósfera superior, aumentando la tasa a la que se forma

el carbono-14.

Pero había un problema: las únicas causas conocidas para tales niveles de radiación son las explosiones de supernova o las llamaradas solares gigantes, y los investigadores no tenían conocimiento de que hubiese tenido lugar alguno de estos eventos en los años 774 ó 775 d.C, las fechas indicadas por los anillos de los árboles.

Intrigado, Allen buscó en Internet. “Simplemente hice una búsqueda rápida en Google”, comenta.

Su interés por la historia fue de ayuda,

apunta. “Sabía que cuando te remontas tanto en el tiempo, hay muy poca

historia escrita”, dice. “Lo único que he visto u oído eran textos

religiosos y ‘crónicas’ que listaban reyes y reinas, guerras y cosas de

ese tipo”.

Su búsqueda encontró entradas del siglo

VIII en la Crónica Anglo-Sajona en el Proyecto Avalon, una biblioteca en

línea de documentos legales e históricos alojada en la Universidad de

Yale en New Haven, Connecticut. Bajando hasta el año 774 d.C, Allen

encontró una referencia a un “crucifijo rojo” que apareció en los cielos

“tras la puesta del Sol.

Oculto en los cielos

“Esto me hizo pensar en algún tipo de

evento estelar”, comenta Allen. Además, señala, el color rojizo podría

indicar que la fuente estaba oculta tras una densa nube de polvo que

dispersara toda la luz salvo una pequeña cantidad de luz roja. Tal nube

podría también evitar que los restos de la supernova propuesta sean

observados por los astrónomos modernos.

Los científicos del campo están

impresionados. Geza Gyuk, astrónomo del Planetario Adler de Chicago en

Illinois, que ha usado la Crónica Anglo-Sajona para investigar eventos

astronómicos del pasado, dice que Allen podría haber dado con algo. “El

texto sugiere que el objeto se observó en los cielos occidentales poco

después de la puesta de Sol”, dice. “Esto implicaría que tendría que

haberse movido por detrás del Sol [donde no podría observarse] conforme

la Tierra orbita a nuestra estrella. Esto, junto con lo tenue de la

‘nueva estrella’ debido al polvo sería una buena explicación a por qué

nadie habría visto o registrado el evento”.

No obstante, dice Donald Olson, físico

con interés en la astronomía histórica de la Universidad Estatal de

Texas en San Marcos: “Las crónicas antiguas son difíciles de interpretar

de forma inequívoca”.

Ya en 1870, dice, John Jeremiah publicó un artículo en Nature

en referencia al mismo texto de las Crónicas Anglo-Sajonas. Jeremiah

propuso que podría ser una primera descripción de las Luces del Norte2.

“Otra posible explicación podría ser un

espectáculo de cristales de hielo”, añade Olson, señalando que el

“crucifijo” rojo podría haberse formado al iluminar la luz del Sol

poniendo partículas de hielo a gran altitud, en bandas tanto

horizontales como verticales.

Pero podría también haber sido una

supernova no reconocida con anterioridad. Muchas de las supernovas que

ahora conocen los astrónomos “simplemente faltan” en los registros

históricos, dice Gyuk. “El cielo es un lugar muy grande y los registros

históricos no son muy buenos”.

Nature doi:10.1038/nature.2012.10898

Artículos de Referencia:

1.- Allen, J. Nature 486, 473 (2012).

2.- Jeremiah, J. Nature 3, 174–175 (1870)

Autor: Richard A. Lovett

Fecha Original: 27 de junio de 2012

Artículo Original

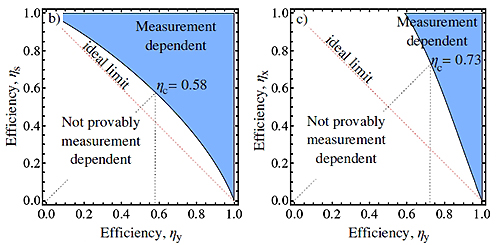

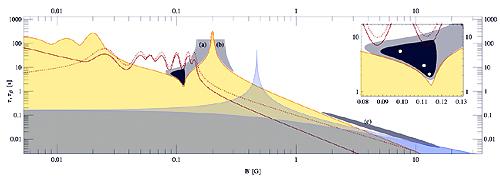

La inflación cósmica fue introducida hace 30 años por Alan H. Guth (entonces postdoc en el SLAC, Stanford Linear Accelerator Center).

Una hiperaceleración brevísima de la expansión del universo en los

primeros instantes de la gran explosión (big bang). La inflación forma

parte del modelo cosmológico de consenso, aunque muchos teóricos, el más

famoso es Roger Penrose, dudan de ella. ¿Se puede

La inflación cósmica fue introducida hace 30 años por Alan H. Guth (entonces postdoc en el SLAC, Stanford Linear Accelerator Center).

Una hiperaceleración brevísima de la expansión del universo en los

primeros instantes de la gran explosión (big bang). La inflación forma

parte del modelo cosmológico de consenso, aunque muchos teóricos, el más

famoso es Roger Penrose, dudan de ella. ¿Se puede