Fuente:

http://danielmarin.blogspot.com/2011/05/luna-roja.html

En los años 60 del siglo XX tuvo lugar un acontecimiento único en la historia de la humanidad. Espoleadas por su enfrentamiento mundial en plena Guerra Fría, las dos superpotencias decidieron llevar su rivalidad al espacio con el fin de intentar poner un hombre en la Luna. La competición finalizaría cuando Neil Armstrong puso un pie en el Mar de la Tranquilidad en julio de 1969. Durante años, la Unión Soviética negó que hubiese participado en la carrera lunar y muchos pensaron que Estados Unidos había competido en solitario. Pero estaban equivocados. La URSS se esforzó por adelantarse al programa Apolo de la NASA… aunque no se puede decir que lo intentara con todas sus fuerzas. Ésta es la historia del programa lunar soviético.

Esta entrada ha sido realizada conjuntamente por Paco Arnau de Ciudad Futura y Daniel Marín de Eureka. Vuestros comentarios serán bienvenidos en ambos sitios. Este trabajo común parte de nuestra convicción de que la Red debe servir para colaborar y compartir ideas, conocimientos e iniciativas.

Viajar a la Luna

En

1960, la oficina de diseño OKB-1 del mítico ingeniero jefe Serguéi

Pávlovich Koroliov había conseguido lo inimaginable. En el transcurso de

sólo tres años fue capaz de poner en órbita el primer satélite

artificial de la Tierra (el Sputnik), el primer ser vivo en el espacio

(Laika) y las primeras sondas hacia la Luna, entre otros muchos logros.

El siguiente objetivo era lanzar un hombre al espacio y para ello estaba

diseñando un nuevo tipo de nave, la Vostok 3KA

(Восток, "oriente"). Todos estos éxitos eran el resultado directo de la

enorme potencia del cohete R-7 Semiorka, el primer misil

intercontinental de la historia, también obra de Koroliov.

En

realidad, en un principio el gobierno soviético no había mostrado

ningún interés especial en explorar el espacio. El trabajo de Koroliov

debía limitarse a diseñar misiles para los militares, que eran los que

pagaban las costosas facturas del proyecto. Pero la impresionante

repercusión mediática del Sputnik pronto hizo cambiar de opinión a

Jruschov, quien vio en las hazañas espaciales una magnífica oportunidad

para promocionar los triunfos del modelo soviético en el mundo entero.

Al otro lado del Atlántico, los políticos estadounidenses llegaron a la

misma conclusión, aunque quizás un poco más tarde. El espacio se había

convertido en el nuevo campo de batalla mediático de la Guerra Fría.

Gagarin y el Apolo

El 12 de abril de 1961 despegaba la primera nave tripulada de la humanidad, la Vostok 1. El vuelo de Yuri Gagarin

desataría una serie de acontecimientos que cambiarían la historia de la

exploración del espacio para siempre. A veces se habla del "momento

Sputnik" para definir la sensación de impotencia y humillación que

sufrió EEUU cuando la URSS se les adelantó a la hora de poner en órbita

el primer satélite artificial. Sin embargo, el "momento Gagarin" fue

mucho peor. En esta ocasión, los estadounidenses no podían esgrimir la

excusa de que el lanzamiento les había cogido por sorpresa.

El

gobierno norteamericano había creado en 1958 una agencia espacial

civil, la NASA, con el objetivo expreso de ganar a "los rusos" en la

carrera por poner un hombre en órbita. La conmoción en todo el país fue

mayúscula. Quizás, después de todo, la URSS era una nación mucho más

avanzada tecnológicamente y no había nada que hacer al respecto.

Intentando

refutar esta idea, el 25 de mayo de 1961 el presidente John F. Kennedy

pronunció su famoso discurso ante el Congreso de EEUU, embarcando a toda

la nación en una aventura increíble. “Antes de que termine la década”,

anuncia Kennedy, “pondremos un hombre en la superficie lunar y lo

traeremos de vuelta sano y salvo”. Un desafío simple a la vez que

ambicioso. Visto desde la perspectiva actual, el discurso de Kennedy

quizás no parezca demasiado revolucionario, pero hay que tener en cuenta

que en el momento de pronunciarlo ningún ciudadano estadounidense había

alcanzado la órbita terrestre.

Kennedy

había lanzado el reto y ahora había que llevarlo a cabo. Poco después,

la NASA aprobaría el programa Apolo para poner un hombre en la Luna.

Nadie sabía cuál sería la respuesta soviética... aunque estaba claro que

aceptarían el desafío.

Alrededor de la Luna: 1L y 7K-9K-11K

En

la URSS los primeros planes realistas para viajar a la Luna se

remontaban a 1958, cuando Koroliov había encargado un estudio sobre la

viabilidad de una misión de este tipo. En 1959, el Departamento nº 9 de

la OKB-1, dirigido por Mijaíl Tijonrávov, había propuesto un proyecto de

sobrevuelo lunar utilizando varios cohetes R-7 para ensamblar en órbita

baja una nave capaz de dirigirse hacia la Luna.

En

un principio se pensó en utilizar la nueva Vostok 3KA para esta misión,

pero la Vostok no era la mejor nave para misiones más allá de la órbita

baja. Su forma esférica era inadecuada para soportar la tremenda

deceleración que debía sufrir un cosmonauta al regresar de la Luna

durante una reentrada atmosférica a 11 km/s, cercana a veinte veces la

aceleración de la gravedad terrestre.

Por

suerte, la OKB-1 finalizó en 1962 el diseño de la siguiente nave

tripulada soviética, la Soyuz (Союз, “Unión”), dotada de una cápsula en

forma de campana que le permitiría cierta capacidad de maniobra durante

el descenso a través de la atmósfera. A diferencia de las Gemini y Apolo

norteamericanas, formadas por dos módulos (la cápsula tripulada y el

módulo de servicio), la Soyuz estaba dividida en tres secciones: módulo

orbital (BO), aparato de descenso (SA) y módulo propulsivo (PAO); lo que

permitía maximizar el volumen interno de la nave al mismo tiempo que se

limitaba la masa total del vehículo. Curiosamente, la NASA descartó un

diseño similar para su nave Apolo (la Apollo D-2 de General Electric), prefiriendo una configuración mucho más conservadora propuesta por la empresa North American.

Pronto

se propuso usar la Soyuz —por aquel entonces todavía denominada Séver

(Север, “norte”)— para realizar una misión de sobrevuelo de nuestro

satélite. El proyecto se llamó 1L y preveía el lanzamiento de tres

cohetes derivados del R-7 con el fin de poner en órbita dos módulos no

tripulados con combustible y una nave Séver. El proyecto 1L permitía

realizar una misión lunar usando solamente cohetes R-7 y pequeños

módulos, pero por aquel entonces las operaciones de acoplamiento y

trasvase de combustible en órbita baja eran un desafío tecnológico de

primer orden. No obstante, Koroliov cambió repentinamente de opinión y

ante los retrasos en el desarrollo de la Soyuz decidió modificar el

programa 1L sustituyendo la nave Séver por una nave Vostok modificada

denominada 7K. Este plan sería presentado el 10 de marzo de 1962 y en él

aparece por primera vez el nombre de "Soyuz", aunque como vemos se

utilizó para designar un proyecto protagonizado por una variante de la

nave Vostok. Para evitar confusiones, este plan suele recibir el nombre

de Vostok-7.

Pero

este proyecto no duraría mucho y a mediados de 1962 Koroliov vuelve a

cambiar de idea. Como resultado, el 24 de diciembre de 1964 sería

aprobado un nuevo plan de sobrevuelo lunar denominado 7K-9K-11K para

mandar a dos cosmonautas alrededor de la Luna. La 7K —no confundir con

la Vostok 7K anterior— sería una variante de la nave Séver con una masa

de 5,5-5,8 toneladas y una longitud de 7,7 metros. Su forma sería

básicamente similar a la Soyuz que todos conocemos, aunque el módulo

orbital tenía forma cilíndrica y no esférica. La 9K sería un módulo de

propulsión que aceleraría la nave 7K hasta los 11 km/s y la situaría en

una trayectoria hacia la Luna. La 9K tendría una masa de 5.800 kg, 7,8

metros de longitud y estaría dividida en dos secciones: 9KN —desechable—

y 9KM. Los tanques de combustible de la 9K estarían vacíos, por lo que

se tendría que acoplar con cuatro naves 11K para trasvasar los

propergoles necesarios. Cada una de las 11K tendría una masa de 6.100 kg

y 4,5 metros de longitud. Conviene señalar que en ocasiones se suele

denominar incorrectamente al proyecto 7K-9K-11K como Soyuz A-B-V (A, B y

V son las tres primeras letras del alfabeto cirílico), pero ésta es una

clasificación inventada por algunos autores soviéticos a principios de

los años 80 cuando el proyecto 7K-9K-11K era aún secreto de Estado.

Objetivo: pisar la Luna

|

De izquierda a derecha: Serguéi Koroliov, Vasili Mishin, Valentin Glushko y

Vladímir Cheloméi |

El

proyecto 7K-9K-11K era ambicioso pero no lo suficiente. Mientras los

soviéticos ideaban planes para circunnavegar la Luna, la NASA tenía como

objetivo poner un hombre sobre nuestro satélite. Si la URSS no hacía

nada para remediarlo, el triunfo de la NASA sería aplastante. Porque una

cosa es lanzar una nave alrededor de la Luna y otra muy distinta aterrizar en

su superficie. Las inexorables leyes de la mecánica celeste implican

que el gasto energético en este último caso es increíblemente mayor.

Para pisar la Luna sería necesario emplear un cohete mucho más grande y

potente que el venerable R-7 Semiorka. A principios de los años 60, la NASA ya había comenzado a diseñar los cohetes gigantes Nova y Saturno bajo la supervisión del ingeniero alemán Wernher von Braun, artífice del tristemente famoso misil nazi V-2 (A-4).

Por

supuesto, la OKB-1 era consciente de este problema y desde 1960 venía

diseñando un cohete gigante denominado N1 (la "N" viene de носитель; nositel,

"portador", "lanzador") u 11A51 y que debía servir como base para una

familia de lanzadores más pequeños, como el N2 y el N3. El N1 fue

diseñado en principio para una misión a Marte, el objetivo preferido de

Koroliov, pero la competición con los norteamericanos y la proximidad de

nuestro satélite hacían del N1 un candidato perfecto para ser usado en

una misión lunar y terminaría por convertirse en la réplica soviética al

famoso Saturno V

de la NASA. No obstante, el proyecto N1 pronto tuvo que enfrentarse a

un conflicto que resultaría decisivo y que en última instancia sellaría

el destino del programa lunar soviético.

Glushkó y Koroliov: el enfrentamiento lunar

El

principal fabricante de motores cohete en la Unión Soviética era la

oficina OKB-456, dirigida por Valentín Petróvich Glushkó. Koroliov y

Glushkó tenían a sus espaldas una turbulenta relación que se remontaba a

los años 30, cuando fueron colegas de trabajo en el RNII, el primer

instituto de investigación del mundo dedicado exclusivamente al

desarrollo de cohetes. En 1938, en pleno apogeo del terror estalinista,

ambos fueron arrestados por el NKVD bajo la absurda acusación de ser

saboteadores a sueldo de una potencia extranjera. Para complicar las

cosas, Glushkó sería uno de los ingenieros que delató a Koroliov durante

los interrogatorios.

Sin embargo, tras una brutal estancia en el Gulag

que estuvo a punto de costarle la vida en varias ocasiones, Koroliov

volvería a trabajar con Glushkó durante la Segunda Guerra Mundial,

aunque esta vez como subordinado suyo. Terminada la guerra, los dos

hombres se convertirían en los protagonistas del esfuerzo soviético para

hacerse con la tecnología del cohete V-2 alemán, aunque el proceso

culminaría con la construcción del R-7, un lanzador multietapa que

dejaba muy atrás el diseño de los V-2 y cuyos motores RD-107 y RD-108

serían obra de Glushkó.

Koroliov se mostraba partidario de emplear queroseno y oxígeno líquido en sus cohetes debido a su gran eficiencia (alto impulso específico),

mientras que Glushkó prefería el uso de combustibles hipergólicos (la

mayoría derivados del ácido nítrico y la hidracina). Este tipo de

propergoles es capaz de entrar en ignición cuando se mezclan, motivo por

el cual permiten en principio la construcción de motores más simples.

Además pueden permanecer casi indefinidamente almacenados en el interior

de un cohete, una característica muy útil para un misil balístico. Pero

hay que pagar un precio muy alto por estas ventajas: los combustibles

hipergólicos son menos eficientes además de ser altamente tóxicos.

Koroliov se oponía vehementemente a emplear en sus ingenios “el veneno

del diablo”, como los solía llamar.

Koroliov

pensaba que el rechazo de Glushkó a este tipo de combustibles se basaba

en su incapacidad a la hora de diseñar motores criogénicos potentes. De

hecho, el ingeniero jefe había quedado bastante decepcionado con el

trabajo de Glushkó en el proyecto R-7. En realidad —y aunque el punto de

vista de Koroliov no era del todo equivocado— la decisión de Glushkó

tenía un origen más pragmático. En aquella época la mayor parte de

motores de la OKB-456 se destinaba a misiles hipergólicos fabricados por

las oficinas de Mijaíl Yangel (OKB-586) y Vladímir Cheloméi (OKB-52).

Consecuentemente, Glushkó consideraba que la construcción de grandes

motores criogénicos era una pérdida de tiempo y de recursos para su

oficina, así que presionó con todas sus fuerzas para que Koroliov

también emplease combustibles hipergólicos como el resto de sus

"clientes".

La

rivalidad entre Koroliov y Glushkó ha adquirido con el tiempo la

categoría de leyenda y no resulta extraño que algunos autores confundan

los hechos con medias verdades. Contrariamente a lo que mucha gente

piensa, el conflicto entre los dos ingenieros no nació con el cohete N1,

sino que se remonta a la fase de diseño del misil R-9. El R-9 debía ser la respuesta de la OKB-1 al exitoso R-16 de

Yangel (el primer misil intercontinental soviético operativo), pero el

enfrentamiento por el tipo de combustible obligó a Koroliov a recurrir a

otro fabricante. Cansado de las disputas con Glushkó, Koroliov se

dirigió a la oficina OKB-276 de Nikolái Kuznetsov. La OKB-276 tenía por

entonces una gran experiencia en la construcción de motores a reacción

para aviones pero era una recién llegada al campo de los motores

cohete.

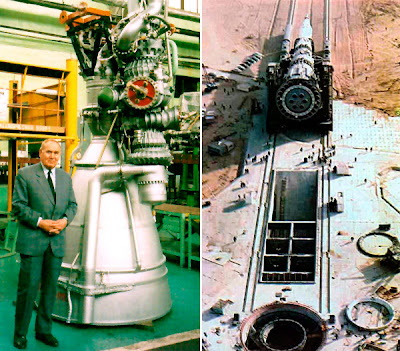

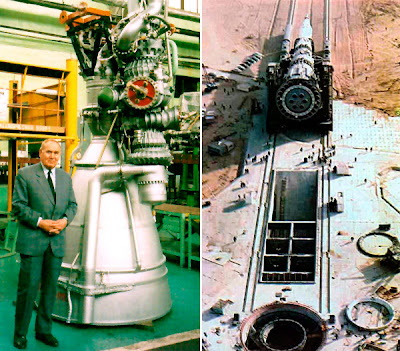

|

| Nikolái Kuznetsov, a la izquierda, con un motor NK-33 derivado del NK-15. A la derecha, un N1 es transportado hasta una de las dos rampas construidas para el programa en Baikonur. |

Pese

a todo, la OKB-276 logró diseñar en un tiempo récord el motor NK-9

(8D517) para el misil R-9, una verdadera maravilla de la ingeniería. El

NK-9 usaba un novedoso esquema de combustión por etapas (también

denominado de ciclo cerrado), gracias al cual todo el combustible y el

oxidante participan en la propulsión. Este sistema ya se había empleado

en el prototipo D-33 de la OKB-1 y permitía construir motores mucho más

eficientes que los de ciclo abierto diseñados hasta entonces. Eso sí, a

cambio de una complejidad significativamente mayor. El NK-9 sería el

primer motor cohete de ciclo cerrado rico en oxígeno de la historia, un

diseño altamente capaz pero que presenta numerosos problemas prácticos

debido a la corrosión que sufre el metal en contacto con el oxígeno a

alta presión.

A

partir del NK-9, de 38 toneladas de empuje, Kuznetsov crearía el NK-15

(11D51) para el proyecto N1, un motor de 154 toneladas de empuje que

usaba el mismo diseño avanzado de ciclo cerrado rico en oxidante. El

NK-15 sería el punto de partida de los motores NK-15V, NK-19 y NK-21

usados en el resto de etapas del cohete lunar N1. La leyenda nos cuenta

que Kuznetsov no estuvo a la altura del desafío lunar y que sus motores

terminarían siendo la causa del fracaso del N1, algo que es

completamente falso. Cuando décadas después los ingenieros

estadounidenses conocieron las prestaciones de los motores de Kuznetsov y

pensaron que no podían ser ciertas. De hecho, Estados Unidos jamás

desarrolló un motor similar creyendo que las dificultades técnicas no

compensaban el incremento en prestaciones. En los años 70 la oficina de

Kuznetsov crearía el NK-33, una versión mejorada del NK-15 que todavía

se usa en la actualidad.

Lamentablemente,

por muy bueno que fuese el trabajo de Kuznetsov, la OKB-276 carecía de

la experiencia y de las instalaciones de la oficina de Glushkó. Como

resultado, el NK-15 sólo tendría un empuje de 1500 kN, frente a los 7700

kN del motor F-1 empleado

en la primera etapa del Saturno V del programa Apolo. Para compensar el

bajo empuje del NK-15, el N1 debería hacer uso de un enorme número de

motores en su primera fase (Blok A), complicando sobremanera un diseño

de por sí bastante complejo.

Uno

de los mitos más persistentes relativos al programa lunar soviético es

que la URSS carecía de la tecnología necesaria para diseñar un motor

similar al F-1 del Saturno V. Sin embargo, a principios de los años 60

Glushkó concibió el RD-270,

un motor hipergólico con una potencia comparable a la del F-1.

Desgraciadamente el desacuerdo con Koroliov impidió que esta tecnología

se aplicase al N1. Por otro lado —como hemos visto—, los NK-15 de

Kuznetsov eran unas maravillosas piezas de ingeniería únicas en el

mundo. De haber contado con más tiempo y dinero —especialmente esto

último— no cabe duda que Kuznetsov podría haber terminado construyendo

un digno rival del F-1 estadounidense.

Cómo viajar a la Luna

Mientras

el N1 iba tomando forma, había que decidir cómo llegar a nuestro

satélite. Hasta ese momento, la mayor parte de los planes lunares

soviéticos contemplaban el uso de varios lanzamientos para ensamblar una

nave en órbita baja terrestre antes de partir hacia la Luna. Este

esquema, denominado EOR (Earth Orbit Rendezvous)

en la terminología de la NASA, permitía usar cohetes relativamente

pequeños, pero a cambio era necesario efectuar múltiples acoplamientos y

trasvases de combustible en órbita, algo considerado muy arriesgado

para la tecnología de la época.

La

otra alternativa era el ascenso directo, que requería un único

lanzamiento. El problema era que en este caso el cohete debía ser

excepcionalmente grande y, por lo tanto, increíblemente complejo y caro.

Aunque éste fue originalmente el plan elegido para el programa Apolo,

la NASA optó en 1962 por una técnica intermedia llamada LOR (Lunar Orbit Rendezvous)

que incluía acoplamientos en órbita lunar. Con LOR sólo era necesario

un lanzamiento, aunque la nave lunar debía dividirse en dos vehículos

distintos para disminuir la masa total del sistema. La NASA introdujo

así el módulo lunar (LM), una nave diseñada exclusivamente para poner

dos hombres en la superficie de nuestro satélite mientras el módulo de

mando y servicio (CSM) del Apolo esperaba en órbita con un tercer

astronauta.

Mientras

la NASA decidía su futuro, en la URSS no existía ningún plan de

alunizaje definido. Habría que esperar al 23 de septiembre de 1963 para

poder ver la primera respuesta soviética al programa Apolo, aunque sin

ningún apoyo oficial. Koroliov presentó entonces tres proyectos

distintos, llamados L1, L2 y L3. El L1 era en realidad el nuevo nombre

que recibiría el antiguo complejo 7K-9K-11K y que aún requería seis

lanzamientos del R-7 Semiorka. El L2 preveía el lanzamiento de varios

vehículos automáticos 13K, antecesores de las sondas lunares con

vehículos Lunojod. Por último, L3 debía ser la respuesta soviética al

Apolo, una respuesta que llegaba mal y tarde y sin la financiación

adecuada... pero una respuesta al fin y al cabo.

En

un principio, L3 utilizaría la técnica EOR para una misión de

alunizaje. Para ello serían necesarios tres lanzamientos del N1 y uno

del R-7 con una Soyuz tripulada. Ante la complejidad logística que

presentaba un número tan elevado de lanzamientos, Koroliov flirteó

brevemente con la idea de utilizar una nave Soyuz sin módulo orbital en

una misión de ascenso directo, pero pronto rechazó esta idea por ser

demasiado arriesgada. Al mismo tiempo, la OKB-1 propuso los proyectos L4

—para situar una nave Soyuz en órbita lunar— y L5, consistente en el

lanzamiento de un Lunojod pesado mediante un N1.

Frente

a la sencillez del plan LOR del Apolo, el programa L3 soviético

original resultaba especialmente complicado. Tras numerosas discusiones,

el 27 de julio de 1963 Koroliov y su lugarteniente, Vasili Mishin,

decidieron adoptar la técnica LOR usando un único lanzamiento del N1.

Nacía

así el proyecto N1-L3, que terminaría por convertirse en el equivalente

soviético del programa Apolo, aunque no sería aprobado formalmente

hasta un año más tarde. Los motivos que provocaron este cambio de EOR a

LOR siguen sin estar nada claros en la actualidad, aunque parece ser que

la decisión de la NASA tuvo una gran influencia en la opinión de

Koroliov.

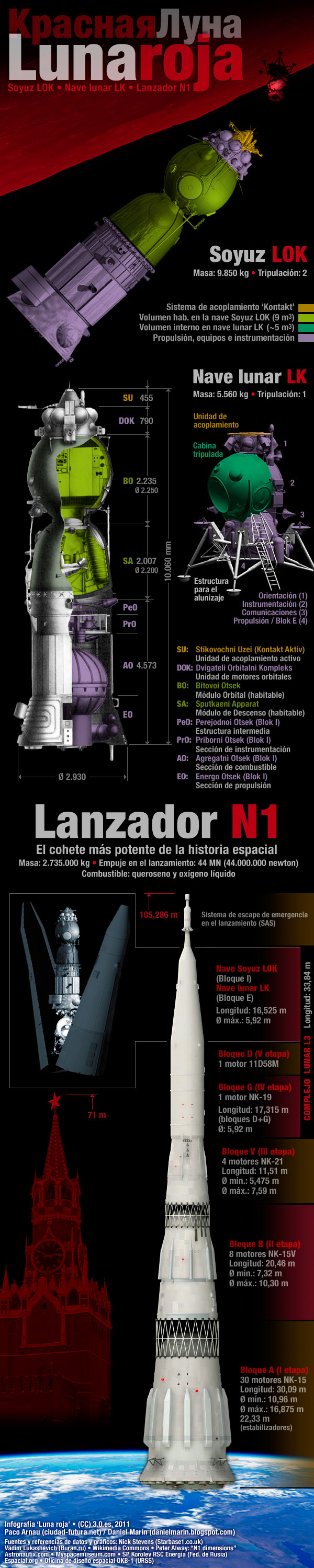

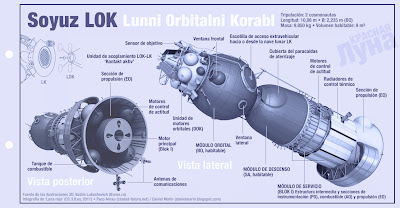

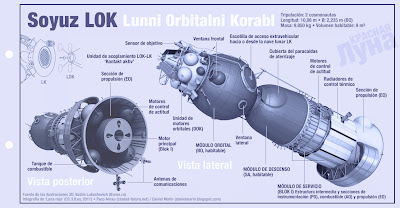

Al

igual que el programa Apolo, N1-L3 preveía utilizar dos naves

distintas, el módulo lunar LK y la Soyuz LOK. La LOK (Лунный Орбитальный

Корабль; Lunni Orbitalni Korabl,

"nave orbital lunar") u 11F93 era una Soyuz dotada de un módulo de

servicio más grande y con mayor capacidad de combustible. A diferencia

de la Soyuz 7K-OK orbital usaría células de combustible para generar

electricidad en vez de paneles solares. En su parte superior dispondría

de un módulo propulsivo adicional denominado DOK para maniobras

orbitales. El LK (Лунный Корабль; Lunni Korabl,

"nave lunar") u 11F94 era un módulo lunar con una cápsula presurizada

de forma esférica y con dos motores de 2,05 toneladas de empuje: un

motor principal RD-858 —con una sola cámara con capacidad para regular

el empuje— y un motor de reserva RD-859 —con dos cámaras y de empuje

fijo—. Ambos motores formarían el llamado Blok E (o Blok Ye). A

diferencia del Apolo y para simplificar el diseño, la misión N1-L3

tendría una tripulación de dos cosmonautas. Sólo uno de ellos

descendería hasta la superficie lunar, algo que suponía un riesgo

considerable. Además del LK y la Soyuz LOK, el N1-L3 utilizaría una fase

adicional denominada Blok D para entrar en órbita lunar y descender

hasta la superficie con el módulo lunar LK.

Una típica misión N1-L3 seguiría las siguientes etapas:

- El

cohete N1 despegaría desde Baikonur con dos cosmonautas dentro de la

Soyuz LOK, situada en el extremo superior del cohete. El módulo LK

estaría situado bajo el LOK en el interior de un compartimento

cilíndrico durante todo el viaje hasta la Luna.

- Pocos

minutos después del despegue, el N1 situaría en órbita baja terrestre

al Blok G y al conjunto N1-L3 (formado por la Soyuz LOK, el LK y el Blok

D), con una masa total de 92 toneladas como mínimo.

- La

cuarta etapa del N1, el Blok G, encendería su motor NK-19 durante 480

segundos para situar al conjunto N1-L3 en una trayectoria lunar.

- Cuando

el complejo sobrevolase la cara oculta de la Luna, el Blok D se

encendería para frenar el conjunto en órbita lunar. Después realizaría

varios encendidos para circularizar la órbita.

- Para

ahorrar peso, las dos naves no estarían comunicadas por un túnel como

en el Apolo, así que el cosmonauta que debía descender a la Luna se

pondría un traje espacial Krechet ("halcón") y realizaría una actividad

extravehicular (EVA) para ir desde LOK hasta el LK. El segundo

cosmonauta usaría un traje Orlán ("águila") para ayudarle en la tarea si

fuera necesario.

- Tras

comprobar que los sistemas funcionan correctamente, el LK con el Blok D

se alejaría de la LOK y comenzaría el descenso hacia la superficie

lunar mediante un encendido continuo de su motor. Antes de alunizar

tendría lugar una maniobra altamente arriesgada, considerada por muchos

como el talón de Aquiles de la misión. A tan sólo 1,5-2 kilómetros de

altura, el Blok D se separaría del LK para estrellarse contra la

superficie. Al mismo tiempo, los motores principales del LK debían

encenderse para realizar la fase final de descenso. El cosmonauta sólo

tendría 25 segundos para controlar la nave y buscar un lugar para

aterrizar antes de que se agotase el combustible.

- Una

vez en la superficie el cosmonauta podría realizar una única EVA de

hasta seis horas de duración para explorar los alrededores y plantar la

bandera soviética sobre el suelo lunar. El LK estaba dotado con un

taladro y otros instrumentos para estudiar la superficie desde el

interior de la cabina.

- Terminada

la misión, el Blok E del LK se encendería otra vez y la nave se

elevaría hasta la órbita usando la estructura de aterrizaje como

plataforma de lanzamiento. Una vez en órbita, el LK se acoplaría con la

Soyuz LOK gracias al sistema Kontakt y el cosmonauta realizaría otra

EVA, esta vez con las rocas lunares, para pasar del LK a la LOK.

- Por

último, la Soyuz LOK encendería el Blok I (formado por un motor 5D51 de

3,388 toneladas de empuje) para abandonar la órbita lunar. Unos tres

días más tarde la cápsula reingresaría en la atmósfera terrestre sobre

el Océano Índico a 11,2 km/s, aterrizando finalmente en territorio

soviético después de una reentrada doble.

|

| Los 30 motores NK-15 de la primera etapa (Blok A) del N1. |

Además

de una grave falta de redundancia, el mayor problema al que se

enfrentaba el plan N1-L3 era la masa. Las escasas 75 toneladas de

capacidad del gran cohete N1 hacían casi imposible llevar a cabo una

misión de tipo LOR. Koroliov y Serguéi Kriukov, el responsable del

diseño del N1 dentro de la OKB-1, iniciaron entonces un programa de

choque para aumentar la capacidad de carga del cohete hasta las 92-95

toneladas en órbita baja, consideradas lo mínimo para una misión LOR en

condiciones. Para ello se incrementó el ya de por sí elevado número de

motores NK-15 de la primera etapa de 24 a 30 unidades. Al mismo tiempo

se introdujo el sistema automático KORD para controlar el funcionamiento

de esta pléyade

de motores. En caso de que algún motor fallase, el sistema KORD debía

redistribuir el empuje de las restantes unidades para evitar que el

cohete se saliese de su rumbo.

Con

el fin de ahorrar peso los tanques de combustible tendrían forma

esférica, un novedoso diseño que le daría al N1 una inconfundible

apariencia cónica. Esta decisión estaba motivada por las limitaciones de

la industria metalúrgica soviética de la época, incapaz de producir

láminas de aluminio de más de 13 milímetros de grosor.

Debido

a su gran tamaño no se podían mandar hasta el cosmódromo las piezas del

N1 por ferrocarril como en el caso de otros lanzadores; así que se

decidió ensamblarlo en Baikonur en posición horizontal dentro de un

gigantesco edificio de montaje (MIK-112) construido ex profeso (el equivalente al VAB de la NASA en el Centro Espacial Kennedy).

La indiferencia del gobierno

Más allá de las disputas infantiles

entre ingenieros, el principal responsable del retraso del programa

lunar soviético fue el propio gobierno. Mientras el proyecto Apolo

pronto contó con una organización centralizada y recursos financieros

más que adecuados para el programa lunar, a principios de 1964 la Unión

Soviética aún carecía de un plan oficial para alcanzar la Luna. La

financiación del programa N1 era claramente insuficiente comparada con

el Apolo, pero lo peor fue que el gobierno permitió que otras oficinas

de diseño —especialmente la OKB-52 de Vladímir Cheloméi— siguieran

adelante con planes lunares alternativos, derrochando así los escasos

recursos disponibles y creando una enorme confusión en el plano

organizativo.

El

3 de agosto de 1964 —tres años más tarde que en Estados Unidos—

llegaría por fin la tan esperada aprobación gubernamental al programa

lunar soviético. Sin embargo, lejos de poner orden, el secretario

general Jruschov complicó aún más el panorama espacial al transferir el

programa L1 de Koroliov a la OKB-52. Vladímir Cheloméi proponía lanzar

su nave LK-1 alrededor de la Luna usando un único lanzamiento del nuevo

cohete UR-500K Protón frente a los seis cohetes Semiorka

requeridos por la OKB-1 para lograr el mismo objetivo. El jefe de la

OKB-52 se había convertido en el niño mimado de Jruschov y la decisión

del premier había

que interpretarla como un triunfo más de Cheloméi en su vertiginoso

ascenso hacia el control del programa espacial soviético.

Como resultado, en 1964 la URSS no tiene uno, sino dos programas

lunares: el L1 de Cheloméi para sobrevuelos lunares y el programa de

alunizaje N1-L3 de Koroliov. Pero lo cierto es que, a pesar de la

aprobación oficial, prácticamente no se destinan fondos adicionales para

el N1-L3. Para empeorar las cosas, el gobierno decidió seguir adelante

con el programa Vosjod (naves Vostok modificadas) con el fin de llevar a

cabo varias misiones de gran impacto mediático.

La infografía que véis arriba la realizó Daniel Marín para un artículo titulado “Cuestión de prioridades” en el que intentaba desmitificar esa idea tan extendida de que la exploración espacial es cara. Para ello comparaba los presupuestos de los equipos de fútbol de la liga española con el presupuesto de la agencia espacial Rusa en el año 2010.

La infografía que véis arriba la realizó Daniel Marín para un artículo titulado “Cuestión de prioridades” en el que intentaba desmitificar esa idea tan extendida de que la exploración espacial es cara. Para ello comparaba los presupuestos de los equipos de fútbol de la liga española con el presupuesto de la agencia espacial Rusa en el año 2010.